Принцип максимального правдоподобия | это… Что такое Принцип максимального правдоподобия?

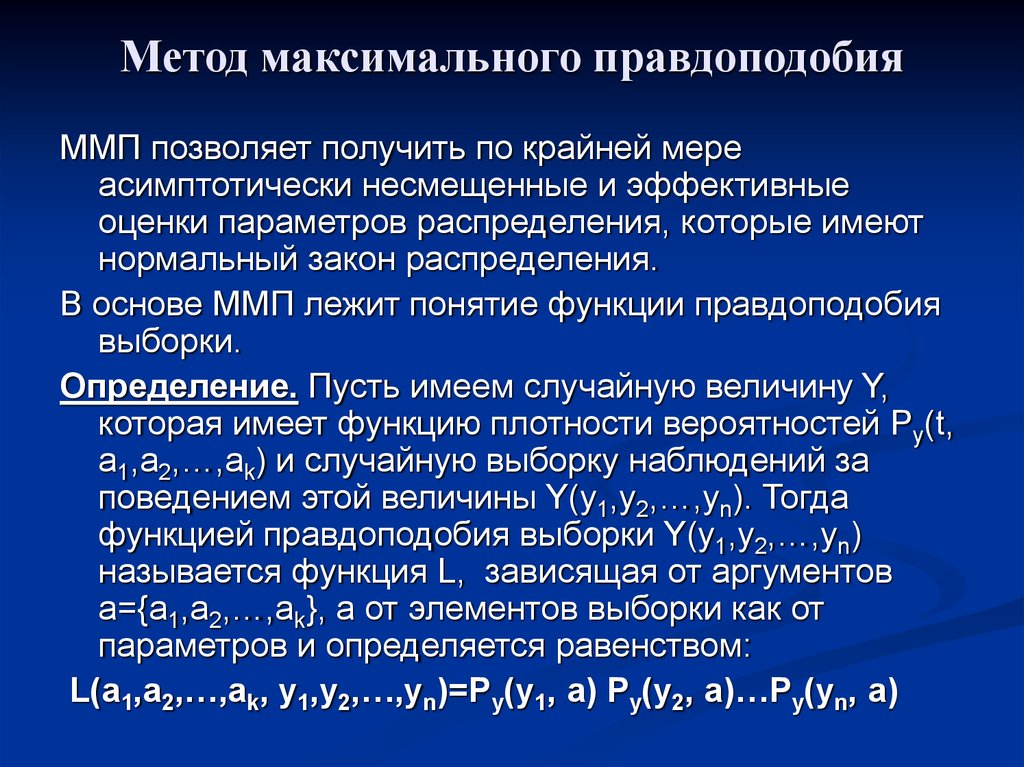

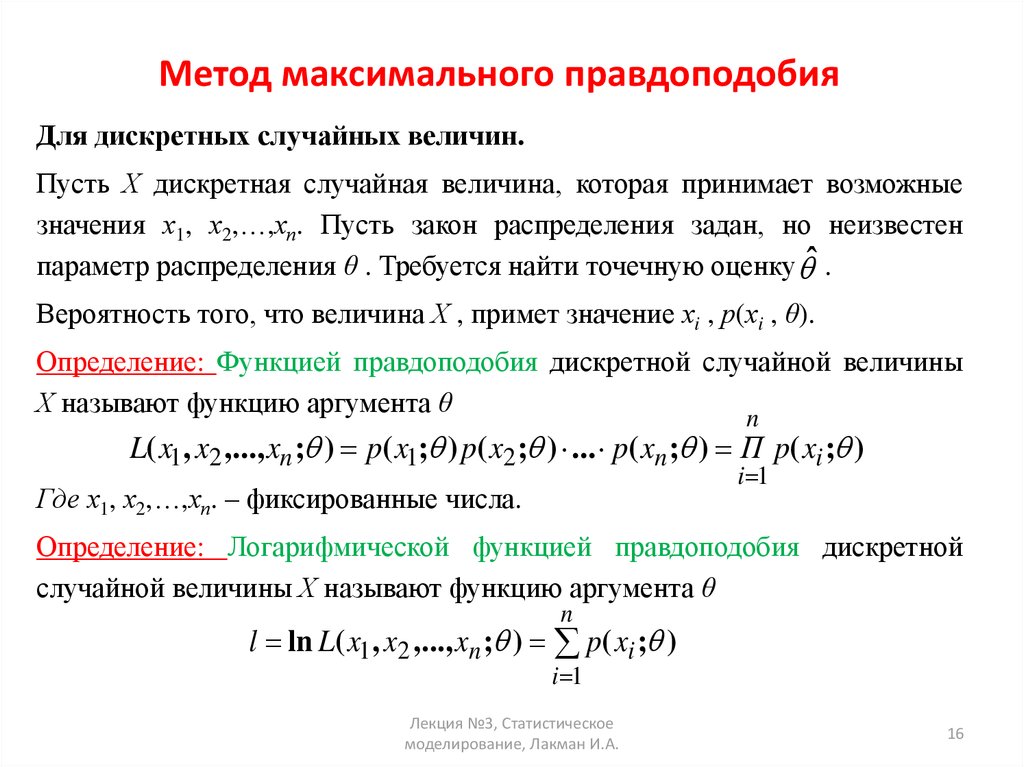

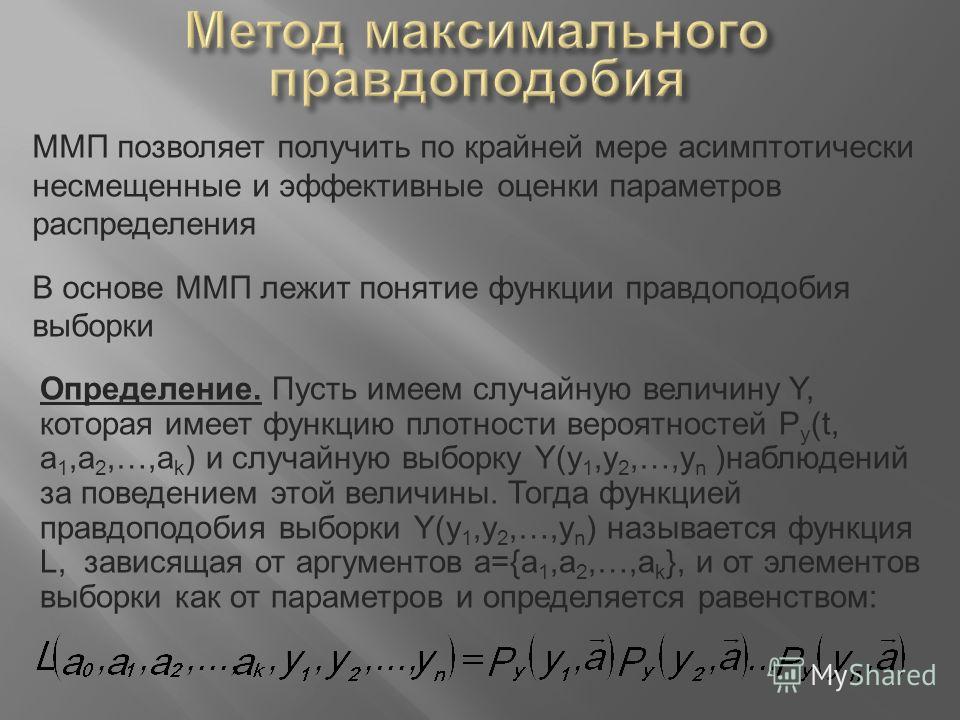

Принцип максимального правдоподобия является спорным принципом статистического вывода, который предполагает, что вся информация о статистической выборке содержится в функции правдоподобия.

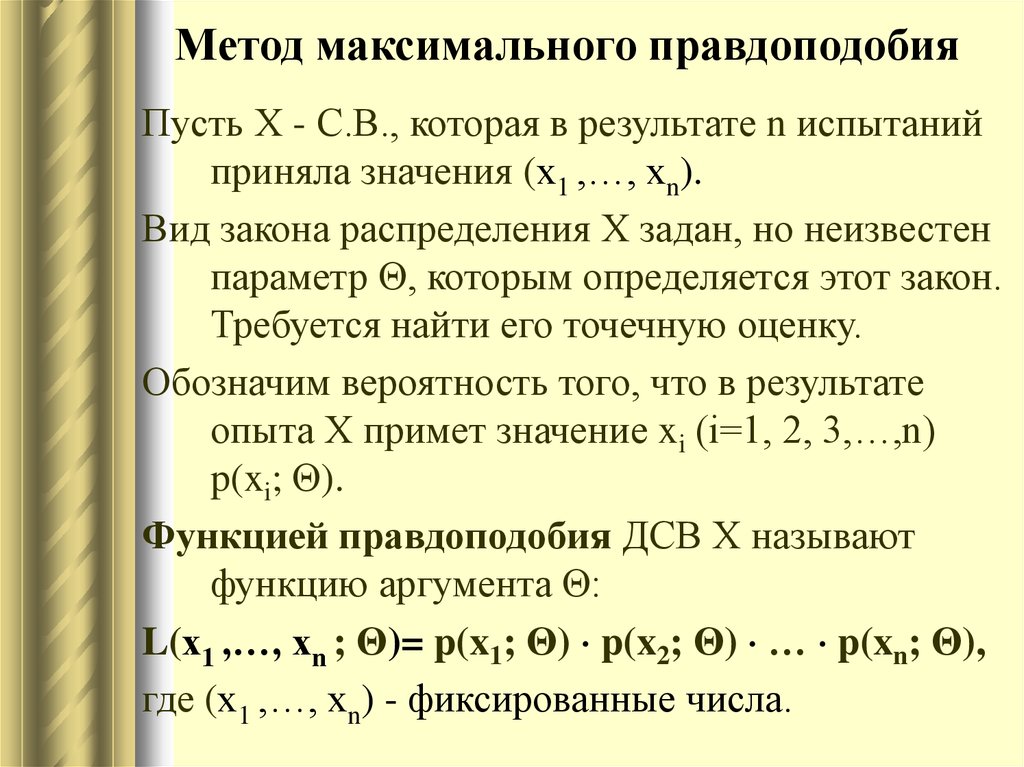

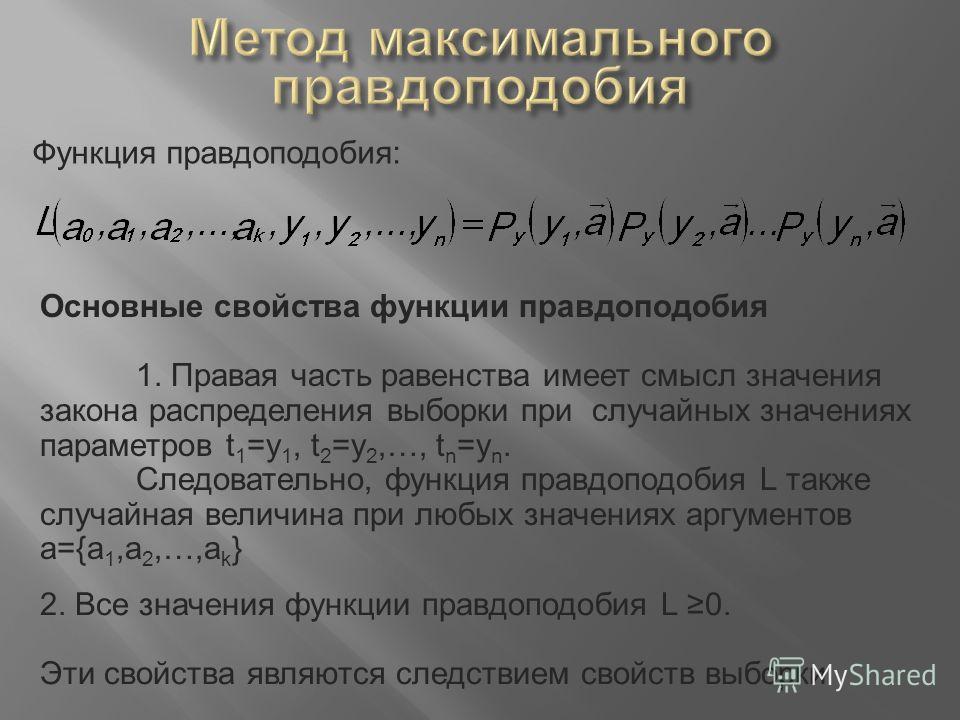

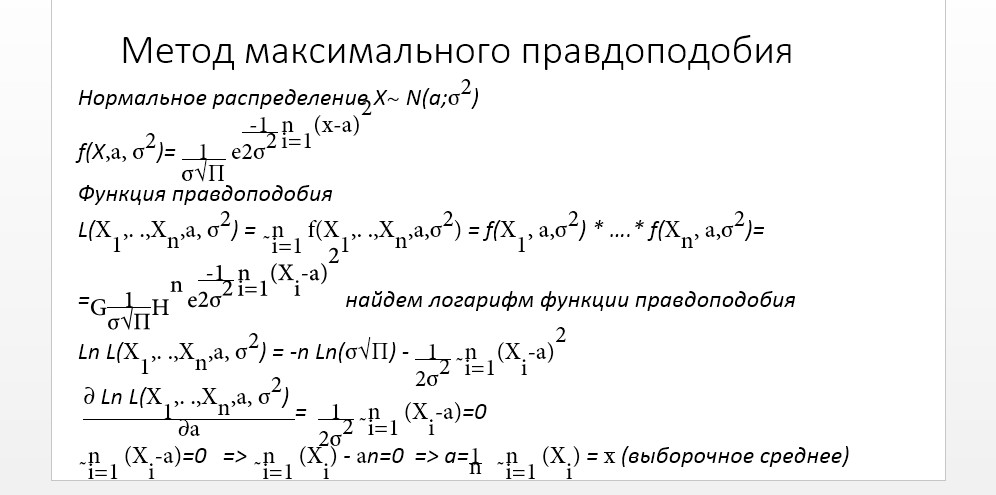

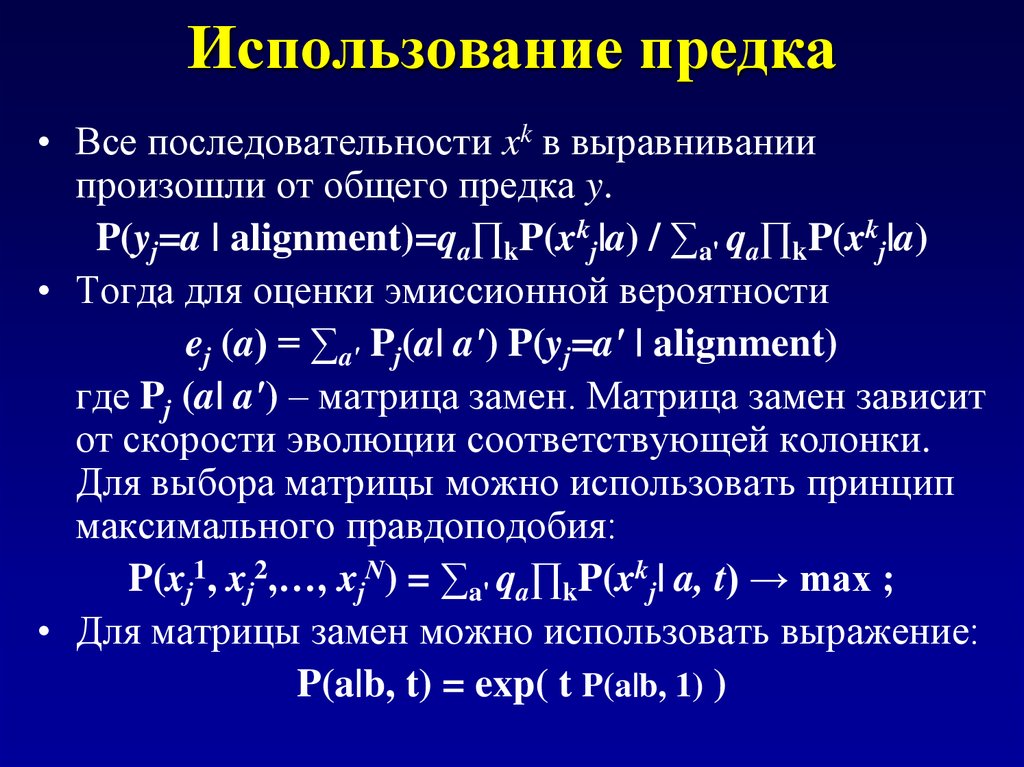

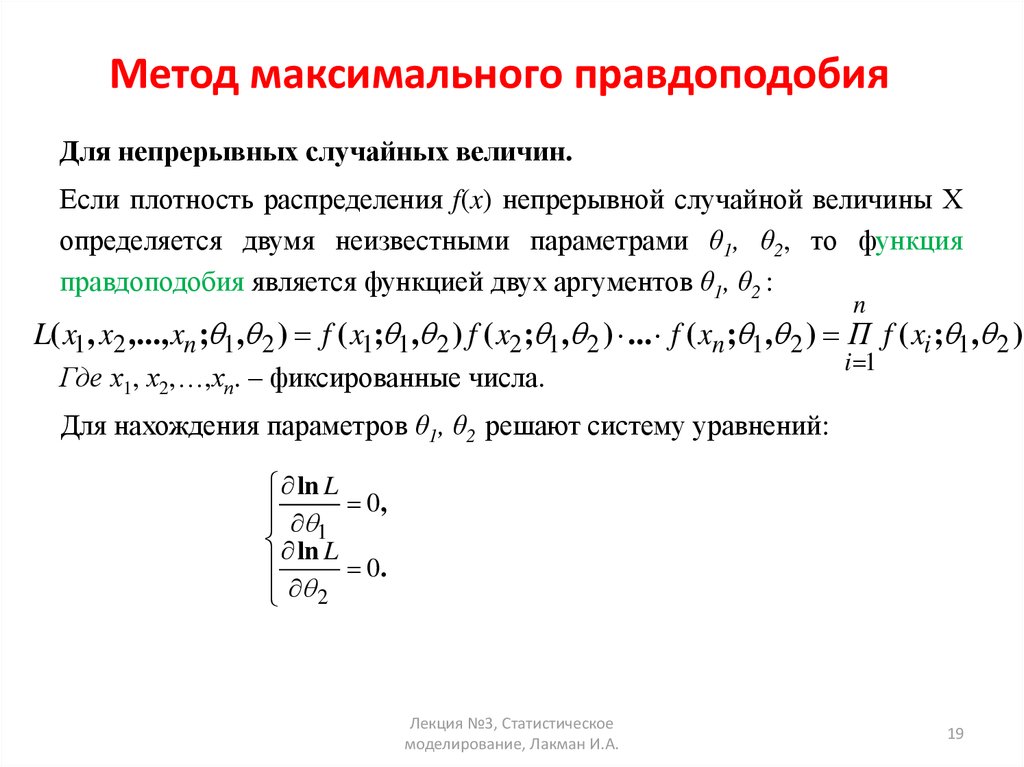

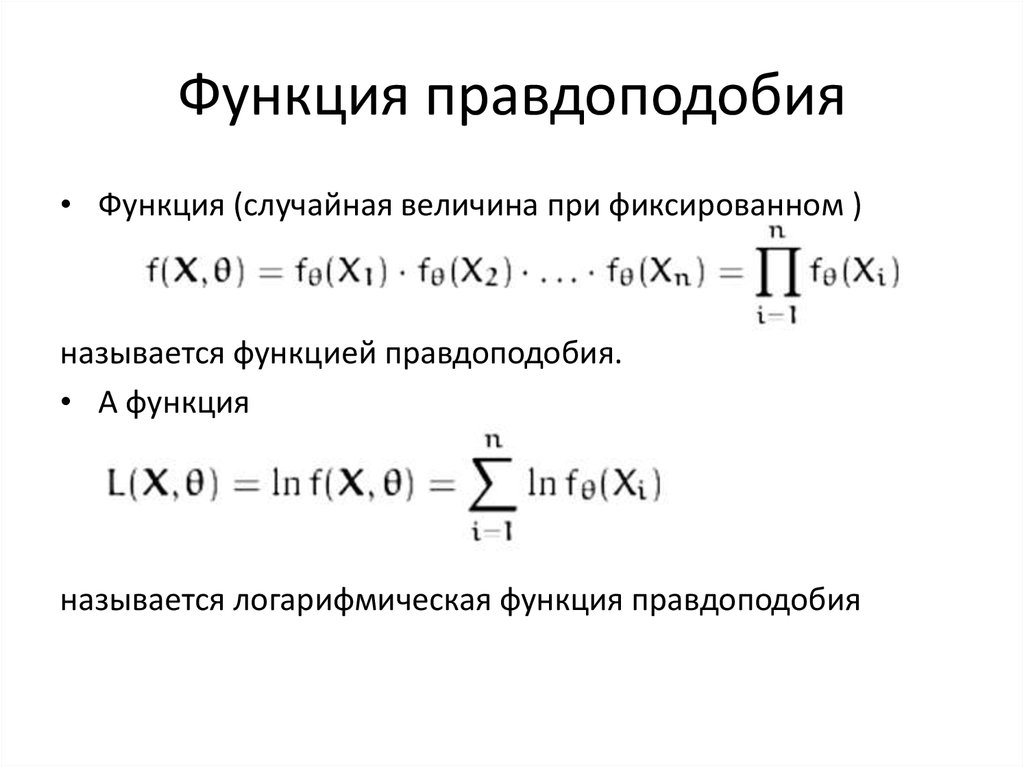

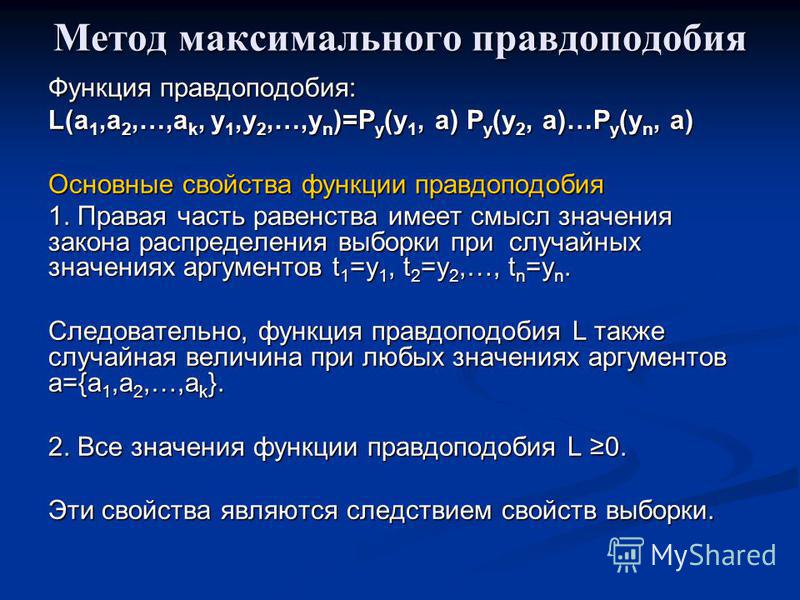

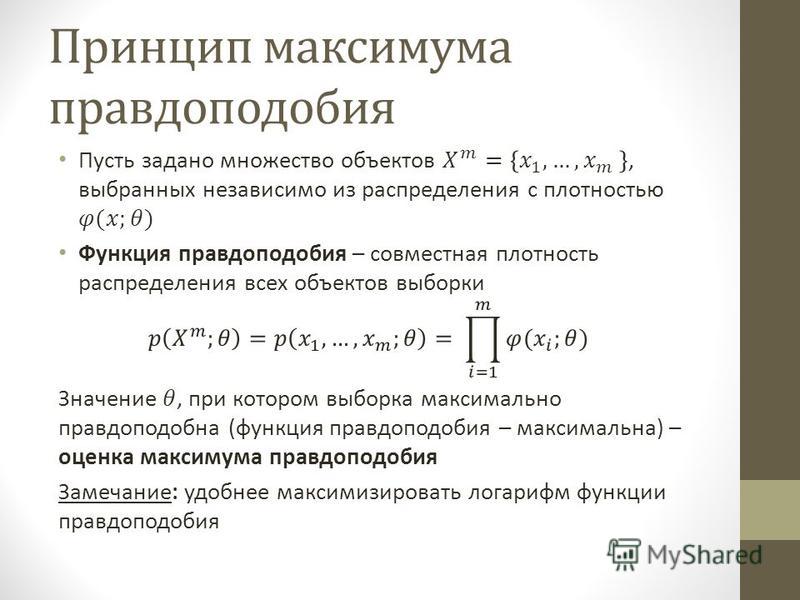

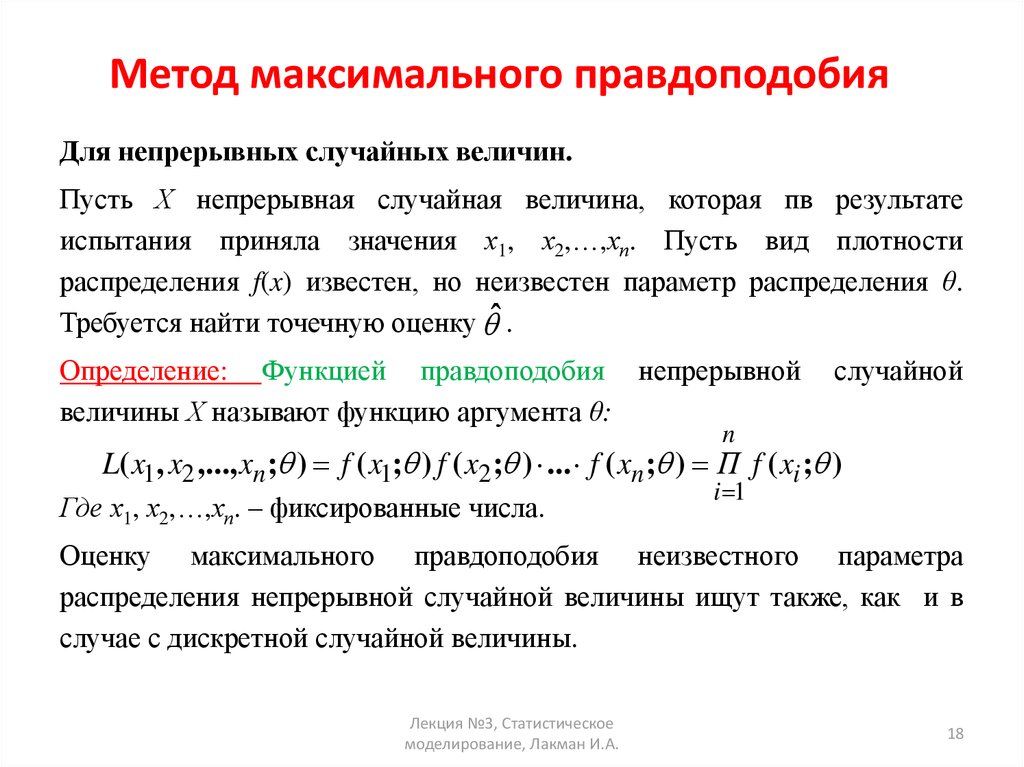

Функция правдоподобия основывается на условной вероятности взятием ее как функции от второго аргумента при фиксировании первого. Например рассмотрим модель в которой плотность вероятности случайной величины X зависит от параметра θ. Тогда для некоторого конкретного значения x случайной величины X функция L(θ | x) = P(X=x | θ) и есть функция правдоподобия θ, определяющая насколько правдоподобно каждое конкретное значение параметра θ при условии, что нам известно значение x величины X. Две функции правдоподобия являются равными, если одна есть произведение второй на некоторую скалярную величину.

Содержание

|

Пример

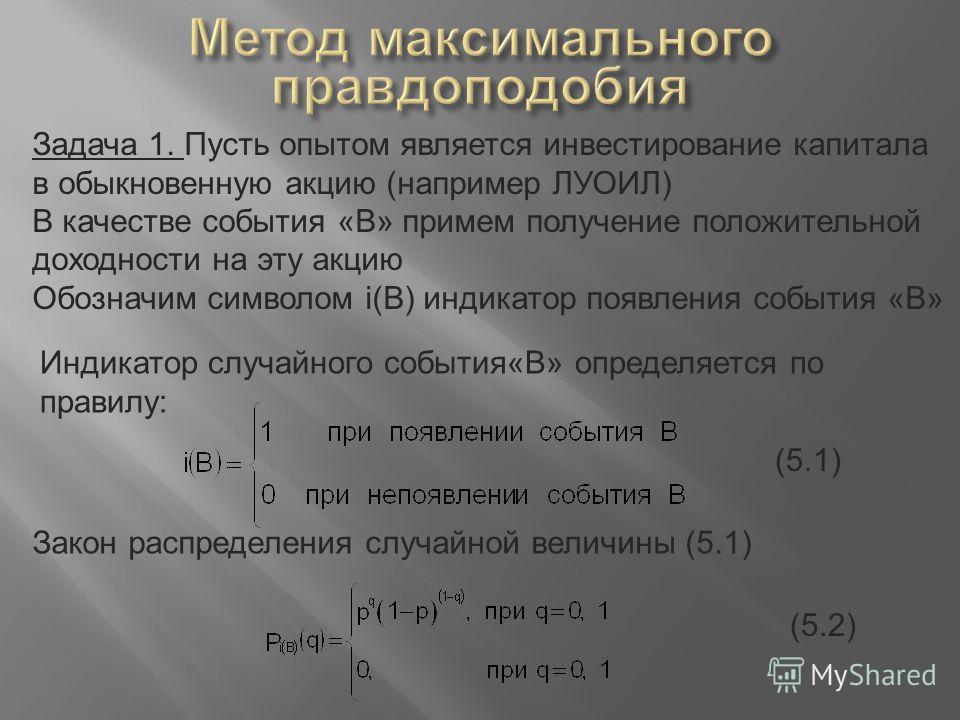

Рассмотрим случайные величины

- X количество успехов в двенадцати независимых испытаний с распределением Бернулли с вероятностью успеха θ в каждом из них.

- Y количество независимых испытаний с распределением Бернулли, необходимых для получения трех успехов. Вероятность успеха в каждом из испытаний θ.

Тогда рассмотрение X = 3 даст функцию правдоподобия

а рассмотрение Y = 12 даст функцию правдоподобия

Они равносильны, так как одна равняется произведению второй на скалярное значение. Принцип максимального правдоподобия в данном случае говорит, что выводы, сделанные о значении переменной θ должны быть одинаковы в обоих случаях.

Разница в наблюдении X = 3 и наблюдении Y = 12 исключительно в дизайне эксперимента: в одном случае изначально было решено делать двенадцать попыток, а в другом делать попытки, пока не будет трех успешных. Результат будет одинаковым в обоих случаях. Поэтому принцип максимального правдоподобия иногда выражают следующим образом:

Результат будет одинаковым в обоих случаях. Поэтому принцип максимального правдоподобия иногда выражают следующим образом:

- Вывод должен зависеть только от исхода эксперимента, а не от дизайна эксперимента.

Закон максимального правдоподобия

Связанная с принципом максимального правдоподобия концепция — это закон максимального правдоподобия, говорящий, что отношение того, какое значение параметра более применимо, равняется отношению их функций правдоподобия. Тогда отношение

является мерой того, насколько величина

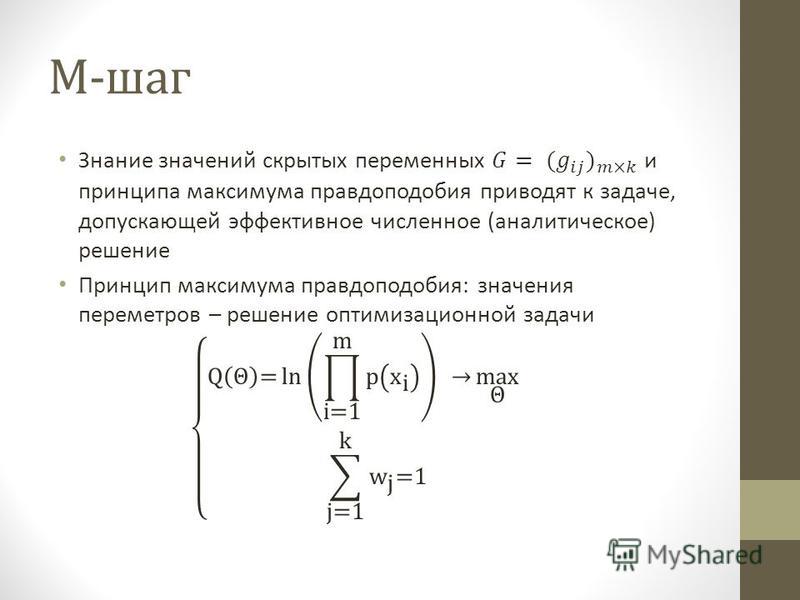

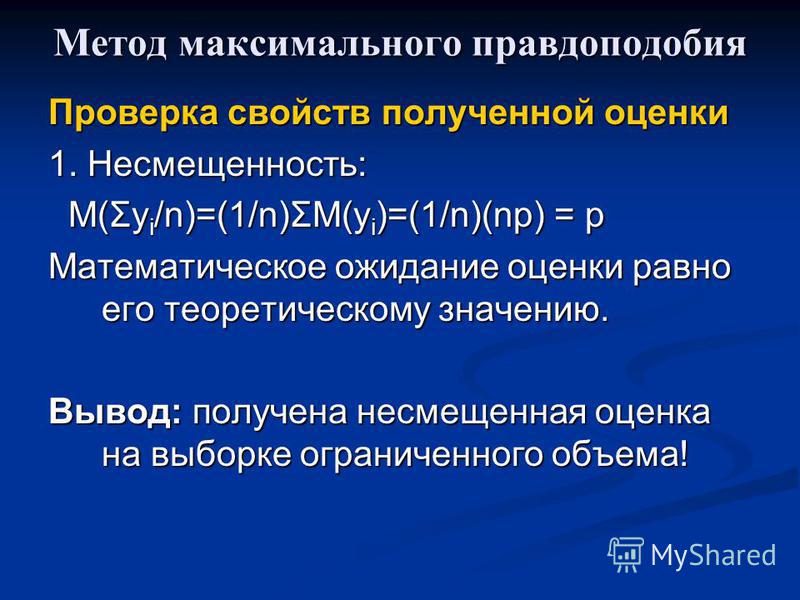

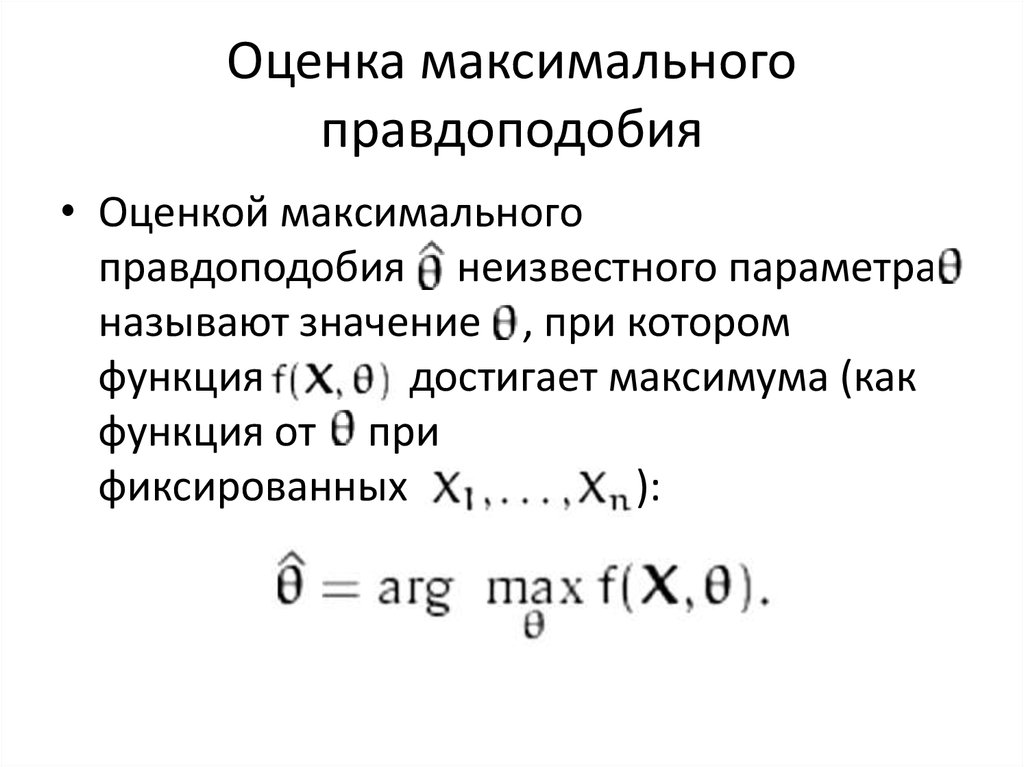

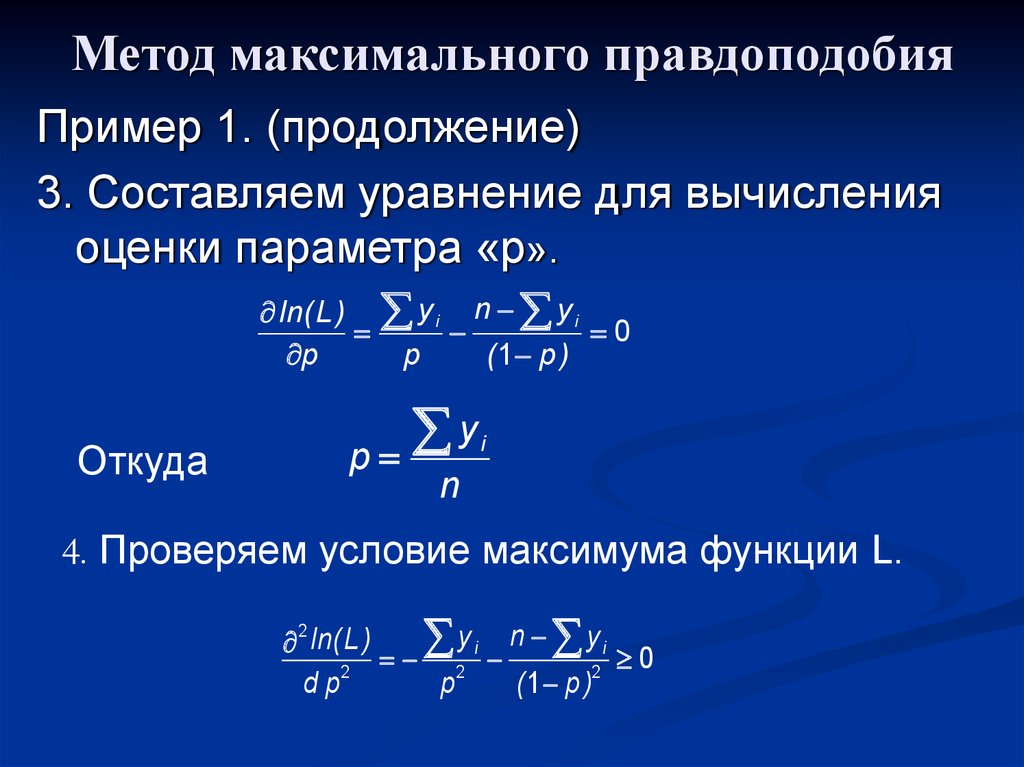

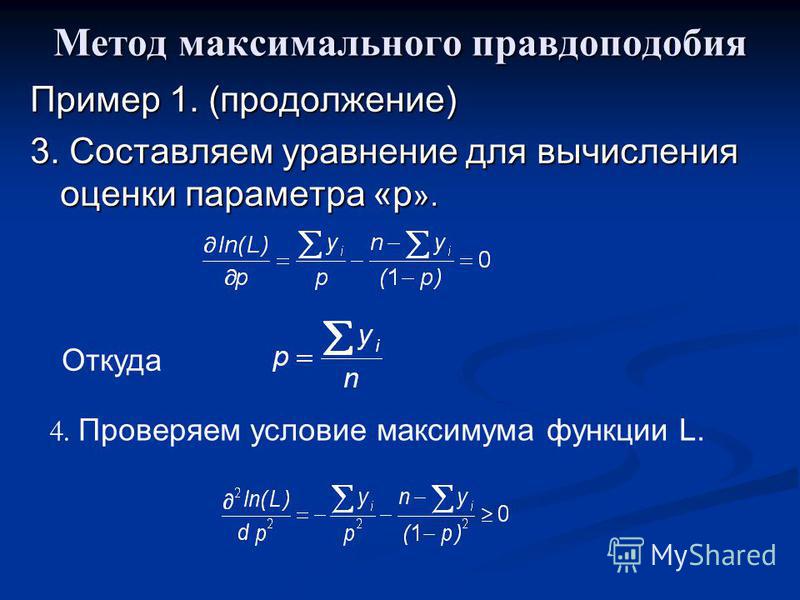

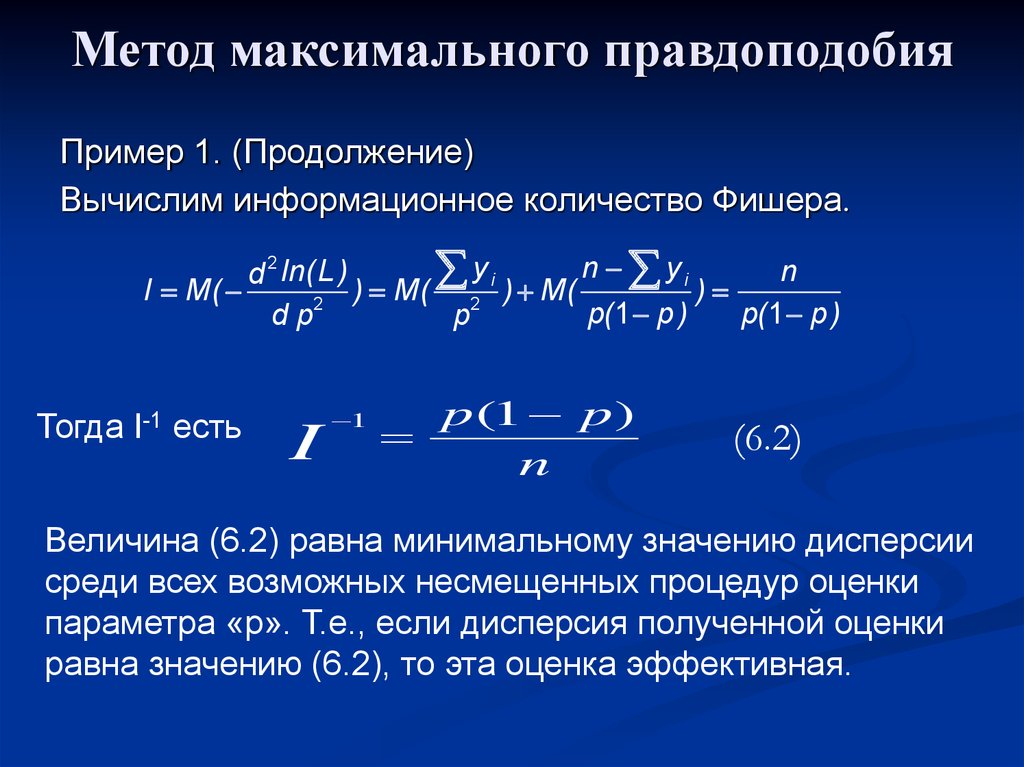

Из принципа максимального правдоподобия и закона максимального правдоподобия следует, что параметр, который максимизирует функцию правдоподобия, является лучшим. Это и является основой широко известного метода максимального правдоподобия.

Историческая справка

Принцип максимального правдоподобия был впервые упомянут в печати в 1962 г. Однако основы принципа и применение его на практике были опубликованы ранее в работах Р. А. Фишера в 1920 г.

Аргументы за и против принципа максимального правдоподобия

Принцип максимального правдоподобия принимается не всеми. Некоторые широко используемые методы традиционной статистики, как например проверка статистических гипотез противоречат принципу максимального правдоподобия. Рассмотрим кратко некоторые за и против этого принципа.

Зависимость результата от организации эксперимента

Неосуществленные события действительно играют роль в некоторых общих статистических методах. Например результат проверки статистической гипотезы может зависеть от доверительной вероятности так же или даже более, чем распределение неизвестного параметра. А сама доверительная вероятность может зависеть организации эксперимента.

Некоторые классичекие методы проверки гипотез базируются не на правдоподобии. Часто приводимый пример это проблема оптимальной остановки. Предположим я сказал, что бросил монету 12 раз и получил 3 решки. Из этого вы сможете сделать некоторые выводы о вероятности выпадения решки у этой монеты. А теперь предположим, что я бросал монету пока решка не выпала 3 раза, и получилось 12 бросков. Сделаете ли вы теперь другие выводы?

Часто приводимый пример это проблема оптимальной остановки. Предположим я сказал, что бросил монету 12 раз и получил 3 решки. Из этого вы сможете сделать некоторые выводы о вероятности выпадения решки у этой монеты. А теперь предположим, что я бросал монету пока решка не выпала 3 раза, и получилось 12 бросков. Сделаете ли вы теперь другие выводы?

Функция правдоподобия одинакова в обоих случаях и пропорциональна

- .

В соответствии с принципом правдоподобия выводы должны быть одинаковы в обоих случаях.

Предположим некоторая группа ученых определяет вероятность некоторого исхода (который мы будем называть ‘успехом’) серией экспериментов. Здравый смысл подсказывает нам, что если нет оснований считать что успех более вероятен, чем неудача, и наоборот, то следует положить вероятность успеха равной 0.5. Ученый Адам сделал 12 испытаний, в которых получил 3 успеха и 9 неудач, после чего умер.

Его коллега по лаборатории Билл продолжил работу Адама и опубликовал результат проверки гипотезы. Он проверил гипотезу что вероятность успеха p=0.5 против p < 0.5. Вероятность того, что в 12 испытаниях наступит не более 3 успехов, равна

Он проверил гипотезу что вероятность успеха p=0.5 против p < 0.5. Вероятность того, что в 12 испытаниях наступит не более 3 успехов, равна

что есть 299/4096 = 7.3 %. Таким образом гипотеза не отвергается при 5 % уровне доверия.

Шарлотта, прочитав статью Билла, пишет письмо. Она считает, что Адам, возможно, продолжал испытания пока не умер, успев получить к этому моменту 3 успеха. Вероятность того, что для трех успехов потребуется 12 или более испытаний равна

что есть 134/4096 = 3.27 %. И теперь результат отвергается при уровне в 5 %.

Для этих ученых зависимость результата испытаний зависит от организации эксперимента, а не только от правдоподобия результата.

Очевидно, парадоксы такого рода некоторые считают аргументом против принципа правдоподобия, для других они же иллюстрирует значимость принципа.

Литература

- Barnard, G.A.; G.M. Jenkins, and C.B. Winsten (1962).

«Likelihood Inference and Time Series». J. Royal Statistical Society, A 125 (3): 321-372. ISSN 0035-9238.

«Likelihood Inference and Time Series». J. Royal Statistical Society, A 125 (3): 321-372. ISSN 0035-9238. - J.O. Berger The Likelihood Principle. — 2nd edition. — Haywood, CA: The Institute of Mathematical Statistics, 1988. — ISBN 0-940600-13-7

- Birnbaum, Allan (1962). «On the foundations of statistical inference». J. Amer. Statist. Assoc. 57 (298): 269-326. ISSN 0162-1459. (With discussion.)

- Anthony W.F. Edwards Likelihood. — 1st edition. — Cambridge: Cambridge University Press, 1972.

- Anthony W.F. Edwards Likelihood. — 2nd edition. — Baltimore: Johns Hopkins University Press, 1992. — ISBN 0-8018-4445-2

- Edwards, Anthony W.F. (1974). «The history of likelihood». Int. Statist. Rev. 42 (1): 9-15. ISSN 0306-7734.

- Fisher, Ronald A. (1922). «On the Mathematical Foundations of Theoretical Statistics» (Phil.

Trans. Royal Soc. A 222: 326. DOI:10.1098/rsta.1922.0009. ISSN 0264-3952.

Trans. Royal Soc. A 222: 326. DOI:10.1098/rsta.1922.0009. ISSN 0264-3952. - Ian Hacking Logic of Statistical Inference. — Cambridge: Cambridge University Press, 1965. — ISBN 0-521-05165-7

- Harold Jeffreys The Theory of Probability. — The Oxford University Press, 1961.

- Richard M. Royall Statistical Evidence: A Likelihood Paradigm. — London: Chapman & Hall, 1997. — ISBN 0-412-04411-0

- Leonard J. Savage The Foundations of Statistical Inference. — London: Methuen, 1962.

См. также

- Функция правдоподобия.

- Метод максимального правдоподобия.

Ссылки

- Anthony W.F. Edwards. «Likelihood». http://www.cimat.mx/reportes/enlinea/D-99-10.html

- Jeff Miller. Earliest Known Uses of Some of the Words of Mathematics (L)

- John Aldrich. Likelihood and Probability in R. A. Fisher’s Statistical Methods for Research Workers

Нелинейное оценивание параметров

Нелинейное оценивание параметров

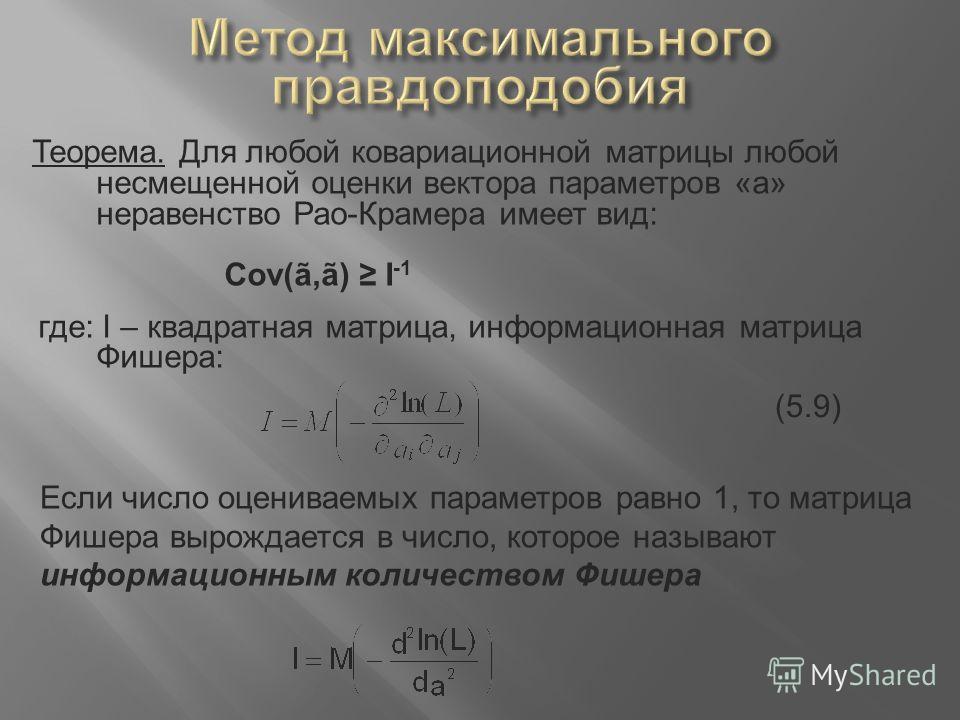

ОглавлениеПРЕДИСЛОВИЕ К РУССКОМУ ИЗДАНИЮПРЕДИСЛОВИЕ Глава I. ВВЕДЕНИЕ 1.1. Подбор кривой 1.2. Подгонка модели 1.3. Оценивание 1.4. Линейность 1.5. Точечное и интервальное оценивание 1.6. Историческая справка 1.7. Обозначения Глава II.  ФОРМУЛИРОВКА ЗАДАЧИ ФОРМУЛИРОВКА ЗАДАЧИА. ДЕТЕРМИНИСТИЧЕСКИЕ МОДЕЛИ 2.2. Структурная модель 2.3. вычисление параметров 2.4. Приведенная модель 2.5. Области применения Б. ДАННЫЕ 2.6. Эксперименты и матрица данных В. ВЕРОЯТНОСТНЫЕ МОДЕЛИ И ФУНКЦИЯ ПРАВДОПОДОБИЯ 2.8. Нормальное распределение 2.9. Равномерное распределение 2.10. Распределение ошибок 2.11. Стохастическая форма модели 2.12. Функция правдоподобия для стандартной приведенной модели 2.13. Функция правдоподобия для структурных моделей 2.14. Пример 2.15. Использование предположений о законе распределения Г. АПРИОРНАЯ ИНФОРМАЦИЯ И АПОСТЕРИОРНОЕ РАСПРЕДЕЛЕНИЕ 2.19. Теорема Байеса Глава III. ОЦЕНКИ ПАРАМЕТРОВ И ИХ СВОЙСТВА 3.2. Свойства выборочного распределения 3.3. Оценка статистических характеристик Б. МАТЕМАТИЧЕСКИЕ АСПЕКТЫ 3.5. Оптимизация без ограничений 3.6. Ограничения типа равенств 3.  7. Ограничения типа неравенств 7. Ограничения типа неравенствГлава IV. МЕТОДЫ ОЦЕНИВАНИЯ А. МЕТОД НАИМЕНЬШИХ КВАДРАТОВ 4.3. Метод наименьших квадратов со взвешиванием измерений 4.4. Множественная линейная регрессия Б. ПРИНЦИП МАКСИМУМА ПРАВДОПОДОБИЯ 4.6. Уравнения правдоподобия 4.7. Нормальное распределение 4.8. Неизвестная диагональная ковариационная матрица 4.9. Неизвестная общая ковариационная матрица 4.10. Случай наличия ошибок в независимых переменных 4.11. Точные структурные модели 4.12. Требования к данным 4.13. Другие виды распределений В. БАЙЕСОВСКОЕ ОЦЕНИВАНИЕ 4.15. Мода апостериорного распределения 4.16. Оценки минимального риска Г. ДРУГИЕ МЕТОДЫ 4.17. Метод минимакса 4.18. Метод псевдомаксимального правдоподобия 4.19. Линеаризующие преобразования 4.20. Метод минимума хи-квадрат Глава V. ВЫЧИСЛЕНИЕ ОЦЕНОК I: ЗАДАЧИ БЕЗ ОГРАНИЧЕНИЙ 5.2. Итерационная процедура 5.3. Концепция допустимости 5.4. Сходимость 5.  5. Метод наискорейшего спуска 5. Метод наискорейшего спуска5.6. Метод Ньютона 5.7. Метод выбора направления 5.8. Метод Марквардта 5.9. Метод Гаусса 5.10. Метод Гаусса как последовательность линейных регрессионных задач 5.11. Реализация метода Гаусса 5.12. Методы переменной метрики 5.13. размер шага 5.14. Метод интерполяции — экстраполяции 5.15. Условие останова 5.16. Замечания, касающиеся сходимости 5.17. Методы без вычисления производных 5.18. Конечные разности 5.19. Методы прямого поиска 5.20. Начальные приближения 5.21. Однооткликовая задача наименьших квадратов 5.22. Учет априорной информации 5.23. Двухоткликовая задача максимума правдоподобия Глава VI. ВЫЧИСЛЕНИЕ ОЦЕНОК II: ЗАДАЧИ С ОГРАНИЧЕНИЯМИ 6.2. Проекционные методы 6.3. Проекции при ограничениях на параметры 6.4. Преобразование переменных 6.5. Минимаксные задачи Б. ОГРАНИЧЕНИЯ ТИПА РАВЕНСТВ 6.7. Контроль сходимости 6.8. Некоторый особые случаи 6.9.  Штрафные функции Штрафные функции6.10. Линейные ограничения типа равенств 6.12. Метод наименьших квадратов — метод проекции 6.13. Ошибки у независимых переменных 6.14. Модель, заданная в неявной форме Глава VII. ИНТЕРПРЕТАЦИЯ ОЦЕНОК 7.2. Методы интерпретации по виду поверхности отклика 7.3. Канонический вид 7.4. Выборочное распределение 7.5. Ковариационная матрица оценок 7.6. Точная структурная модель 7.7. Ограничения 7.8. Главные компоненты 7.9. Доверительные интервалы 7.10. Доверительные области 7.11. Линеаризация 7.12. Апостериорное распределение 7.13. Остатки 7.14. Ошибки у независимых переменных 7.15. Адекватность модели 7.16. Критерии, основанные на остатках 7.17. Серии в наблюдениях и выбросы 7.18. Причины неудач 7.19. Предсказание по модели 7.20. Преобразование параметров 7.21. Метод наименьших квадратов для единственного уравнения 7.22. Изучение с помощью метода Монте-Карло 7.23. Ошибки у независимых переменных 7.  24. Метод максимального правдоподобия для модели с двумя уравнениями 24. Метод максимального правдоподобия для модели с двумя уравнениямиГлава VIII. ДИНАМИЧЕСКИЕ МОДЕЛИ 8.1. Модели, включающие дифференциальные уравнения 8.2. Стандартные динамические модели 8.3. Модели, сводящиеся к стандартному виду 8.4. Вычисление целевой функции и ее градиента 8.5. Численное интегрирование 8.6. Некоторые трудности, связанные с динамическими системами 8.7. Задачи химической кинетики 8.8. Линейная зависимость уравнений Глава IX. НЕКОТОРЫЕ СПЕЦИАЛЬНЫЕ ЗАДАЧИ 9.2. Неоднородные ковариационные матрицы 9.3. Последовательное оценивание 9.4. Вычислительные аспекты 9.5. Стохастическая аппроксимация 9.6. Задача с пропущенными данными 9.7. Другая задача с пропущенными данными 9.8. Задача с последовательным оцениванием Глава X. ПЛАНИРОВАНИЕ ЭКСПЕРИМЕНТОВ 10.2. Информация и неопределенность 10.3. Критерий планирования для оценивания параметров 10.4. Критерий планирования для предсказания 10.5. Критерий планирования для дискриминации моделей 10.  6. Правила останова 6. Правила останова10.7. Некоторые практические соображения 10.8. Соображения вычислительного характера 10.9. Имитация экспериментов на вычислительной машине 10.10. Планирование для принятия решения Приложение А. МАТРИЧНЫЙ АНАЛИЗ А.2. Дифференцирование матриц A.3. Элементарные кручения и выметания А.4. Собственные значения и собственные векторы вещественной симметричной матрицы А.5. Спектральные разложения Приложение Б. ВЕРОЯТНОСТЬ Приложение В. ТЕОРЕМА РАО-КРАМЕРА Приложение Г. ПОЛУЧЕНИЕ ВЫБОРКИ ИЗ ЗАДАННОГО МНОГОМЕРНОГО НОРМАЛЬНОГО РАСПРЕДЕЛЕНИЯ Приложение Д. ТЕОРЕМА ГАУССА-МАРКОВА Приложение Е. ТЕОРЕМА СХОДИМОСТИ ДЛЯ ГРАДИЕНТНЫХ МЕТОДОВ Приложение Ж. НЕКОТОРЫЕ ПРОГРАММЫ ОЦЕНИВАНИЯ БИБЛИОГРАФИЯ ПРИЛОЖЕНИЕ К РУССКОМУ ПЕРЕВОДУ |

Принцип максимального правдоподобия | Часть 1 | Акшай Пай | Delta Force

Посмотрим правде в глаза. Машинное обучение — это новая мода. Большая мечта об искусственном интеллекте больше не является какой-то далекой мечтой. Итак, в этой статье мы рассмотрим то, что известно как «Принцип максимального правдоподобия ». Это довольно простой принцип, но большинство алгоритмов обучения в машинном обучении работают благодаря этой простой теореме.

Большая мечта об искусственном интеллекте больше не является какой-то далекой мечтой. Итак, в этой статье мы рассмотрим то, что известно как «Принцип максимального правдоподобия ». Это довольно простой принцип, но большинство алгоритмов обучения в машинном обучении работают благодаря этой простой теореме.

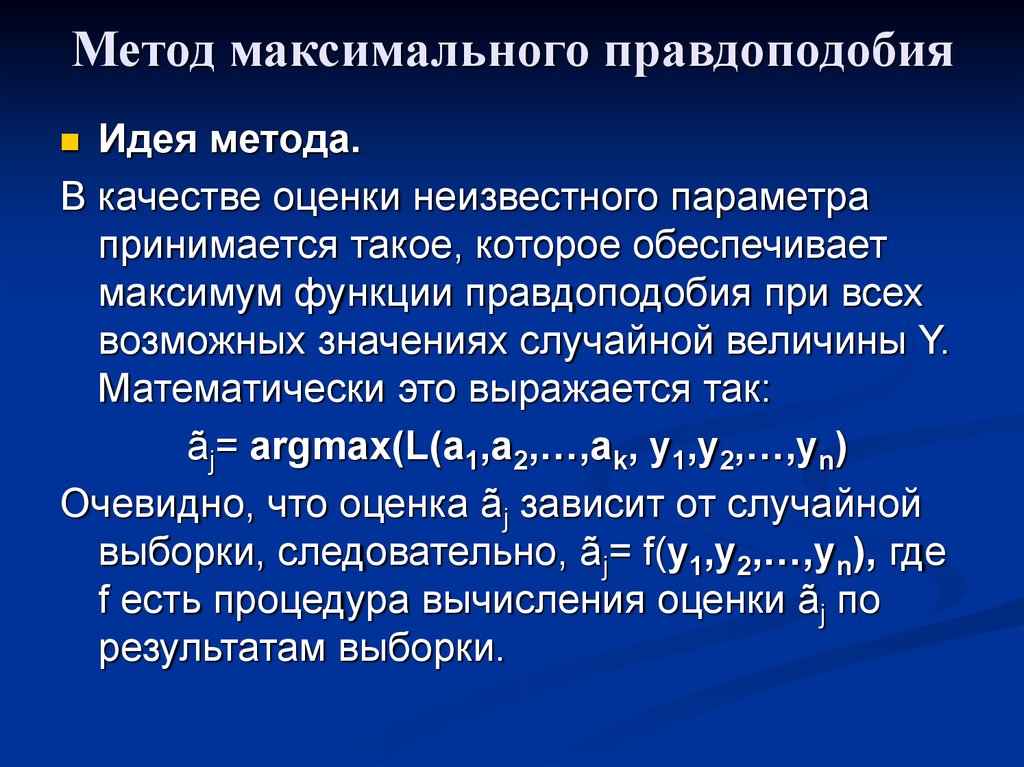

Принцип максимального правдоподобия — это метод получения оптимальных значений параметров, определяющих модель. При этом вы увеличиваете вероятность того, что ваша модель достигнет отметки «9».0007 настоящая модель ».

Хорошо. Вероятно, это не имело смысла . Давайте рассмотрим простой пример, иллюстрирующий принцип максимального правдоподобия.

Предположим, у вас есть две монеты. назовем их A и B. Пусть вероятность выпадения орла монетой A равна 0,5, а вероятность выпадения орла монетой B равна 0,8. А теперь давайте поиграем. Я наугад выбрал одну из двух монет, подбросил ее три раза и выпало 3 орла. Твоя работа — сказать мне, какую монету я выбрал.

Конечно, это звучит тривиально, так как у монеты B больше шансов выпасть орлом. Но давайте посмотрим, как бы мы определили нашу проблему математически. Итак, у нас получилось три головы.

Теперь мы находим условных вероятностей

(краткий обзор. Условная вероятность P(A|B) дает нам вероятность события A при условии, что событие B уже произошло ).

Теперь, поскольку подбрасывание монеты является независимым событием, т. е. результат первого подбрасывания не влияет на результат второго подбрасывания, я могу упростить приведенное выше уравнение следующим образом:

Теперь вычисление условной вероятности для монеты A сокращается до

, а условная вероятность для монеты B равна

Теперь найдите, какая условная вероятность больше, т. е. какая монета имеет более высокую вероятность выпадения трех решек подряд . Таким образом, решение с более высокой условной вероятностью объявляется правильным.

Давайте теперь посмотрим, как можно применить принцип максимального правдоподобия в машинном обучении. Мы рассмотрим два наиболее фундаментальных алгоритма контролируемого машинного обучения.

- Линейная регрессия

- Логистическая регрессия (об этом будет вторая часть)

Рассмотрим следующий пример. Вам предоставляется набор данных, который содержит площади домов и цены, по которым эти дома были куплены. То есть у вас есть набор данных, в котором каждая запись имеет вид (площадь, цена). Теперь предположим, что вам дали площадь нового дома, дома, которого нет в вашем наборе данных, как бы вы предсказали цену дома? Это делается с линейная регрессия.

Но теперь предположим, что ваш набор данных содержит площади домов вместе с меткой дома, которая принимает значение «0», если дом «маленький», или «1», если дом «большой» ( ну… кажется довольно тривиальной задачей… Но давайте убедим себя, что это пока довольно сложная задача ). Итак, такая классификация — это то, для чего хороша логистическая регрессия.

Итак, такая классификация — это то, для чего хороша логистическая регрессия.

Как мы только что обсуждали, линейная регрессия — это метод прогнозирования будущих/новых значений с учетом существующего набора данных, из которого мы можем узнать что-то о корреляции между различными переменными (в приведенном выше примере корреляция между площадью и ценой). Как это работает ? Рассмотрим следующий пример.

Учитывая набор парных значений (x,y), , наша цель состоит в том, чтобы найти функцию f , которая отображает x в y как можно точнее. То есть, учитывая площадь нового дома, нам нужно точно спрогнозировать цену дома. Давайте попробуем построить наш набор данных с house_area на оси X и ценой на оси Y .

Другими словами, наша цель состоит в том, чтобы найти функцию f = m*площадь + c (я буду называть эту функцию прогнозируемая цена ) , чтобы ошибка между прогнозируемой ценой и фактической ценой была минимальной. Эта функция ошибки также называется функцией стоимости . Таким образом, минимизируя функцию стоимости, мы получаем наилучшую возможную модель для наших данных.

Эта функция ошибки также называется функцией стоимости . Таким образом, минимизируя функцию стоимости, мы получаем наилучшую возможную модель для наших данных.

Теперь опишем нашу функцию затрат более формально. Поскольку наша функция стоимости представляет собой ошибку между прогнозом, сделанным нашей моделью, и фактической ценой дома, мы запишем нашу функцию стоимости как

. Для каждой записи (house_area, price_of_house) в нашем наборе данных мы находим квадрат ошибки между фактической цену и цену, которую мы предсказали, сложите все квадраты ошибок и найдите среднеквадратическая ошибка . Это дает нам нашу среднюю ошибку J для данной модели, определяемой константами m и c .

( Пожалуйста, обратите внимание. Множитель 1/(2n) нужен только для того, чтобы сделать математику немного более аккуратной. Он никак не влияет на выпуклую природу (форму) функции стоимости. Таким образом, минимизация J(m,c )*k, где k — некоторая константа, и получение оптимальных значений m и c равносильно минимизации J(m,c) и получению m,c. )

)

Итак, как минимизировать эту ошибку? Простой. Найдите частную производную от J по m и частная производная J по отношению к c и минимизировать J. Вы можете сделать это с помощью градиентного спуска, алгоритма Ньютона-Рафсона или какого-либо другого алгоритма.

Лучшая модель после запуска градиентного спуска на приведенных выше данныхЯ не буду описывать их реализацию в этой статье. Но оба они находят минимумы J и дают вам наилучшее значение m и c. Вот как линейная регрессия дает вам наилучшую возможную функцию f.

Но теперь возникает вопрос: Как вы можете быть уверены, что минимизация вышеуказанной функции всегда будет давать вам наилучшие возможные параметры? То есть, как вы можете с уверенностью сказать, что независимо от того, какой набор данных вы используете, вы всегда получите наилучшие возможные значения параметров, используя приведенную выше функцию в качестве функции стоимости?

Давайте попробуем определить нашу задачу регрессии немного по-другому. Теперь рассмотрим наш предыдущий набор данных.

Теперь рассмотрим наш предыдущий набор данных.

Во-первых, давайте предположим, что каждая из наших записей (area_house,price_of_house) в нашем наборе данных не зависит друг от друга (то есть цена одного дома не имеет ничего общего с ценой другого дома)

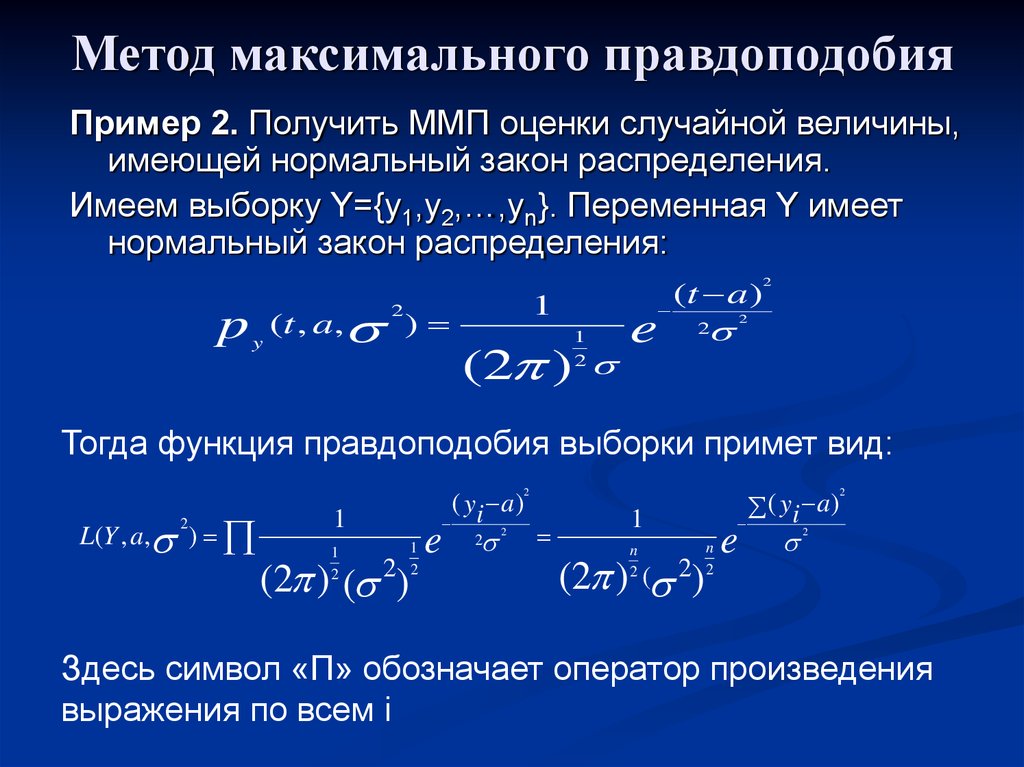

Во-вторых, я собираюсь пойти дальше и предположить, что каждая запись в моем наборе данных исходит из нормального распределения, основанного на прогнозе, который я делаю с помощью модели, и некоторого постоянного стандартного отклонения. То есть; для фактической_цены1 я собираюсь предположить, что она исходит из нормального распределения со средним значением прогнозируемой_цены1 с сигмой стандартного отклонения. Аналогично, фактическая_цена2 получается из распределения со средним значением прогнозируемой_цены2 и сигмой стандартного отклонения и т. д.

Итак, для каждой точки данных я собираюсь предположить, что они получены из нормального распределения со средним значением, равным прогнозу, который я делаю для некоторые заданные m и c. Итак, как вы можете видеть здесь, фактические данные на самом деле не совпадают со средним значением их распределения. Таким образом, ваша цель состоит в том, чтобы найти значение m и c, чтобы фактические значения были как можно ближе к среднему значению.

Итак, как вы можете видеть здесь, фактические данные на самом деле не совпадают со средним значением их распределения. Таким образом, ваша цель состоит в том, чтобы найти значение m и c, чтобы фактические значения были как можно ближе к среднему значению.Теперь я собираюсь определить свою функцию правдоподобия L как

Давайте разберем приведенное выше уравнение. L дает мне вероятность того, что я точно предскажу цену дома1, дома2… как цену1, цену2… при заданных значениях m и c. Таким образом, максимизация функции вероятности L даст мне наилучшую возможную модель в модельном пространстве.

Теперь из-за моего Предположения, я могу записать приведенное выше выражение как

или

А теперь, из нашего Предположение 2, , так как цена_i исходит из нормального распределения с центром в прогнозируемой_цене_i, мы можем записать каждую из вероятностей P как

Получая

Из приведенного выше выражения мы видим, что для максимизации L нам нужно минимизировать мощность экспоненты (поскольку каждый термин продукта является вероятностью, а значения вероятности всегда больше или равны 0). В качестве альтернативы можно взять натуральный логарифм уравнения, в результате чего получится

В качестве альтернативы можно взять натуральный логарифм уравнения, в результате чего получится

, что обозначается как 9.0003 логарифмическая вероятность. Таким образом, мы максимизируем вероятность получения наилучшей модели путем минимизации

Поскольку все выражение всегда больше или равно 0, а сигма является константой, минимизация приведенного выше члена для получения значений m и c аналогична минимизации

, что совпадает с нашей функцией стоимости J(m,c). Но на этот раз мы точно знаем, что минимизация J дает модель с максимальной вероятностью.

Вам может быть интересно, что все это основано на двух предположениях, которые я сделал выше. Как вы можете быть уверены, что предположения верны для каждого набора данных, с которым вы работаете? Ну… нельзя. Хотя оба предположения верны для большинства случаев (второе предположение из-за центральной предельной теоремы и первое предположение просто потому, что ваши записи часто независимы друг от друга), определенно могут быть случаи, когда эти предположения могут быть нарушены. Таким образом, всегда необходимо некоторое начальное исследование ваших данных, прежде чем вы сможете начать запускать другие алгоритмы машинного обучения в своем наборе данных.

Таким образом, всегда необходимо некоторое начальное исследование ваших данных, прежде чем вы сможете начать запускать другие алгоритмы машинного обучения в своем наборе данных.

Что ж… Это подводит нас к концу первой части! В следующей части мы рассмотрим, как можно применить принцип максимального правдоподобия для нахождения функции стоимости логистической регрессии.

Полное объяснение принципа максимального правдоподобия в машинном обучении

В этом посте объясняется еще один фундаментальный принцип вероятности: Принцип максимального правдоподобия или оценщик максимального правдоподобия (MLE). Мы рассмотрим математику, рассуждения и интуицию, стоящие за этим, и опишем его связь с теоремой Байеса, которую мы рассмотрели в других постах. Эти предыдущие сообщения:

- Объяснение теоремы Байеса

- Правило Байеса в машинном обучении

Я предлагаю прочитать их, прежде чем браться за следующие, чтобы следовать вместе с прекрасной сюжетной линией , которую мы создаем вместе. Когда вы будете готовы, откиньтесь на спинку кресла, расслабьтесь и давайте узнаем все о том, что такое MLE и как он используется в машинном обучении.

Когда вы будете готовы, откиньтесь на спинку кресла, расслабьтесь и давайте узнаем все о том, что такое MLE и как он используется в машинном обучении.

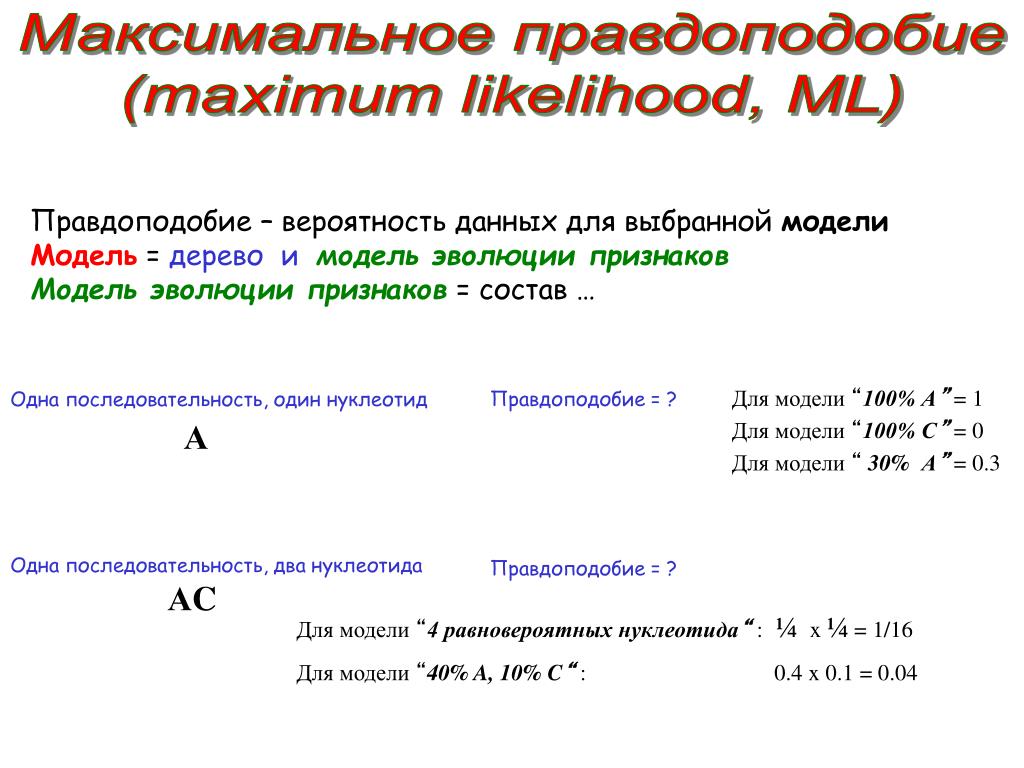

Принцип максимального правдоподобия

Целью принципа максимального правдоподобия является подбор оптимального статистического распределения для некоторых данных. Это упрощает работу с данными, делает их более общими, позволяет нам видеть, следуют ли новые данные тому же распределению, что и предыдущие данные, и, наконец, это позволяет нам классифицировать немаркированные точки данных.

Давайте представим задачу бинарной классификации между мужчинами и женщинами с использованием роста. Как только мы рассчитали распределение вероятностей роста мужчин и женщин и получили 90 003 новую точку данных 90 004 (как рост без метки), 90 003 мы можем отнести ее к наиболее вероятному классу 9.0004 , чтобы увидеть, какое распределение сообщает о наибольшей вероятности из двух.

Графическое представление этой задачи бинарной классификации На предыдущем изображении эта новая точка данных ( xnew, , что соответствует росту 172 см) классифицируется как женщина, поскольку для этого конкретного значения роста распределение женского роста дает более высокая вероятность, чем мужская.

Вы могли бы сказать, что это очень круто, но как мы на самом деле рассчитываем эти распределения вероятностей? Не беспокойтесь, мы займемся этим прямо сейчас. Сначала мы объясним общий процесс, лежащий в основе принципа максимального правдоподобия, а затем рассмотрим более конкретный случай на примере.

Вычисление распределений: оценка функции параметрической плотности

Как обычно в Машинное обучение , первое, что нам нужно, чтобы начать вычисление распределения, это что-то узнать из: наши драгоценные данные . Мы будем обозначать наш вектор данных размером n , как X . В этом векторе каждая из строк представляет собой точку данных с d функциями , поэтому наш вектор данных X на самом деле является вектором векторов: матрица размера n x d ; n точек данных с d функциями в каждой.

После того, как мы собрали данные, из которых мы хотим рассчитать распределение, нам нужно начать угадывать. Угадай? Да, вы правильно прочитали. Нам нужно угадать вид функции плотности или распределения, которым, по нашему мнению, соответствуют наши данные: Гауссово, экспоненциальное, пуассоновское…

Угадай? Да, вы правильно прочитали. Нам нужно угадать вид функции плотности или распределения, которым, по нашему мнению, соответствуют наши данные: Гауссово, экспоненциальное, пуассоновское…

Не волнуйтесь, это может показаться не очень научным, но в большинстве случаев для каждого типа данных существует распределение, которое, скорее всего, подходит лучше всего: Гауссово для таких характеристик, как температура или высота, экспоненциальный для характеристик времени, таких как продолжительность телефонных звонков или жизнь бактериальных популяций, или Пуассона (отличное видео о распределении Пуассона здесь) для характеристик, таких как количество домов, проданных за определенный период времени.

Как только это будет сделано, мы вычислим конкретные параметры выбранного распределения, которые лучше всего соответствуют нашим данным . Для нормального распределения это будет среднее значение и дисперсия. Поскольку гауссово или нормальное распределение, вероятно, проще всего объяснить и понять, мы продолжим этот пост, предполагая, что выбрали гауссову функцию плотности для представления наших данных.

Поскольку гауссово или нормальное распределение, вероятно, проще всего объяснить и понять, мы продолжим этот пост, предполагая, что выбрали гауссову функцию плотности для представления наших данных.

Если вы не знаете, что такое распределение Гаусса, ознакомьтесь с замечательными книгами, такими как «Байесовская статистика в увлекательном виде: понимание статистики и вероятности с помощью «Звездных войн», LEGO и «Резиновых уточек». Вы можете найти отличный обзор книги здесь: Bayesian Statistics the Fun Way review.

Хорошо, давайте продолжим с принципом максимального правдоподобия и нашим примером:

Данные и параметры для нашего гауссовского распределенияВ этом случае количество параметров, которые нам нужно рассчитать, составляет d означает (по одному для каждой функции) и d(d+1)/2 дисперсии, поскольку ковариационная матрица представляет собой симметричную dxd матрицу.

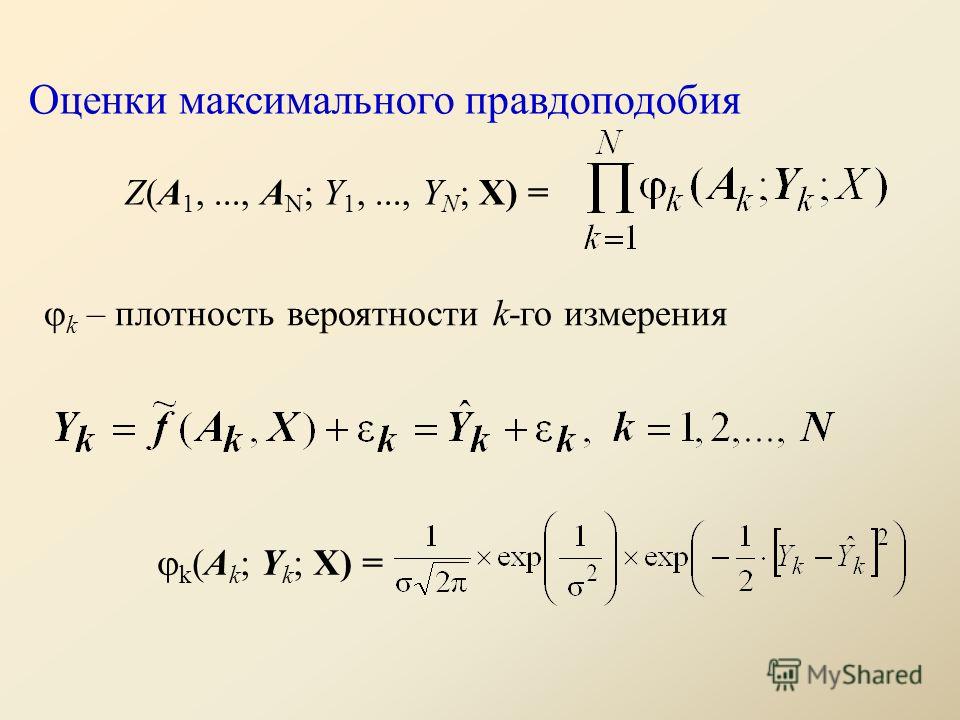

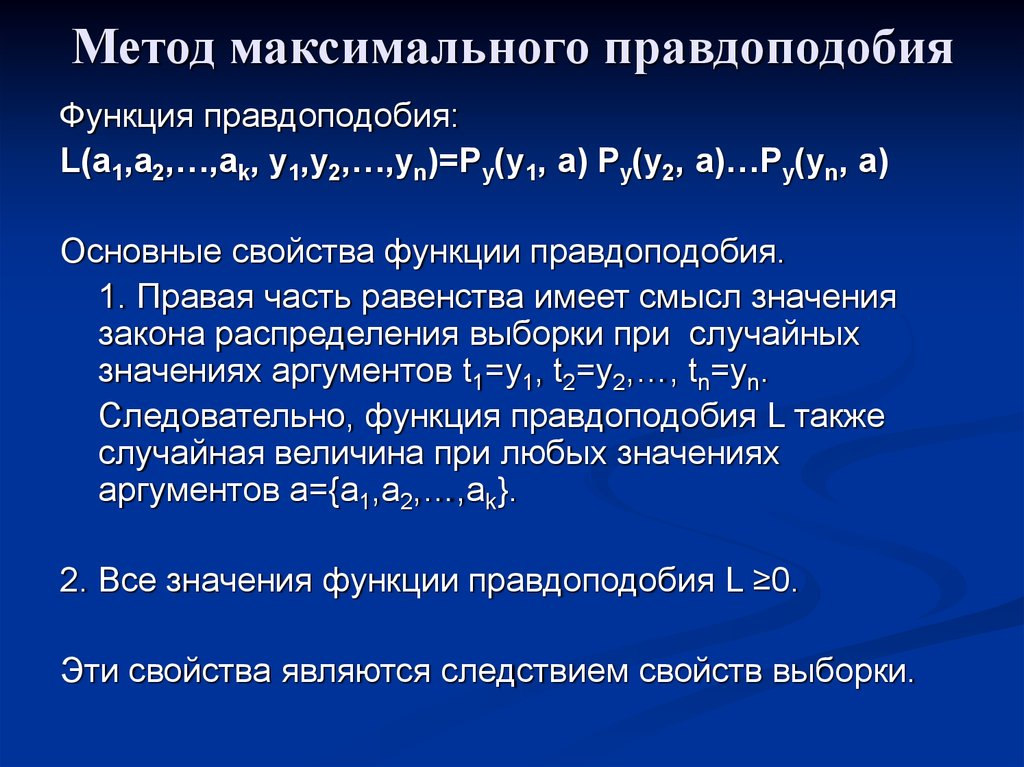

Всего параметров, которые нам нужно рассчитать для нормального распределения в зависимости от количества признаков Назовем общий набор параметров распределения θ . В нашем случае это включает среднее значение и дисперсию для каждого признака . Что мы хотим сделать сейчас, так это получить набор параметров θ , который максимизирует совместную функцию плотности вектора данных; так называемая функция правдоподобия L(θ). Эта функция правдоподобия также может быть выражена как P(X|θ) , что можно прочитать как условную вероятность X при заданном наборе параметров θ.

В нашем случае это включает среднее значение и дисперсию для каждого признака . Что мы хотим сделать сейчас, так это получить набор параметров θ , который максимизирует совместную функцию плотности вектора данных; так называемая функция правдоподобия L(θ). Эта функция правдоподобия также может быть выражена как P(X|θ) , что можно прочитать как условную вероятность X при заданном наборе параметров θ.

В этом обозначении X — матрица данных, X(1) до X(n) — каждая из точек данных, а θ — заданный набор параметров для распределения. Опять же, поскольку цель принципа максимального правдоподобия состоит в том, чтобы выбрать значения параметров таким образом, чтобы наблюдаемые данные были максимально вероятными, мы приходим к задаче оптимизации, зависящей от θ.

Чтобы получить этот оптимальный набор параметров, мы возьмем производные по θ в функции правдоподобия и найдите максимум: этот максимум представляет значения параметров, которые делают наблюдение за доступными данными максимально вероятным.

Теперь, , если точки данных X независимы друг от друга , функция правдоподобия может быть выражена как произведение отдельных вероятностей каждой точки данных с заданным набором параметров:

Вероятность функция, если точки данных независимы друг от другаВзятие производных по отношению к этому уравнению для каждого параметра (среднее значение, дисперсия и т. д.), сохраняя остальные постоянными, дает нам связь между значением точек данных, количеством точек данных и каждым параметром.

Давайте рассмотрим пример того, как это делается с использованием нормального распределения и простого набора данных о росте мужчин.

Более глубокий взгляд на математику принципа максимального правдоподобия с использованием нормального распределения

Давайте рассмотрим пример того, как использовать метод максимального правдоподобия для подбора нормального распределения к набору точек данных с только одной характеристикой: высотой в сантиметрах. Как мы упоминали ранее, есть параметры, которые мы должны рассчитать: среднее значение и дисперсия.

Как мы упоминали ранее, есть параметры, которые мы должны рассчитать: среднее значение и дисперсия.

Для этого нам нужно знать функцию плотности для нормального распределения :

Функция плотности для нормального распределения. Источник ВикипедияЗная это, мы можем рассчитать функцию правдоподобия для каждой точки данных. Для первой точки данных это будет:

Уравнение правдоподобия для первой точки данныхДля всего набора данных, считая наши точки данных независимыми, и поэтому мы можем вычислить функцию правдоподобия как произведение вероятностей отдельных точек, это будет:

Уравнение правдоподобия для всего набора данныхМы можем взять эту функцию и выразить ее логарифмическим способом , что облегчает апостериорные вычисления, и дает точно такие же результаты.

То же уравнение, выраженное логарифмическим способомНаконец, мы устанавливаем производную функции правдоподобия относительно среднего значения равным нулю, получая выражение, в котором мы получаем значение этого первого параметра:

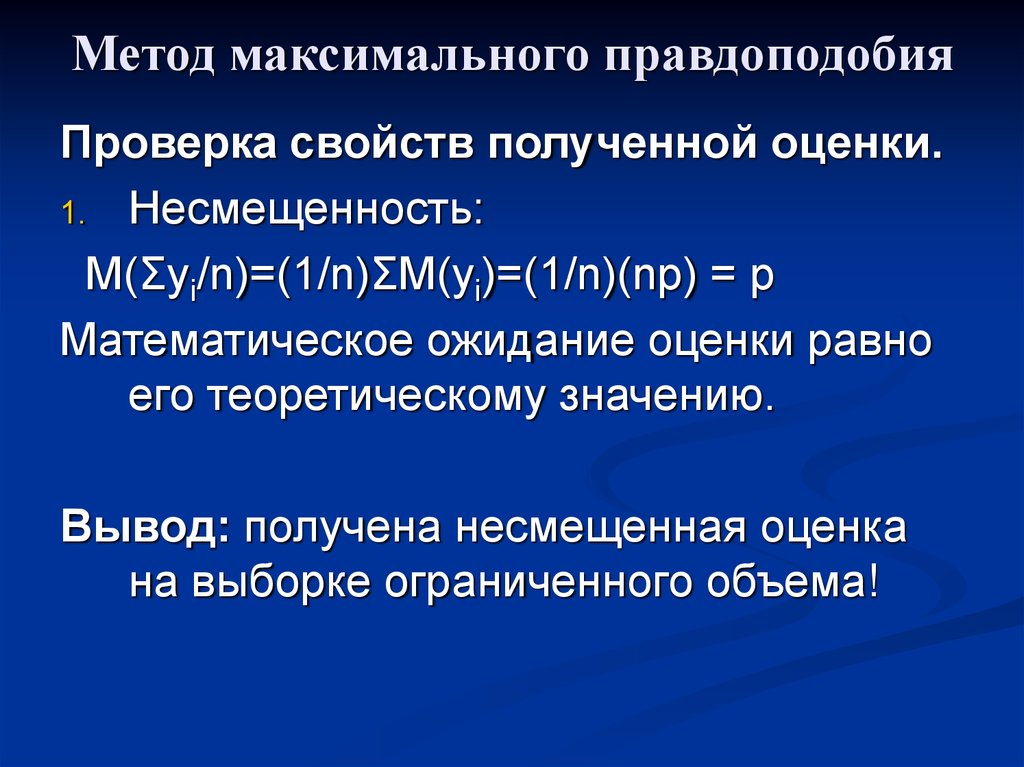

Производная функции правдоподобия для среднее значение и значение оценки максимального правдоподобия для этого параметра Сюрприз! Оценка максимального правдоподобия для среднего значения нормального распределения составляет всего , что мы интуитивно ожидаем : сумма значения каждой точки данных, деленная на количество точек данных.

Теперь, когда мы вычислили оценку среднего значения, пришло время сделать то же самое для другого соответствующего параметра: дисперсия . Для этого, как и раньше, мы берем производные в функции правдоподобия с целью найти значение дисперсии, которое максимизирует вероятность наблюдаемых данных.

Оценка максимального правдоподобия для дисперсииЭто, как и в предыдущем случае, приводит нас к тому же результату, с которым мы знакомы из повседневной статистики.

Вот оно! Мы рассмотрели общую математику и процедуры расчета оценки максимального правдоподобия нормального распределения. Давайте посмотрим на быстрый числовой пример, чтобы закончить!

Оценка максимального правдоподобия для роста мужчин: числовой пример

Давайте рассмотрим очень простой пример, который мы упоминали ранее: у нас есть набор данных о росте мужчин в определенной области, и мы хотим найти для него оптимальное распределение с помощью метода максимального правдоподобия.

Если мы правильно помним, первым шагом для этого (после сбора и понимания данных) является выбор формы функции плотности, которую мы хотим оценить. В нашем случае для высоты мы будем использовать распределение Гаусса, которое мы также видели в общих рассуждениях, лежащих в основе математики ML. Давайте еще раз взглянем на формулу, определяющую такое распределение:

Функция плотности для нормального распределения. Источник Википедия. Кроме того, давайте восстановим функцию правдоподобия только для одной точки набора данных.

Уравнение правдоподобия для первой точки данныхПредставьте себе наш вектор данных X , в нашем случае он выглядит следующим образом:

Вектор данных роста мужчинУ нас есть 10 точек данных (n = 10) и по одному признаку для каждых данных точка (d=1) . Если в приведенной выше формуле для каждой точки данных подставить их фактические значения, то получится что-то вроде:

Вероятность первых двух точек данных Если в этих формулах мы выберем определенное среднее значение и значение дисперсии , мы получим вероятность наблюдения каждого из значений высоты (176 и 172 см в нашем случае) с этими конкретное среднее значение и дисперсия . Например, если мы выберем среднее значение 180 см с дисперсией 4 см, мы получим следующие вероятности для двух точек, показанных выше:

Например, если мы выберем среднее значение 180 см с дисперсией 4 см, мы получим следующие вероятности для двух точек, показанных выше:

После этого краткого замечания, если мы продолжим процедуру получения оценки максимального правдоподобия, которая лучше всего соответствует набору данных, нам придется сначала вычислить среднее значение . Для нашего случая это очень просто: мы просто суммируем значения точек данных и делим эту сумму на количество точек данных.

Оценка максимального правдоподобия для среднего значения нашего набора данных о высотеЕсли мы сделаем то же самое для дисперсии , вычислив квадрат суммы значения каждой точки данных за вычетом среднего и разделив ее на общее количество точек, мы получим:

Оценки дисперсии и стандартного отклонения для нашего набора данных о высоте Вот и все! Теперь, когда мы вычислили среднее значение и дисперсию, у нас есть все параметры, необходимые для моделирования нашего распределения. Теперь, когда мы получаем новых точек данных, например, с высотой 177 см , мы можем увидеть вероятность того, что эта точка принадлежит нашему набору данных:

Теперь, когда мы получаем новых точек данных, например, с высотой 177 см , мы можем увидеть вероятность того, что эта точка принадлежит нашему набору данных:

Теперь, если бы у нас был другой набор данных, например, с ростом женщин, и мы выполнили ту же процедуру, у нас было бы два распределения роста: одно для мужчин и одно для женщин.

С помощью этого мы могли бы решить задачу бинарной классификации роста мужчин и женщин, используя оба распределения: когда мы получаем новую немаркированную точку данных роста, мы вычисляем вероятность того, что эта новая точка данных принадлежит обоим распределениям, и отнести его к классу (мужской или женский) , для которого распределение дает наибольшую вероятность.

Резюме: принцип максимального правдоподобия

Мы увидели, что такое максимальное правдоподобие, математику, стоящую за ним, и как его можно применять для решения реальных проблем. Это дало нам основу для написания следующего поста, о котором вы все просили: Математика, стоящая за теоремой Байеса , которая очень похожа на теорию максимального правдоподобия.

Это дало нам основу для написания следующего поста, о котором вы все просили: Математика, стоящая за теоремой Байеса , которая очень похожа на теорию максимального правдоподобия.

Чтобы проверить это, подпишитесь на нас в Twitter и следите за обновлениями!

Дополнительные ресурсы

Если вы хотите больше узнать о максимальном правдоподобии и машинном обучении, ознакомьтесь с этими другими ресурсами:

- Видео с очень четким объяснением и примером максимального правдоподобия

- Очень подробное видео о максимальном правдоподобии для нормального распределения

- Слайды максимального правдоподобия

- Список лучших онлайн-курсов по теории вероятностей.

- Рецензии на книгу «Великий анализ данных и вероятность»:

- Вероятность для энтузиаста-новичка

- Статистическое переосмысление

- Think Stats

Если у вас есть какие-либо вопросы, свяжитесь с нами по телефону howtolearnmachinelearning@gmail.

«Likelihood Inference and Time Series». J. Royal Statistical Society, A 125 (3): 321-372. ISSN 0035-9238.

«Likelihood Inference and Time Series». J. Royal Statistical Society, A 125 (3): 321-372. ISSN 0035-9238. Trans. Royal Soc. A 222: 326. DOI:10.1098/rsta.1922.0009. ISSN 0264-3952.

Trans. Royal Soc. A 222: 326. DOI:10.1098/rsta.1922.0009. ISSN 0264-3952. Нелинейное оценивание параметров. М.: Статистика, 1979. — 349 с.

Нелинейное оценивание параметров. М.: Статистика, 1979. — 349 с.