Теоретические основы статистической радиотехники

Теоретические основы статистической радиотехники

ОглавлениеПРЕДИСЛОВИЕ К ТРЕТЬЕМУ ИЗДАНИЮВведение Часть первая. АНАЛИЗ 1.1. ОПРЕДЕЛЕНИЕ ВЕРОЯТНОСТИ 1.1.2. Алгебра событий. 1.1.3. Аксиомы теории вероятностей. 1.2. ОСНОВНЫЕ ПРАВИЛА ТЕОРИИ ВЕРОЯТНОСТЕЙ 1.3. ПОСЛЕДОВАТЕЛЬНОСТЬ НЕЗАВИСИМЫХ ИСПЫТАНИИ 1.4. ПРОСТАЯ ЦЕПЬ МАРКОВА Глава 2. СЛУЧАЙНЫЕ ВЕЛИЧИНЫ 2.1.1. Определение случайной величины. 2.1.2. Функция распределения. 2.1.3. Функция,распределения дискретной случайной величины. 2.1.4. Плотность вероятности непрерывной случайной величины. 2.1.5. Обобщенная плотность вероятности для дискретной случайной величины. 2.2. ЧИСЛОВЫЕ ХАРАКТЕРИСТИКИ СЛУЧАЙНОЙ ВЕЛИЧИНЫ 2.3. СОВОКУПНОСТЬ СЛУЧАЙНЫХ ВЕЛИЧИН 2.3.2. Многомерная плотность вероятности. 2.3.3. Числовые характеристики совокупности случайных величин.  2.3.5. Условные среднее значение и дисперсия. 2.4. НОРМАЛЬНОЕ РАСПРЕДЕЛЕНИЕ ВЕРОЯТНОСТЕЙ 2.5. ОРТОГОНАЛЬНОЕ РАЗЛОЖЕНИЕ ПЛОТНОСТЕЙ ВЕРОЯТНОСТИ 2.6. ЗАДАЧИ Глава 3. ФУНКЦИИ СЛУЧАЙНЫХ ВЕЛИЧИН 3.1. РАСПРЕДЕЛЕНИЯ ВЕРОЯТНОСТЕЙ ФУНКЦИЙ СЛУЧАЙНЫХ АРГУМЕНТОВ 3.2. РАСПРЕДЕЛЕНИЕ ВЕРОЯТНОСТЕЙ МОДУЛЯ И ФАЗЫ СЛУЧАЙНОГО ВЕКТОРА 3.3. ХАРАКТЕРИСТИЧЕСКАЯ ФУНКЦИЯ 3.4. ПРЕДЕЛЬНЫЕ РАСПРЕДЕЛЕНИЯ СУММ СЛУЧАЙНЫХ ВЕЛИЧИН 3.5. ЗАДАЧИ Глава 4. СЛУЧАЙНЫЕ ПРОЦЕССЫ 4.1. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ СЛУЧАЙНЫХ ПРОЦЕССОВ 4.2. КЛАССИФИКАЦИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ ПО ИХ ВЕРОЯТНОСТНЫМ ХАРАКТЕРИСТИКАМ 4.3. ЭНЕРГЕТИЧЕСКИЕ ХАРАКТЕРИСТИКИ СЛУЧАЙНЫХ ПРОЦЕССОВ 4.4. КЛАССИФИКАЦИЯ СТАЦИОНАРНЫХ В ШИРОКОМ СМЫСЛЕ ПРОЦЕССОВ ПО ИХ СПЕКТРАЛЬНОЙ ПЛОТНОСТИ МОЩНОСТИ 4.6. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ ВЫБРОСОВ СЛУЧАЙНОГО ПРОЦЕССА Глава 5. ОСНОВНЫЕ МОДЕЛИ СЛУЧАЙНЫХ ПРОЦЕССОВ 5.1. КЛАССИФИКАЦИЯ ОСНОВНЫХ МОДЕЛЕЙ 5.2. ГАУССОВСКИЕ СЛУЧАЙНЫЕ ПРОЦЕССЫ 5.  3. СЛУЧАЙНЫЕ ПРОЦЕССЫ С НЕЗАВИСИМЫМИ ПРИРАЩЕНИЯМИ 3. СЛУЧАЙНЫЕ ПРОЦЕССЫ С НЕЗАВИСИМЫМИ ПРИРАЩЕНИЯМИ5.4. МАРКОВСКИЕ СЛУЧАЙНЫЕ ПРОЦЕССЫ 5.5. ИМПУЛЬСНЫЕ СЛУЧАЙНЫЕ ПРОЦЕССЫ 5.6. ЗАДАЧИ Глава 6. ОСНОВНЫЕ МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ 6.1. КЛАССИФИКАЦИЯ И ХАРАКТЕРИСТИКИ МАТЕМАТИЧЕСКИХ МОДЕЛЕЙ СИСТЕМ 6.2. ЛИНЕЙНЫЕ СИСТЕМЫ С ДИСКРЕТНЫМ ВРЕМЕНЕМ (ЦИФРОВЫЕ ФИЛЬТРЫ) 6.3. ЛИНЕЙНЫЕ СИСТЕМЫ С НЕПРЕРЫВНЫМ ВРЕМЕНЕМ 6.4. ТИПОВОЕ ЗВЕНО РАДИОТЕХНИЧЕСКИХ УСТРОЙСТВ 6.5. ДВА СПОСОБА ОПИСАНИЯ СИСТЕМ ПОД ВОЗДЕЙСТВИЕМ СЛУЧАЙНЫХ ПРОЦЕССОВ Глава 7. ПРЕОБРАЗОВАНИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ В ЛИНЕЙНЫХ ДИНАМИЧЕСКИХ (ИНЕРЦИОННЫХ) СИСТЕМАХ 7.1. ПРЕОБРАЗОВАНИЯ СЛУЧАЙНЫХ ПОСЛЕДОВАТЕЛЬНОСТЕЙ В ЛИНЕЙНЫХ СИСТЕМАХ С ДИСКРЕТНЫМ ВРЕМЕНЕМ 7.2. ПРЕОБРАЗОВАНИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ В ЛИНЕЙНЫХ СИСТЕМАХ С НЕПРЕРЫВНЫМ ВРЕМЕНЕМ 7.3. РАСПРЕДЕЛЕНИЕ ВЕРОЯТНОСТЕЙ СЛУЧАЙНОГО ПРОЦЕССА НА ВЫХОДЕ ЛИНЕЙНОЙ СИСТЕМЫ 7.4. ПРЕОБРАЗОВАНИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ В ЛИНЕЙНЫХ СИСТЕМАХ СО СЛУЧАЙНЫМИ ПАРАМЕТРАМИ 7.5. ЗАДАЧИ Глава 8. ПРЕОБРАЗОВАНИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ В НЕЛИНЕЙНЫХ СТАТИЧЕСКИХ (БЕЗЫНЕРЦИОННЫХ) СИСТЕМАХ 8.  1. ЭНЕРГЕТИЧЕСКИЕ ХАРАКТЕРИСТИКИ ПРОЦЕССА НА ВЫХОДЕ НЕЛИНЕЙНОЙ СИСТЕМЫ 1. ЭНЕРГЕТИЧЕСКИЕ ХАРАКТЕРИСТИКИ ПРОЦЕССА НА ВЫХОДЕ НЕЛИНЕЙНОЙ СИСТЕМЫ8.2. РАСПРЕДЕЛЕНИЕ ВЕРОЯТНОСТЕЙ ПРОЦЕССА НА ВЫХОДЕ СТАТИЧЕСКОЙ НЕЛИНЕЙНОЙ СИСТЕМЫ 8.3. КВАНТОВАНИЕ СЛУЧАЙНОГО ПРОЦЕССА 8.4. ЗАДАЧИ Глава 9. ПРЕОБРАЗОВАНИЯ ГАУССОВСКИХ ПРОЦЕССОВ В СТАТИЧЕСКИХ (БЕЗИНЕРЦИОННЫХ) НЕЛИНЕЙНЫХ СИСТЕМАХ 9.1. АНАЛИЗ ЭНЕРГЕТИЧЕСКИХ ХАРАКТЕРИСТИК ПРЯМЫМ МЕТОДОМ 9.3. АНАЛИЗ ЭНЕРГЕТИЧЕСКИХ ХАРАКТЕРИСТИК МЕТОДОМ ПРОИЗВОДНЫХ 9.4. РАСПРЕДЕЛЕНИЕ ВЕРОЯТНОСТЕЙ ГАУССОВСКОГО ПРОЦЕССА ПОСЛЕ ЕГО НЕЛИНЕЙНОГО ПРЕОБРАЗОВАНИЯ 9.5. КВАНТОВАНИЕ ГАУССОВСКОГО ПРОЦЕССА 9.6. ЗАДАЧИ Глава 10. ОГИБАЮЩАЯ И ФАЗА УЗКОПОЛОСНОГО СЛУЧАЙНОГО ПРОЦЕССА 10.1. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ ОГИБАЮЩЕЙ И ФАЗЫ 10.2. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ ОГИБАЮЩЕЙ ГАУССОВСКОГО ПРОЦЕССА 10.3. НЕЛИНЕЙНЫЕ ПРЕОБРАЗОВАНИЯ ОГИБАЮЩЕЙ ГАУССОВСКОГО ПРОЦЕССА 10.4. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ ФАЗЫ ГАУССОВСКОГО ПРОЦЕССА 10.  5. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ КОСИНУСА ФАЗЫ ГАУССОВСКОГО ПРОЦЕССА 5. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ КОСИНУСА ФАЗЫ ГАУССОВСКОГО ПРОЦЕССА10.6. ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ ПРОИЗВОДНЫХ ОТ ОГИБАЮЩЕЙ И ФАЗЫ ГАУССОВСКОГО ПРОЦЕССА 10.7. ЗАДАЧИ Глава 11. ПРЕОБРАЗОВАНИЯ ГАУССОВСКОГО ПРОЦЕССА В НЕЛИНЕЙНЫХ ИНЕРЦИОННЫХ СИСТЕМАХ 11.2. УСИЛИТЕЛЬ — КВАДРАТИЧНЫЙ ДЕТЕКТОР — ФИЛЬТР 11.3. ПЕРЕМНОЖИТЕЛЬ-ФИЛЬТР 11.4. СРЕДНЯЯ МОЩНОСТЬ ПРИ КОНЕЧНОМ ВРЕМЕНИ УСРЕДНЕНИЯ 11.5. ЗАДАЧИ Часть вторая. СИНТЕЗ 12.1. ОБЩИЕ ПОНЯТИЯ МАТЕМАТИЧЕСКОЙ СТАТИСТИКИ 12.2. АПРИОРНЫЕ ДАННЫЕ 12.3. КРИТЕРИИ КАЧЕСТВА 12.4. СТАТИСТИЧЕСКИЙ СИНТЕЗ ОПТИМАЛЬНЫХ АЛГОРИТМОВ 12.5. ВЕРОЯТНОСТНЫЙ АНАЛИЗ АЛГОРИТМОВ ПРИНЯТИЯ РЕШЕНИЯ Глава 13. ПРОВЕРКА СТАТИСТИЧЕСКИХ ГИПОТЕЗ 13.1. ОДНОШАГОВЫЕ АЛГОРИТМЫ ПРОВЕРКИ ПРОСТОЙ ГИПОТЕЗЫ ПРОТИВ ПРОСТОЙ АЛЬТЕРНАТИВЫ 13.2. ПОСЛЕДОВАТЕЛЬНЫЕ МНОГОШАГОВЫЕ АЛГОРИТМЫ ПРОВЕРКИ ПРОСТОЙ ГИПОТЕЗЫ ПРОТИВ ПРОСТОЙ АЛЬТЕРНАТИВЫ 13.3. МНОГОАЛЬТЕРНАТИВНАЯ ЗАДАЧА ПРОВЕРКИ ГИПОТЕЗ 13.4. ПРОВЕРКА ГИПОТЕЗ В УСЛОВИЯХ ПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ 13.  5. ПРОВЕРКА ГИПОТЕЗ О СРЕДНЕМ ЗНАЧЕНИИ ГАУССОВСКОЙ СЛУЧАЙНОЙ ВЕЛИЧИНЫ 5. ПРОВЕРКА ГИПОТЕЗ О СРЕДНЕМ ЗНАЧЕНИИ ГАУССОВСКОЙ СЛУЧАЙНОЙ ВЕЛИЧИНЫ13.6. ПРОВЕРКА ПРОСТОЙ ГИПОТЕЗЫ О ВЕКТОРЕ СРЕДНИХ МНОГОМЕРНОГО НОРМАЛЬНОГО РАСПРЕДЕЛЕНИЯ ПРОТИВ ПРОСТОЙ АЛЬТЕРНАТИВЫ 13.8. СТАТИСТИКИ, ИСПОЛЬЗУЕМЫЕ В НЕПАРАМЕТРИЧЕСКИХ АЛГОРИТМАХ ПРОВЕРКИ ГИПОТЕЗ 13.8.3. Порядковые статистики. 13.8.4. Ранговые статистики. 13.5.8. Знаково-ранговые статистики. 13.8.6. Односторонний знаковый алгоритм. 13.8.7. Относительная эффективность одностороннего знакового алгоритма. 13.8.8. Двусторонний знаковый алгоритм. 13.8.9. Линейный знаково-ранговый алгоритм. 13.8.10. Среднее и дисперсия линейной знаково-ранговой статистики. 13.8.11. Асимптотическая характеристика линейного знаковорангового алгоритма. 13.8.12. Относительная эффективность линейного знаково-рангового алгоритма. 13.9. АНАЛОГОВЫЕ АЛГОРИТМЫ ПРОВЕРКИ ГИПОТЕЗ 13.10. ЗАДАЧИ Глава 14. ОЦЕНИВАНИЕ НЕИЗВЕСТНЫХ ХАРАКТЕРИСТИК 14.  1. ОЦЕНИВАНИЕ В УСЛОВИЯХ НЕПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ 1. ОЦЕНИВАНИЕ В УСЛОВИЯХ НЕПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ14.2. ОЦЕНИВАНИЕ В УСЛОВИЯХ ПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ 14.3. ОЦЕНКИ МАКСИМАЛЬНОГО ПРАВДОПОДОБИЯ 14.4. ОЦЕНИВАНИЕ СЛУЧАЙНОГО ПАРАМЕТРА 14.5. ОЦЕНИВАНИЕ ПАРАМЕТРОВ НОРМАЛЬНОГО РАСПРЕДЕЛЕНИЯ 14.6. АНАЛОГОВЫЕ АЛГОРИТМЫ ОЦЕНИВАНИЯ ПАРАМЕТРОВ 14.7. ЗАДАЧИ Глава 15. ОБНАРУЖЕНИЕ СИГНАЛОВ НА ФОНЕ АДДИТИВНЫХ ГАУССОВСКИХ ПОМЕХ 15.1. ОПТИМАЛЬНЫЕ ДИСКРЕТНО-АНАЛОГОВЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННЫХ СИГНАЛОВ 15.1.2. Синтез оптимального алгоритма обнаружения по независимой выборке. 15.1.3. Анализ рабочей характеристики оптимального алгоритма обнаружения сигнала. 15.1.4. Реализация алгоритма при помощи цифрового фильтра. 15.1.5. Синтез оптимального алгоритма обнаружения по коррелированной выборке. 15.1.6. Рабочая характеристика оптимального алгоритма. 15.1.7. Два способа дискретизации наблюдений. 15.1.8. Оптимальный алгоритм обнаружения по независимым координатам.  15.1.9. Сопоставление рассмотренных дискретно-аналоговых алгоритмов обнаружения. 15.2. ФУНКЦИОНАЛ ОТНОШЕНИЯ ПРАВДОПОДОБИЯ ГАУССОВСКОГО ПРОЦЕССА 15.3. ОПТИМАЛЬНЫЕ АНАЛОГОВЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННЫХ СИГНАЛОВ 15.3.2. Реализация оптимального аналогового алгоритма. 15.3.3. Помеха — белый шум. 15.3.4. Согласованный фильтр. 15.3.5. Отношение сигнал-помеха на выходе оптимального фильтра. 15.4. ОПТИМАЛЬНЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ КВАЗИДЕТЕРМИНИРОВАННЫХ СИГНАЛОВ 15.4.2. Комплексная огибающая узкополосного процесса. 15.4.3. Независимые координаты комплексной огибающей гауссовского случайного процесса. 15.4.4. Оптимальные дискретно-аналоговые алгоритмы обнаружения квазидетерминированных сигналов. 15.4.5. Оптимальные аналоговые алгоритмы обнаружения квазидетерминированных сигналов. 15.4.6. Структурная схема устройства, реализующего оптимальный аналоговый алгоритм обнаружения. 15.4.7. Обнаружение на фоне аддитивного белого шума. 15.  5. ПОСЛЕДЕТЕКТОРНЫЕ ОПТИМАЛЬНЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ 5. ПОСЛЕДЕТЕКТОРНЫЕ ОПТИМАЛЬНЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ15.5.2. Оптимальный дискретно-аналоговый амплитудный алгоритм обнаружения. 15.5.3. Оптимальный амплитудный алгоритм обнаружения слабого сигнала. 15.5.4. Оптимальный амплитудный алгоритм обнаружения сильного сигнала. 15.5.5. Оптимальные аналоговые амплитудные алгоритмы обнаружения. 15.5.6. Оптимальный фазовый алгоритм обнаружения детерминированного сигнала. 15.5.7. Оптимальный фазовый алгоритм обнаружения слабого сигнала. 15.5.8. Оптимальный фазовый алгоритм обнаружения слабого квазидетерминированного сигнала. 15.6. ОПТИМАЛЬНЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ ГАУССОВСКОГО СИГНАЛА НА ФОНЕ АДДИТИВНОЙ ГАУССОВСКОЙ ПОМЕХИ Глава 16. НЕПАРАМЕТРИЧЕСКИЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ НА ФОНЕ ПОМЕХ 16.1. НЕПАРАМЕТРИЧЕСКИЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННЫХ СИГНАЛОВ НА ФОНЕ АДДИТИВНЫХ ПОМЕХ 16.1.2. Знаковый алгоритм обнаружения детерминированного сигнала. 16.1.3. Относительная эффективность знакового обнаружителя.  16.1.4. Знаково-ранговый алгоритм обнаружения детерминированного сигнала. 16.1.5. Относительная эффективность знаково-рангового обнаружителя. 16.1.6. Ранговые алгоритмы обнаружения узкополосных сигналов. 16.7.1. Коэффициент асимптотической относительной эффективности алгоритма Вилкоксона. 16.2. НЕПАРАМЕТРИЧЕСКИЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СТОХАСТИЧЕСКИХ СИГНАЛОВ НА ФОНЕ АДДИТИВНЫХ ПОМЕХ 16.3. НЕПАРАМЕТРИЧЕСКИЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ НА ФОНЕ ПОМЕХ ПО НЕЗАВИСИМЫМ ГРУППАМ КОРРЕЛИРОВАННЫХ ВЫБОРОК Глава 17. СИНТЕЗ АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫХ АЛГОРИТМОВ ОБНАРУЖЕНИЯ СИГНАЛОВ (МАТЕМАТИЧЕСКИЕ ОСНОВЫ) 17.1. АСИМПТОТИЧЕСКАЯ ОПТИМАЛЬНОСТЬ 17.2. ВЕРОЯТНОСТНЫЕ МОДЕЛИ НАБЛЮДЕНИЙ 17.3. КОНТИГУАЛЬНОСТЬ 17.4. АСИМПТОТИЧЕСКОЕ РАЗЛОЖЕНИЕ ЛОГАРИФМА ОТНОШЕНИЯ ПРАВДОПОДОБИЯ 17.5. ПРЕДЕЛЬНЫЕ РАСПРЕДЕЛЕНИЯ ОТНОСИТЕЛЬНО СМЕЩЕННЫХ ГИПОТЕЗ Глава 18. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЕ ДИСКРЕТНО-АНАЛОГОВЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ НА ФОНЕ АДДИТИВНЫХ ПОМЕХ 18.1.  АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЙ АЛГОРИТМ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ НЕЗАВИСИМОЙ ПОМЕХИ АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЙ АЛГОРИТМ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ НЕЗАВИСИМОЙ ПОМЕХИ18.2. УСТОЙЧИВОСТЬ АСИМПТОТИЧЕСКИ ОПТИМАЛЬНОГО АЛГОРИТМА ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННОГО СИГНАЛА 18.3. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЙ АЛГОРИТМ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ КОРРЕЛИРОВАННОЙ ПОМЕХИ 18.4. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЙ АЛГОРИТМ ОБНАРУЖЕНИЯ КВАЗИДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ НЕЗАВИСИМОЙ ПОМЕХИ 18.5. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЙ АЛГОРИТМ ОБНАРУЖЕНИЯ КВАЗИДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ КОРРЕЛИРОВАННОЙ ПОМЕХИ Глава 19. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЕ ЦИФРОВЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ НА ФОНЕ АДДИТИВНЫХ ПОМЕХ 19.1. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЙ ЦИФРОВОЙ АЛГОРИТМ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ НЕЗАВИСИМОЙ ПОМЕХИ 19.2. АСИМПТОТИЧЕСКИЕ СВОЙСТВА РАНГОВЫХ СТАТИСТИК 19.3. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЕ РАНГОВЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ НЕЗАВИСИМОЙ ПОМЕХИ 19.4. УСТОЙЧИВОСТЬ АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫХ РАНГОВЫХ АЛГОРИТМОВ ОБНАРУЖЕНИЯ ДЕТЕРМИНИРОВАННЫХ СИГНАЛОВ Глава 20.  РАЗЛИЧЕНИЕ СИГНАЛОВ НА ФОНЕ ПОМЕХ РАЗЛИЧЕНИЕ СИГНАЛОВ НА ФОНЕ ПОМЕХ20.1. ОПТИМАЛЬНЫЕ АЛГОРИТМЫ РАЗЛИЧЕНИЯ СИГНАЛОВ 20.2. РАЗЛИЧЕНИЕ ДЕТЕРМИНИРОВАННЫХ СИГНАЛОВ НА ФОНЕ АДДИТИВНОЙ ГАУССОВСКОЙ ПОМЕХИ 20.3. РАЗЛИЧЕНИЕ КВАЗИДЕТЕРМИНИРОВАННЫХ УЗКОПОЛОСНЫХ СИГНАЛОВ НА ФОНЕ АДДИТИВНОЙ ГАУССОВСКОЙ ПОМЕХИ 20.4. АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЕ АЛГОРИТМЫ РАЗЛИЧЕНИЯ СИГНАЛОВ Глава 21. ОЦЕНИВАНИЕ ПАРАМЕТРОВ И ФИЛЬТРАЦИЯ СИГНАЛОВ НА ФОНЕ ПОМЕХ 21.1. ОПТИМАЛЬНЫЕ АЛГОРИТМЫ ОЦЕНИВАНИЯ ПАРАМЕТРОВ ДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ АДДИТИВНОЙ ГАУССОВСКОЙ ПОМЕХИ 21.2. БАЙЕСОВСКИЕ АЛГОРИТМЫ ОЦЕНИВАНИЯ СЛУЧАЙНОЙ АМПЛИТУДЫ КВАЗИДЕТЕРМИНИРОВАННОГО СИГНАЛА НА ФОНЕ АДДИТИВНОЙ ГАУССОВСКОЙ ПОМЕХИ 21.3. ОПТИМАЛЬНАЯ ЛИНЕЙНАЯ ФИЛЬТРАЦИЯ 21.4. НЕЛИНЕЙНАЯ ФИЛЬТРАЦИЯ 21.5. ЗАДАЧИ Глава 22. АДАПТИВНЫЕ АЛГОРИТМЫ 22.1. ОПРЕДЕЛЕНИЕ И КРИТЕРИЙ КАЧЕСТВА АДАПТИВНОГО АЛГОРИТМА 22.2. АДАПТИВНЫЕ АЛГОРИТМЫ КЛАССИФИКАЦИИ НОРМАЛЬНЫХ СОВОКУПНОСТЕЙ 22.3. АДАПТИВНЫЕ АЛГОРИТМЫ КЛАССИФИКАЦИИ В УСЛОВИЯХ ПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ 22.  4. АДАПТИВНЫЕ АЛГОРИТМЫ КЛАССИФИКАЦИИ В УСЛОВИЯХ НЕПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ 4. АДАПТИВНЫЕ АЛГОРИТМЫ КЛАССИФИКАЦИИ В УСЛОВИЯХ НЕПАРАМЕТРИЧЕСКОЙ АПРИОРНОЙ НЕОПРЕДЕЛЕННОСТИ22.5. АДАПТИВНЫЕ АСИМПТОТИЧЕСКИ ОПТИМАЛЬНЫЕ АЛГОРИТМЫ ОБНАРУЖЕНИЯ СИГНАЛОВ НА ФОНЕ ПОМЕХ ПРИЛОЖЕНИЕ 1. ДЕЛЬТА-ФУНКЦИЯ ПРИЛОЖЕНИЕ 2. ПРЕОБРАЗОВАНИЕ ГИЛЬБЕРТА И АНАЛИТИЧЕСКИЙ СИГНАЛ СПИСОК ЛИТЕРАТУРЫ |

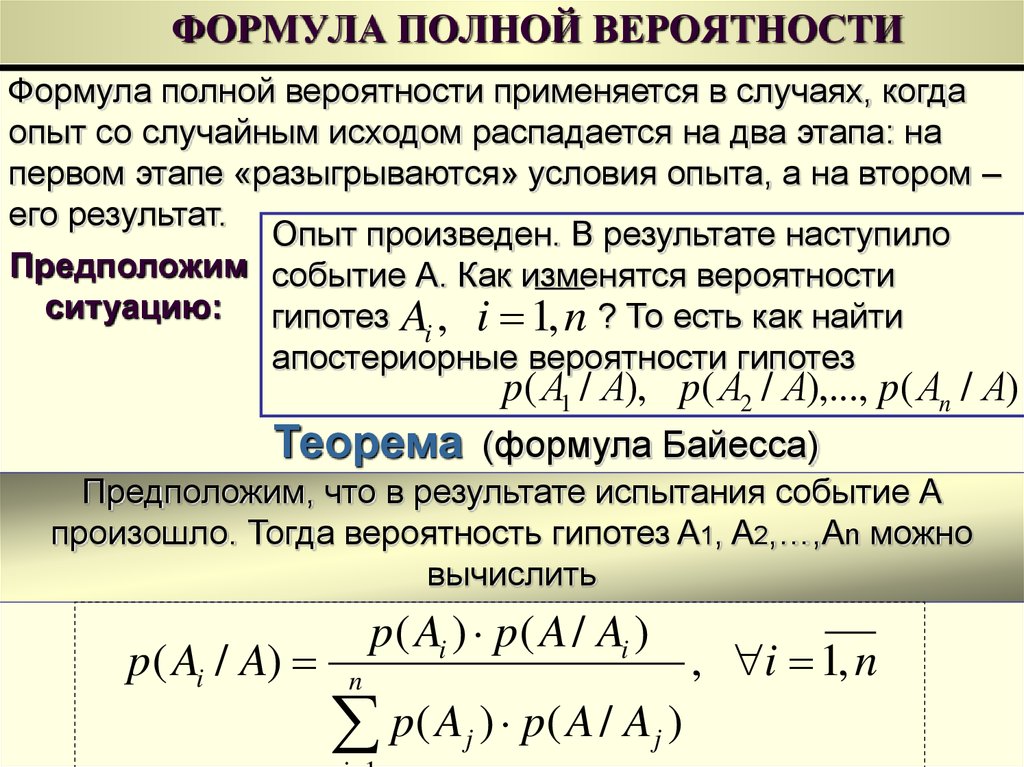

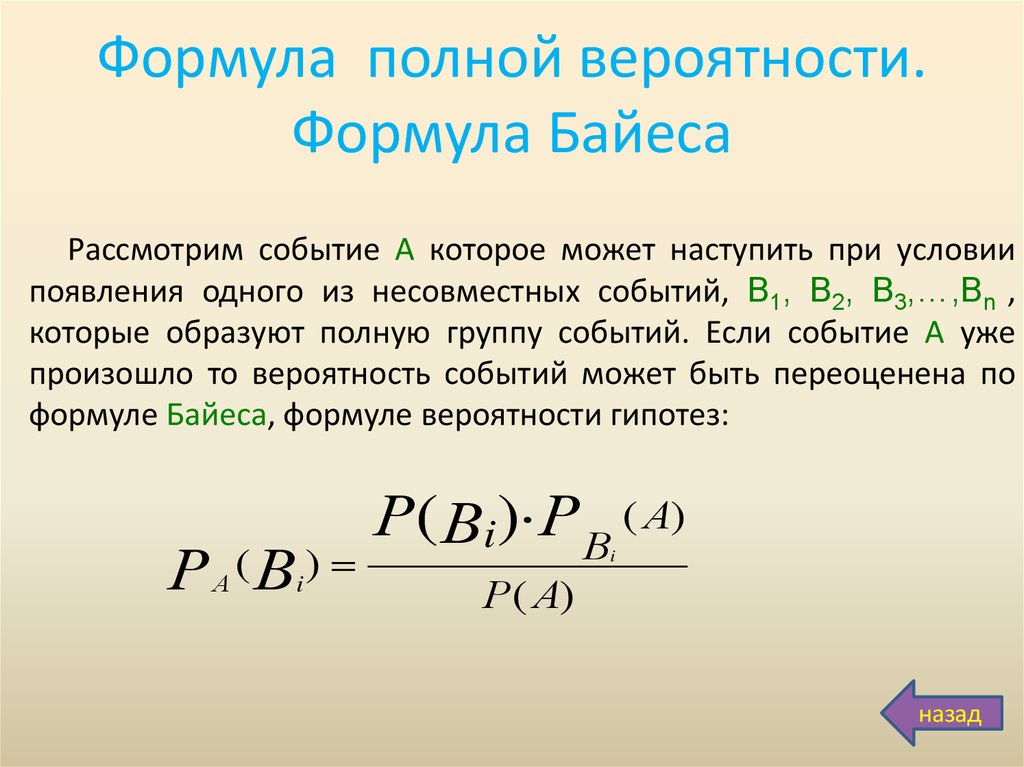

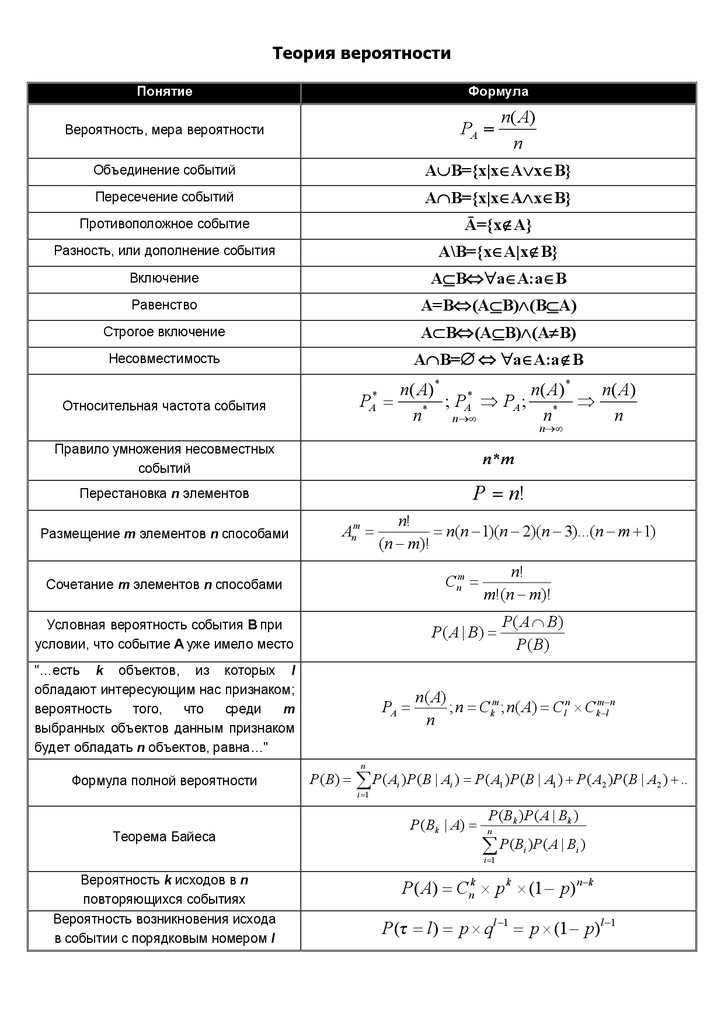

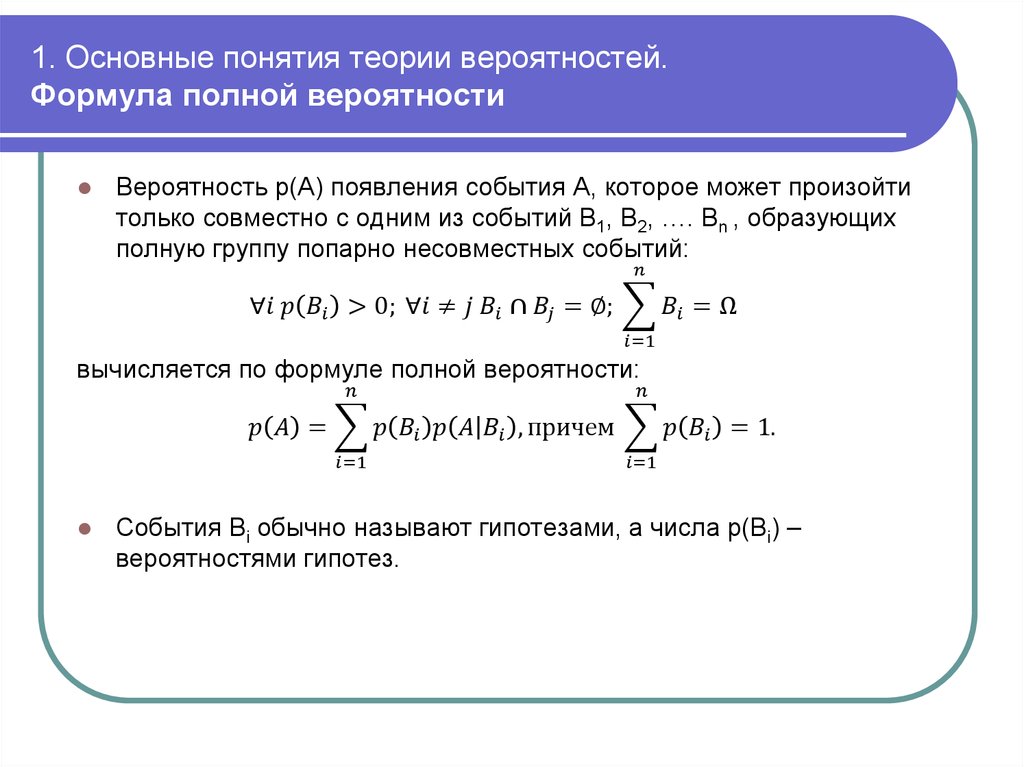

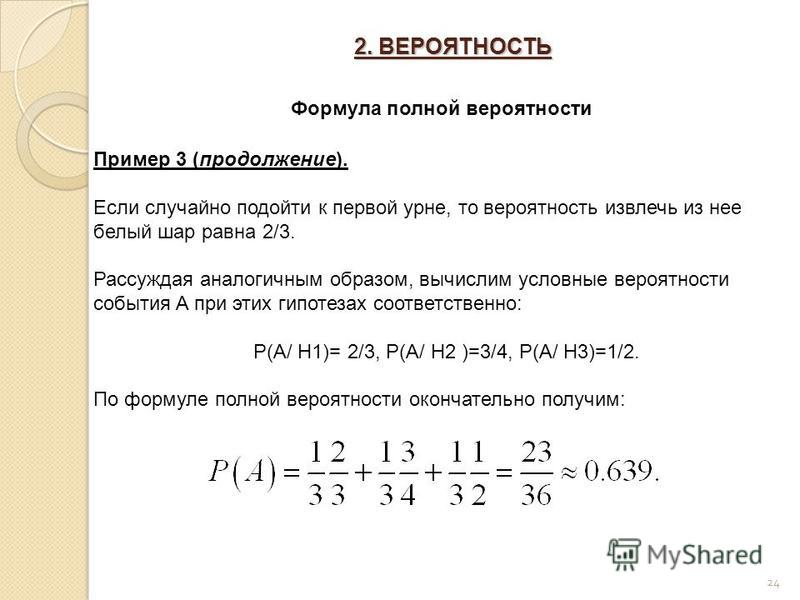

1.3.4. Формула полной вероятности и формула Байеса

Теорема. Пусть A — некоторое событие, и события H1, H2, ¼, Hn , , попарно несовместные, т. е. Hi Hj=Æ , I¹J, образующие полную группу, и появление одного из них и только одного есть событие достоверное.

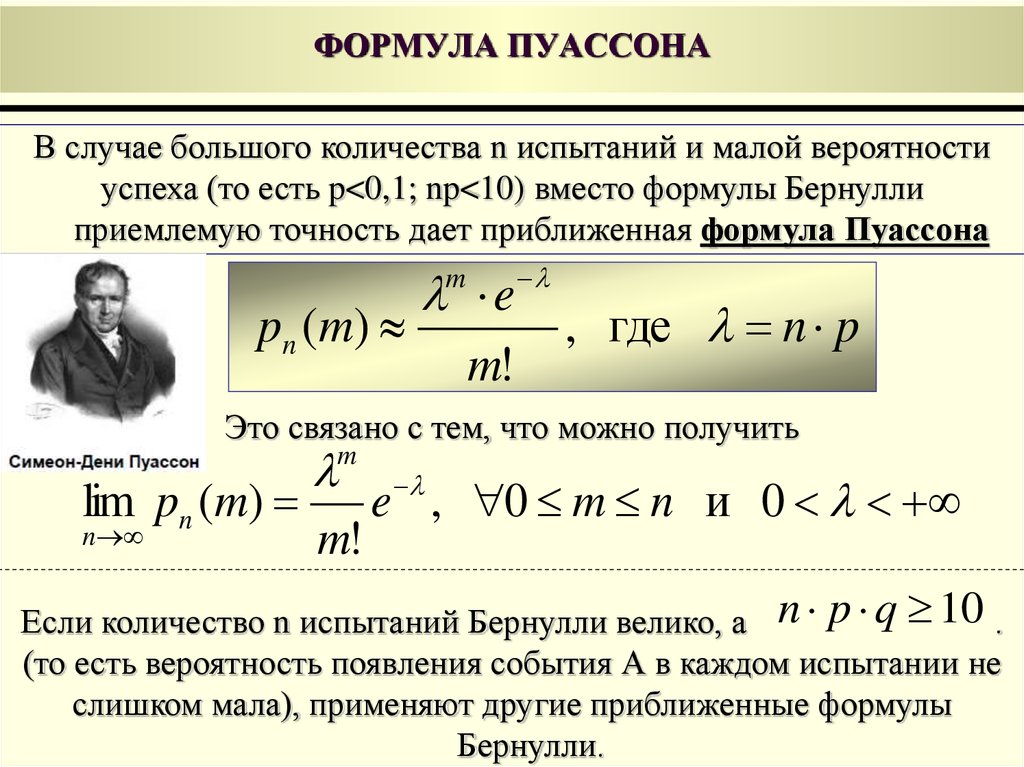

Допустим, что событие A Может произойти вместе с одним из событий Hi Тогда имеет место формула полной вероятности

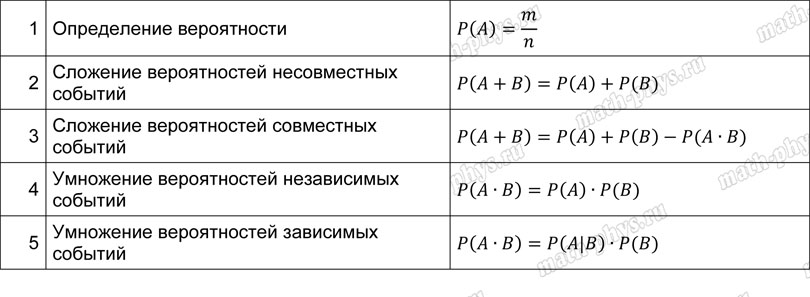

p(A) = P( A | Hi) (1.10)

И формула Байеса P(Hi | A)=. (1.11)

(1.11)

Замечание. События Hi называют Гипотезами, вероятности P(Hi) — Априорными вероятностями гипотез Hi, а вероятности P(Hi|A) — Апостериорными вероятностями гипотез Hi.

Пример 1.19. В первой урне находится 4 белых и 6 черных шаров, а во второй – 2 белых и 7 черных шаров. Из первой урны во вторую наудачу перекладывают один шар. После этого из второй урны наудачу извлекают один шар.

1) Найти вероятность, что шар, извлеченный из второй урны, белый.

2) Известно, что из второй урны извлечен белый шар. Найти вероятность того, что из первой урны во вторую был переложен черный шар.

Решение. Обозначим события

H1 = {из первой урны во вторую был переложен белый шар},

H2 = {из первой урны во вторую был переложен черный шар},

A = {шар, извлеченный из второй урны, белый}.

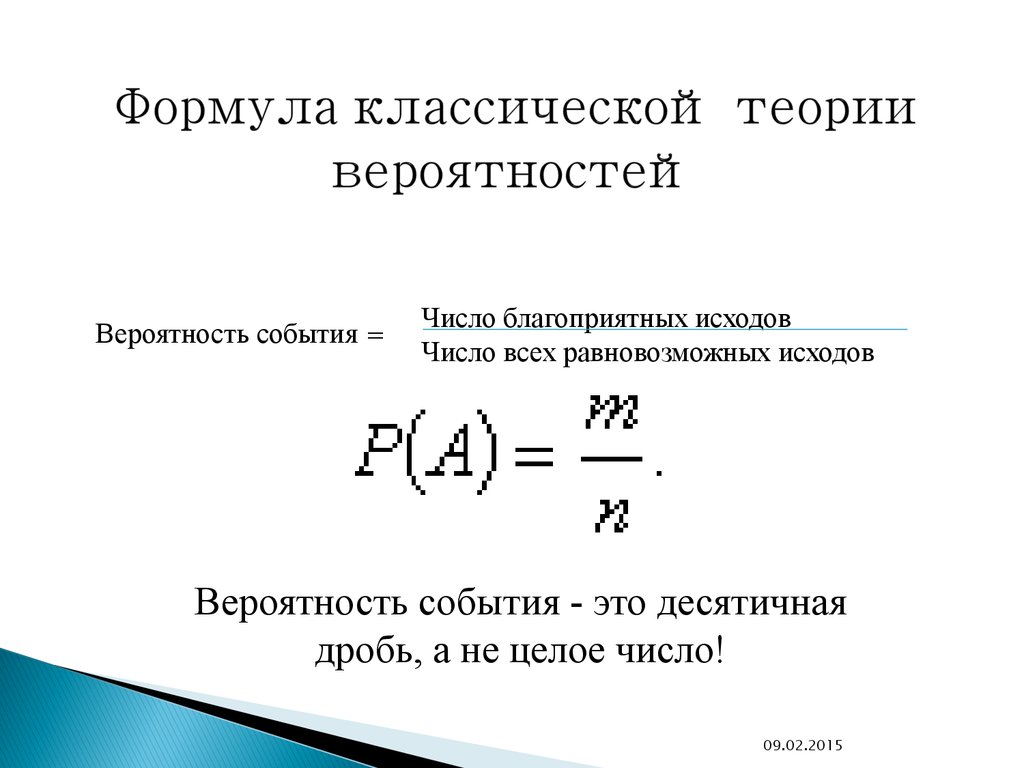

А) По классическому определению вероятности находим вероятности гипотез H1 И H2 :

P(H1) — вероятность того, что из всех находящихся в первой урне шаров во вторую был переложен Белый шар — P(H1) = 4 / 10 = 0,4,

P(H 2) — — вероятность того, что из всех находящихся в первой урне шаров во вторую был переложен Черный шар — P(H2) = 6/ 10 = 0,6,

И условные вероятности:

P(A/H1) – вероятность того, что из второй урны Будет вынут белый шар, при условии, что в нее был переложен белый шар — P(A/H1) = 3/10 = 0,3.

P(A/H2) — вероятность того, что из второй урны Будет вынут белый шар, при условии, что в нее был переложен черный шар — P(A/H2) = 2/10 = 0,2.

Тогда по формуле полной вероятности находим вероятность искомого события A

P(A) = p(H1) p(A/H1)+p(A/H2)P(H2) = 0,4×0,3 +0,6×0,2 = 0,24.

Б) Во второй части задачи требуется найти условную вероятность P(H2/A). Для этого можно использовать формулу Байеса (1.11):

P(H2/A) = .

Вопросы для самопроверки

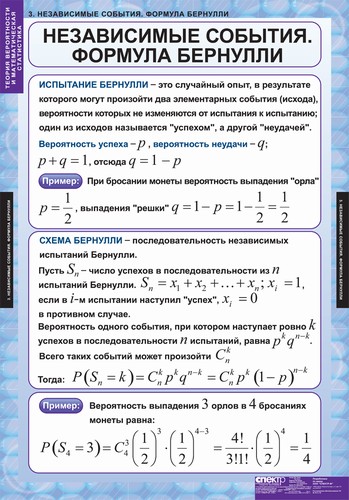

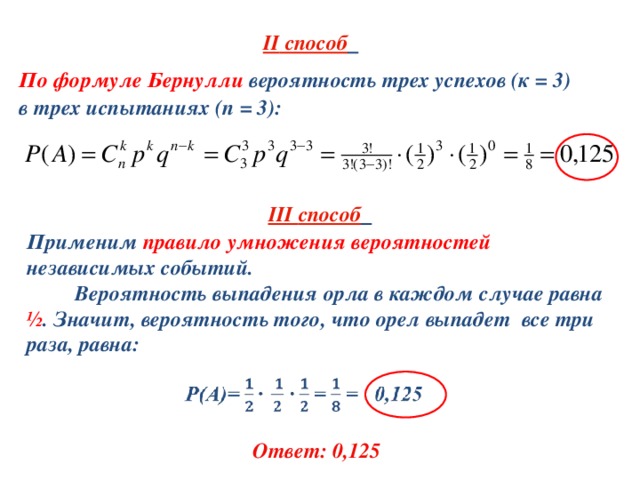

1. Какие условия должны быть выполнены для проведения опытов по схеме Бернулли?

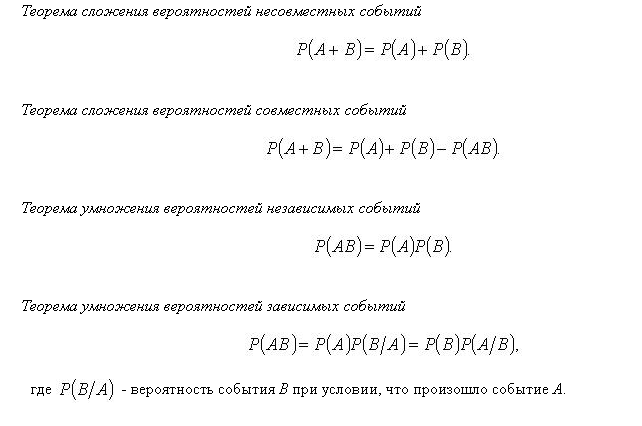

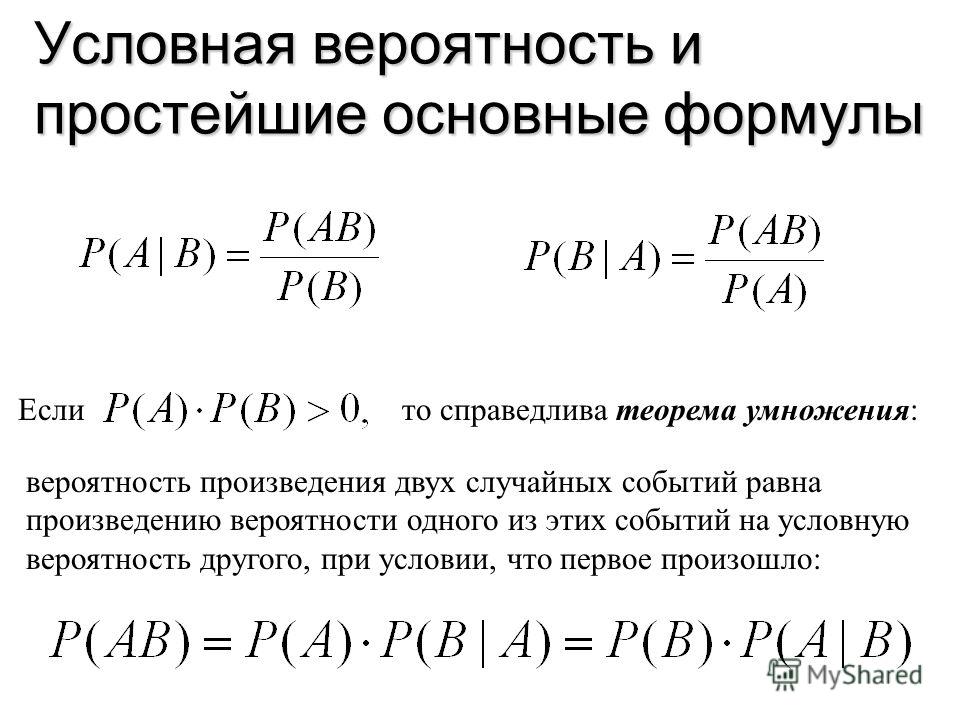

2. По какой формуле вычисляется условная вероятность?

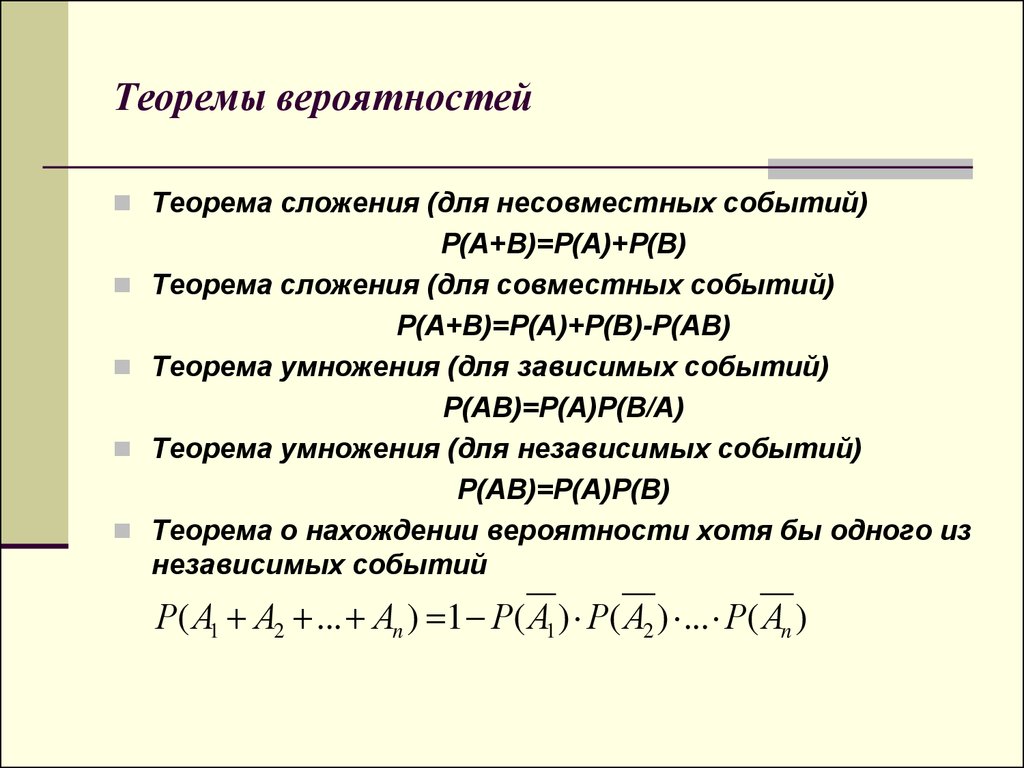

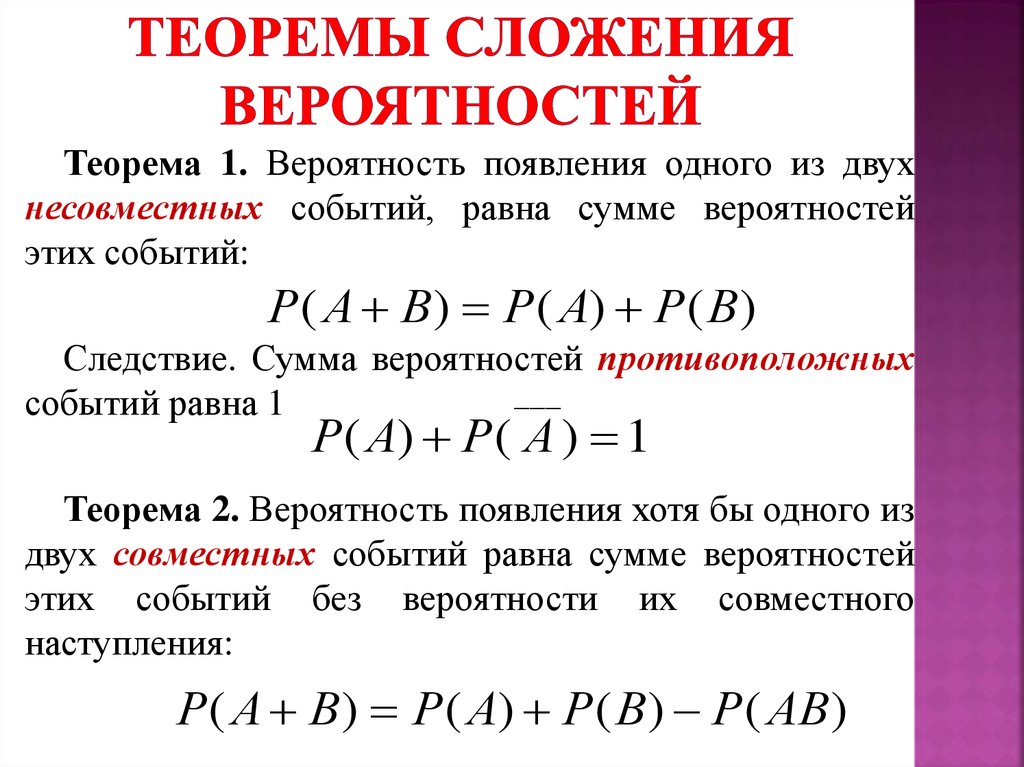

3. Как вычисляется вероятность произведения:

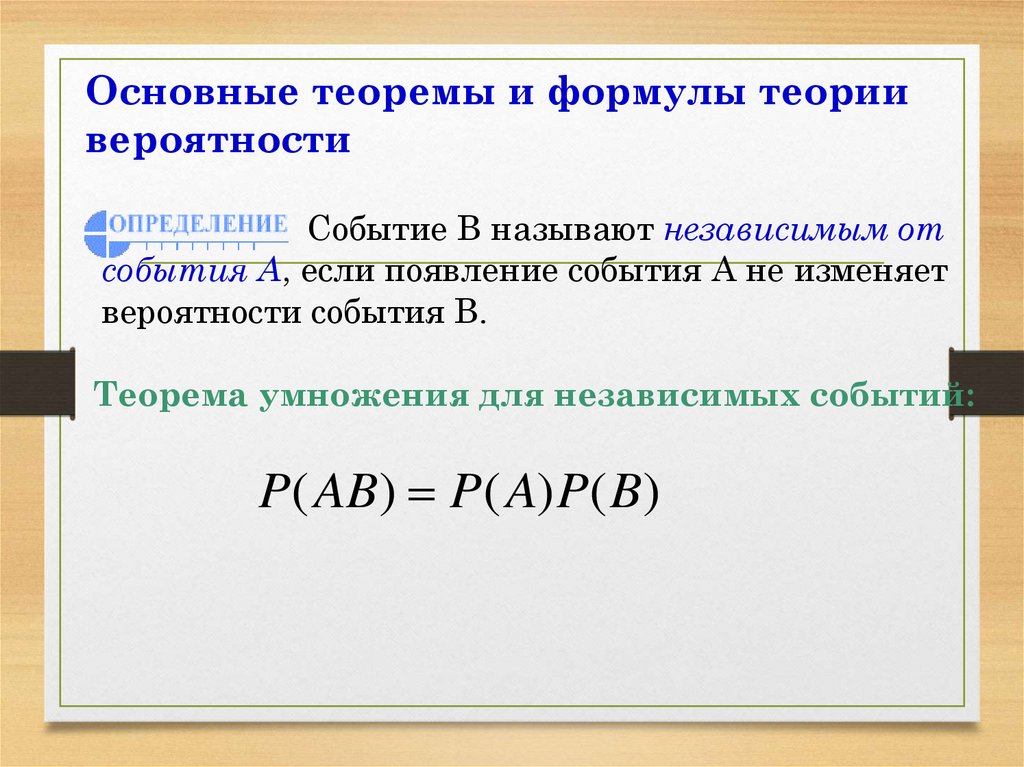

А) для независимых событий?

Б) для несовместных событий?

В) для любых других типов событий?

4. В чем смысл формулы полной вероятности?

В результате изучения материала Раздела 1 студент может выполнить задание № 1 из методических указаний по выполнению контрольной работы по вычислительной математике, основам теории вероятностей и элементам математической статистики ( [ 8 ] ).

| < Предыдущая | Следующая > |

|---|

Wolfram|Alpha Примеры: Вероятность

Wolfram|Альфа Примеры: Вероятность Ого! Wolfram|Alpha не работает без JavaScript.

Пожалуйста, включите JavaScript. Если вы не знаете, как это сделать, вы можете найти инструкции здесь. Как только вы это сделаете, обновите эту страницу, чтобы начать использовать Wolfram|Alpha.

Примеры для

Вероятность – это количественная оценка вероятности того, что событие или набор событий произойдет. Используя широкое вычислительное понимание вероятности Wolfram|Alpha и обширные знания о реальных приложениях теории вероятностей, вы можете вычислять шансы на победу в различных играх, основанных на случайности, проводить и анализировать экспериментальные результаты случайных испытаний, визуализировать и вычислять свойства распределения вероятностей и рассчитать вероятности событий при заданном наборе условий.

Азартные игрыПодсчитывайте выигрыши, анализируйте ставки и определяйте результаты азартных игр, начиная от подбрасывания монеты и заканчивая игрой в покер и розыгрышем номеров вашей местной лотереи.

Вычисление вероятности выпадения монеты:

32 подбрасывания монетыВычисление вероятности выпадения костей:

5 игральных костейВычисление шансов на покерную комбинацию:

покерный фулл-хаусАнализ ставки в рулетке:

Ставка на угол в рулеткеАнализ ставки

8:5 шансы, ставка 97 евроПолучить лотерею шансы:

lotteryДругие примерыВероятность дня рождения

Вычислите вероятность того, что люди в группе имеют общий день рождения, или исследуйте вероятность того, что день рождения людей приходится на определенный диапазон дат, месяц или определенный день недели.

Вычислить вероятность общих дней рождения в группе людей:

парадокс дней рождения 50 человекУказать количество возможных дней рождения:

парадокс дней рождений, 4 человека, 100 возможных дней рожденияВычислить вероятность общих дней рождения для заданного интервала:

шанс 3 человека родились в один и тот же день неделивероятность 5 человек родились в один и тот же день неделивероятность 2 человека родились в один месяц Испытания БернуллиОпределить вероятность любого исхода для любого числа или спецификации испытаний Бернулли.

Вычисление вероятностей для последовательности испытаний:

вероятность 8 успешных попыток в 14 попытках с p=0,6Анализ вероятностей времени ожидания:

число попыток до 15-го успехаНайти вероятность серии:

серия из 12 успешных попыток в 40 испытанияхБольше примеровФормулы вероятности

Вычислите вероятности различных составов событий или задайте отдельные вероятности, чтобы определить вероятность того, что некоторые, все события или их отсутствие.

Вычислить вероятность объединения событий:

Вероятность объединения трех событийВычислить условную вероятность:

Формула условной вероятностиВычислить вероятность дополнения:

Вероятность дополненияДАЛЬШЕ

Статистика Web App

СВЯЗАННЫЕ ПРИМЕРЫ

Вычислить конкретное свойство распределения вероятностей, вероятность того, что результат имеет место, или исследовать определяющие характеристики обширного набора распределений вероятностей.

Вычислить свойства распределения вероятностей:

Распределение ПуассонаЗадать параметры для распределения:

нормальное распределение, среднее=0, sd=2Вычислить конкретное свойство:

standard deviation of Student t, 17 degrees of freedomMore examples- Pro

- Web Apps

- Mobile Apps

- Products

- Business

- API & Developer Solutions

- Resources & Tools

- About

- Contact

- Подключиться

- 0085

- wolfram.

com

com - Язык Wolfram

- Mathematica

- Демонстрации Wolfram

- Wolfram for Education

- MathWorld

- Определение условной вероятности

- Как работает условная вероятность?

- Условная вероятность независимых событий

- Условная вероятность взаимодействующих событий

- Условная формула и расчет

- Пример

- Пример № 1

- Раствор

- . Пример № 2

- № 1

- . Вероятность и теорема Байеса

- Часто задаваемые вопросы (FAQ)

- Рекомендуемые статьи

Вы можете использовать это изображение на своем веб-сайте, в шаблонах и т. д. Пожалуйста, предоставьте нам ссылку на авторствоКак указать авторство?Ссылка на статью должна быть гиперссылкой

Например:

Источник: Условная вероятность (wallstreetmojo.com)- Условная вероятность выражает вероятность того, что определенное событие произойдет на основе другого ранее произошедшего исхода. Это важная часть теории вероятностей, но она отличается от безусловной вероятности.

- Для лиц, принимающих решения, политиков, инженеров, специалистов по данным и других специалистов очень важно определить вероятный результат плана, решения или действия.

- Правила условной вероятности могут быть основаны либо на предположениях, либо на доказательствах, и различаются для независимых и взаимоисключающих. Взаимоисключающие. Взаимоисключающие относятся к тем статистическим событиям, которые не могут происходить одновременно. Таким образом, эти события полностью независимы друг от друга, т. е. результат одного события не влияет на результат другого события. Подробнее о событиях.

- Теорема Байеса — не что иное, как математическая формула условного шанса или вероятности. Он получил свое название от Томаса Байеса, известного британского математика 18-го века.

Как работает условная вероятность?

Как в профессиональной, так и в личной жизни человеку нравится иметь представление о том, что может или не может произойти в данной ситуации, исходя из другого уже произошедшего события.

Условный шанс или вероятность могут рассказать о вероятности исхода на основе условий, преобладающих в предыдущем происшествии.

Условный шанс или вероятность могут рассказать о вероятности исхода на основе условий, преобладающих в предыдущем происшествии.Это важный компонент теории вероятностей. Однако он отличается от безусловной вероятности, когда шансы возникновения события не зависят от предыдущего результата или условия.

Вы можете использовать это изображение на своем веб-сайте, в шаблонах и т. д. Пожалуйста, предоставьте нам ссылку на авторство. Как указать авторство? Ссылка на статью должна быть гиперссылкой

Например:

Источник: Условная вероятность (wallstreetmojo.com)Математическая формула, используемая для расчета вероятности исхода А в зависимости от условия B это:

P(A) = P(A|B)

Несколько примеров условной вероятности показывают, как концепция может помочь вывести вероятность события. Для лучшего понимания рассмотрим два случая:

Условная вероятность независимых событий

Независимое событиеНезависимое событиеНезависимое событие — широко используемый в статистике термин, обозначающий множество двух событий, в которых появление одного из событий не влияет на возникновение другого события из набора.

Читать далее происходит, когда результат или условие предыдущего (B) или последующего (A) события не имеет отношения ни к тому, ни к другому. Отсюда формула:

Читать далее происходит, когда результат или условие предыдущего (B) или последующего (A) события не имеет отношения ни к тому, ни к другому. Отсюда формула:P(A|B) = P(A)

Найдем вероятность того, что одна карта окажется валетом (J) из колоды из 52 карт.

- В колоде хорошо перетасованных карт четыре валета.

- Вероятность того, что игрок получит валета, составляет 4/52 или 1/13.

Однако, как только вводится условие, что карты Валета являются красными (R), приведенный выше пример превращается в условный шанс или вероятность.

- В этом случае количество красных валетов в колоде равно двум, а общее количество красных карт равно 26, учитывая, что остальные 26 карт черные.

- После применения условия относительно вероятности ранее произошедшего события условная вероятность того, что карта Валета принадлежит красным мастям, снова становится равной 2/26 или 1/13.

События, происходящие здесь, считаются независимыми друг от друга, поскольку вероятность того, что карта и красная, и валет никак не влияют друг на друга.

Следовательно, расчет условной вероятности будет следующим:

Следовательно, расчет условной вероятности будет следующим:P(J|R) = P(J)

Где,

- P(J|R) = Вероятность (Карта Валет|Должна быть Красной)

- J – Карта Валет

- R – Карта Красная где буква справа от столбца обозначает событие, а слева от столбца — условие, управляющее уравнением.

Условная вероятность взаимоисключающих событий

Это ситуация, когда одно событие отрицает вероятность возникновения другого события. Подбрасывание монеты является ярким примером этого. Если человек получает решку (H) при подбрасывании монеты, у него нет шансов получить решку (T) в этот момент. Другими словами, тот, кто подбрасывает монету, получит одну из сторон, но никогда обе одновременно.

Поскольку эти два события не могут произойти одновременно, их условный шанс или вероятность всегда будет равна нулю. Это означает, во взаимоисключающей ситуации:

P(H|T) = 0

P(T|H) = 0

Формула условной вероятности и расчет

Формула условной вероятности для события, которое не является ни взаимоисключающим, ни независимым:

P(A|B) = P (A∩B)/P(B) , где:

- P(A|B) обозначает условный шанс, т.

е. вероятность наступления события A по отношению к условию B.

е. вероятность наступления события A по отношению к условию B. - P(A∩B) обозначает совместную вероятность наступления обоих событий . Это не то, что оба события охватывают по отдельности, а общий фактор, который связывает их обоих для достижения результата.

- P(B) — вероятность B.

Давайте проверим часть расчета условной вероятности, используя эту формулу, в следующем разделе.

Пример условной вероятности

Пример №1

- B1 и B2 — это две коробки.

- В первой коробке пять мячей для сквоша — три синих и два зеленых.

- Во второй коробке семь мячей для сквоша — один синий и шесть зеленых.

Карл случайным образом достает мяч для сквоша из каждой коробки. Насколько вероятно, что Карл выберет -?

- Синий мяч для сквоша (B)

- Зеленый мяч для сквоша (G)

- Зеленый мяч для сквоша (G) от B2

Решение

Общее количество мячей для сквоша (B1+B2) = 5+7 = 12

- Вероятность выбора синего мяча для сквоша = Количество синих мячей для сквоша/Общее количество.

мячей для сквоша

мячей для сквоша

P(B) = (3+1)/12

= 4/12

= 1/3

- Вероятность выбора зеленого мяча для сквоша = количество зеленых мячей для сквоша /Общее количество мячей для сквоша

P(G) = (2+6)/12

= 8/12

= 2/3

- Вероятность выбора зеленого мяча для сквоша из B2 = Количество зеленых мячей для сквоша в B2/Общее количество. шаров для сквоша в B2

P(G|B2) = 6/7

Третий сценарий является примером условного шанса или вероятности, когда событие G необходимо вычислить на основе условия B2.

Пример #2

На книжной ярмарке, на которой присутствовало 300 человек, 130 человек купили художественную литературу (F). Семьдесят человек выбрали научно-популярную литературу (N), а 100 посетителей выбрали книги обоих жанров. Если случайно выбранный покупатель купил художественную книгу, какова вероятность того, что этот же человек купит и научно-популярную книгу?

Решение

- Вероятность того, что люди выберут художественную литературу, т.

е. P(F) = 130/300

е. P(F) = 130/300

= 0,43

- Вероятность того, что люди выберут художественную и научно-популярную литературу, т. е. P(N∩F) = 100/300

= 0,33

Вероятность того, что случайный человек с художественными книгами также выберет документальную литературу, т. е.

- Вероятность того, что случайный человек с художественными книгами также выберет документальную литературу, т. е. P(N| F) = P(F∩N)/P(F)

= 0,33/0,43

= 0,767 = 0,8 (приблизительно)

Таким образом, вероятность того, что случайный покупатель выберет научно-популярную книгу, если он уже купил художественную книгу, составляет 80%.

Условная вероятность и теорема Байеса

Использование условной вероятности или вероятности помогает людям и организациям понять, к чему приведут их усилия. Что касается теоремы Байеса, то это не что иное, как математическая формула, названная в честь британского математика Томаса Байеса для расчета вероятности.

Он помогает определить индивидуальные условные вероятности предшествующих и последующих событий. Кроме того, это дает больше шансов для одного события, учитывая, что другое событие произошло на основе новых или дополнительных доказательств.

Он помогает определить индивидуальные условные вероятности предшествующих и последующих событий. Кроме того, это дает больше шансов для одного события, учитывая, что другое событие произошло на основе новых или дополнительных доказательств.Вы можете использовать это изображение на своем веб-сайте, в шаблонах и т. д. Пожалуйста, предоставьте нам ссылку на авторство. Как указать авторство? Ссылка на статью должна быть гиперссылкой

Например:

Источник: Условная вероятность (wallstreetmojo.com)Давайте рассмотрим следующий сценарий, чтобы установить связь между условным шансом и теоремой Байеса. В примере A и B — это два события в демонстрационном пространстве. Таким образом, вероятность наступления события А при уже произошедшем событии В и наоборот будет равна:

P(A|B) = P (A∩B)/P(B) и P(B|A) = P (A∩B)/P(A)

После их объединения два, уравнение будет таким:

P (A ∩ B) = P (A|B)*P (B) = P (B|A)*P(A)

Из приведенного выше следующее полученное уравнение:

P(A|B)* P(B) = P(B|A)*P(A)

P(A|B) = [P(B|A)* P(A)]/P(B) ———— [Теорема Байеса]

Часто задаваемые вопросы (FAQ)

Что такое условная вероятность?

Условная вероятность или вероятность указывает на вероятность того, что конкретное событие произойдет на основании другого исхода или условия, которое произошло ранее.

Оно может быть основано либо на предположениях, либо на доказательствах.

Оно может быть основано либо на предположениях, либо на доказательствах.Какова формула условной вероятности?

Формула условной вероятности для события, которое не является ни взаимоисключающим, ни независимым:0176 — P(A|B) обозначает условный шанс или вероятность, т. е. вероятность того, что событие A произойдет при заданном условии B.

— P(A∩B) — это вероятность того, что оба события произойдут вместе. Это общий фактор, связывающий оба события для окончательного условного шанса или вероятностного исхода.

– P(B) – вероятность B.Зачем нам условная вероятность?

Эта концепция широко применима во многих областях, включая бизнес, страхование, личную жизнь, вычисления, политику и т. д., помогая физическим и юридическим лицам определять возможные результаты и принимать соответствующие практические решения. Кроме того, лица, принимающие решения, политики, инженеры, специалисты по данным и другие специалисты используют этот метод для определения вероятности возникновения определенного события или результата.

- P(A|B) обозначает условный шанс, т.

- Как работает условная вероятность?

Условная вероятность относится к вероятности наступления определенного события при условии, что ранее произошло другое событие. Он широко применим во многих областях, включая управление бизнес-рисками, страхование, личную жизнь, вычисления, политику и т. д., помогая физическим и юридическим лицам определять возможные результаты и принимать соответствующие практические решения.

Эта оценка может быть основана либо на предположениях, либо на фактических данных, в зависимости от характера желаемого или ожидаемого результата. Его математическая формула включает умножение вероятности предыдущего события (В) на шансы появления следующего события (А). Лица, принимающие решения, политики, инженеры, специалисты по данным и другие специалисты используют этот метод для определения вероятности возникновения определенного события или результата.

Содержание

- wolfram.

com

com

Условный шанс или вероятность могут рассказать о вероятности исхода на основе условий, преобладающих в предыдущем происшествии.

Условный шанс или вероятность могут рассказать о вероятности исхода на основе условий, преобладающих в предыдущем происшествии. Читать далее происходит, когда результат или условие предыдущего (B) или последующего (A) события не имеет отношения ни к тому, ни к другому. Отсюда формула:

Читать далее происходит, когда результат или условие предыдущего (B) или последующего (A) события не имеет отношения ни к тому, ни к другому. Отсюда формула: Следовательно, расчет условной вероятности будет следующим:

Следовательно, расчет условной вероятности будет следующим: е. вероятность наступления события A по отношению к условию B.

е. вероятность наступления события A по отношению к условию B. мячей для сквоша

мячей для сквоша е. P(F) = 130/300

е. P(F) = 130/300 Он помогает определить индивидуальные условные вероятности предшествующих и последующих событий. Кроме того, это дает больше шансов для одного события, учитывая, что другое событие произошло на основе новых или дополнительных доказательств.

Он помогает определить индивидуальные условные вероятности предшествующих и последующих событий. Кроме того, это дает больше шансов для одного события, учитывая, что другое событие произошло на основе новых или дополнительных доказательств. Оно может быть основано либо на предположениях, либо на доказательствах.

Оно может быть основано либо на предположениях, либо на доказательствах.