Что такое остаточная дисперсия? (Определение и пример)

Остаточная дисперсия (иногда называемая «необъяснимой дисперсией») относится к дисперсии в модели, которая не может быть объяснена переменными в модели.

Чем выше остаточная дисперсия модели, тем меньше модель способна объяснить изменение данных.

Остаточная дисперсия появляется на выходе двух разных статистических моделей:

1. Дисперсионный анализ: используется для сравнения средних значений трех или более независимых групп.

2. Регрессия: используется для количественной оценки взаимосвязи между одной или несколькими переменными-предикторами и переменной отклика .

В следующих примерах показано, как интерпретировать остаточную дисперсию в каждом из этих методов.

Остаточная дисперсия в моделях ANOVAВсякий раз, когда мы подбираем модель ANOVA («дисперсионный анализ»), мы получаем таблицу ANOVA, которая выглядит следующим образом:

Значение остаточной дисперсии модели ANOVA можно найти в столбце SS («сумма квадратов») для варианта внутри групп .

Это значение также называется «сумма квадратов ошибок» и рассчитывается по следующей формуле:

Σ( Xij – Xj ) 2

куда:

- Σ : греческий символ, означающий «сумма».

- X ij : i -е наблюдение в группе j

- X j : среднее значение группы j

В приведенной выше модели ANOVA мы видим, что остаточная дисперсия составляет 1100,6.

Чтобы определить, является ли эта остаточная дисперсия «высокой», мы можем рассчитать среднюю сумму квадратов для внутри групп и среднюю сумму квадратов для между группами и найти соотношение между ними, что приводит к общему F-значению в таблице ANOVA.

- F = MS между / MS внутри

- F = 96,1/40,76296

- F = 2,357

Значение F в приведенной выше таблице ANOVA равно 2,357, а соответствующее значение p равно 0,113848. Поскольку это p-значение не меньше α = 0,05, у нас нет достаточных доказательств, чтобы отклонить нулевую гипотезу.

Это означает, что у нас нет достаточных доказательств, чтобы сказать, что средняя разница между группами, которые мы сравниваем, значительно отличается.

Это говорит нам о том, что остаточная дисперсия в модели ANOVA высока по сравнению с вариацией, которую модель фактически может объяснить.

Остаточная дисперсия в регрессионных моделяхВ регрессионной модели остаточная дисперсия определяется как сумма квадратов разностей между прогнозируемыми точками данных и наблюдаемыми точками данных.

Он рассчитывается как:

Σ(ŷ i – y i ) 2

куда:

- Σ : греческий символ, означающий «сумма».

- ŷ i : прогнозируемые точки данных

- y i : наблюдаемые точки данных

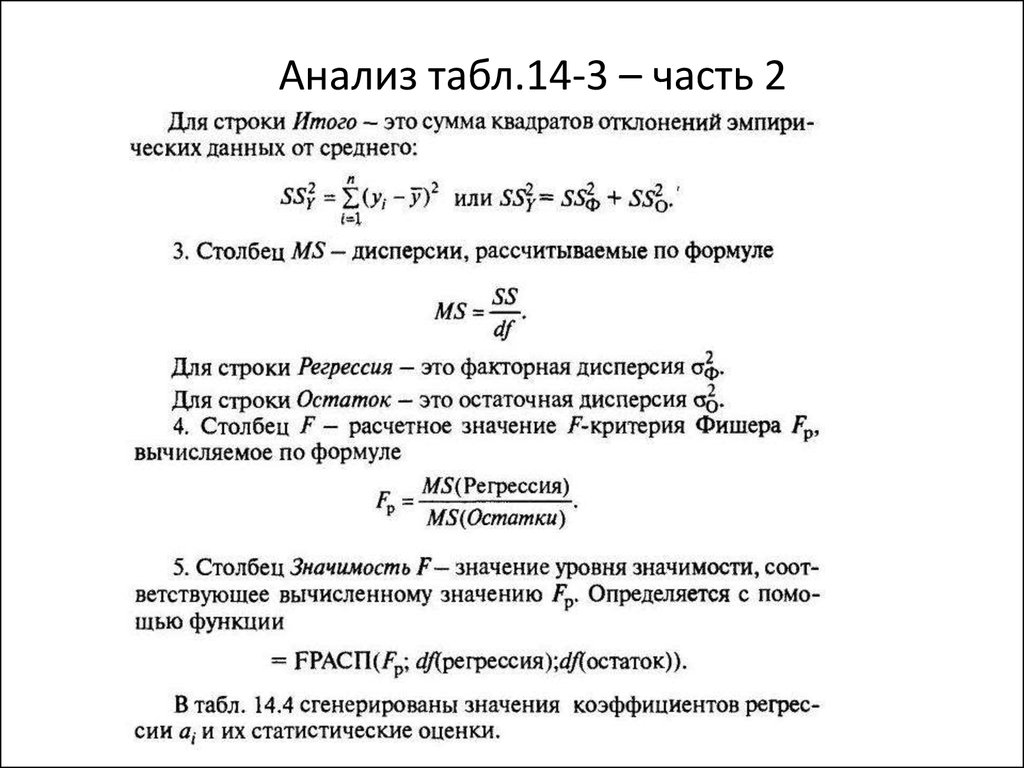

Когда мы подбираем регрессионную модель, мы обычно получаем результат, который выглядит следующим образом:

Значение остаточной дисперсии модели ANOVA можно найти в столбце SS («сумма квадратов») для остаточной вариации.

Отношение остаточной вариации к общей вариации в модели говорит нам о проценте вариации переменной отклика, которая не может быть объяснена предикторными переменными в модели.

Например, в приведенной выше таблице мы рассчитали бы этот процент как:

- Необъяснимая вариация = SS Residual / SS Total

- Необъяснимая вариация = 5,9024 / 174,5

- Необъяснимая вариация = 0,0338

Мы также можем рассчитать это значение, используя следующую формулу:

- Необъяснимая вариация = 1 – R 2

- Необъяснимая вариация = 1 – 0,96617

- Необъяснимая вариация = 0,0338

Значение R-квадрата для модели говорит нам о процентной вариации переменной отклика, которая может быть объяснена переменной-предиктором.

Таким образом, чем ниже необъяснимая вариация, тем лучше модель способна использовать переменные-предикторы для объяснения вариации переменной отклика.

Дополнительные ресурсыЧто такое хорошее значение R-квадрата?

Как рассчитать R-квадрат в Excel

Как рассчитать R-квадрат в R

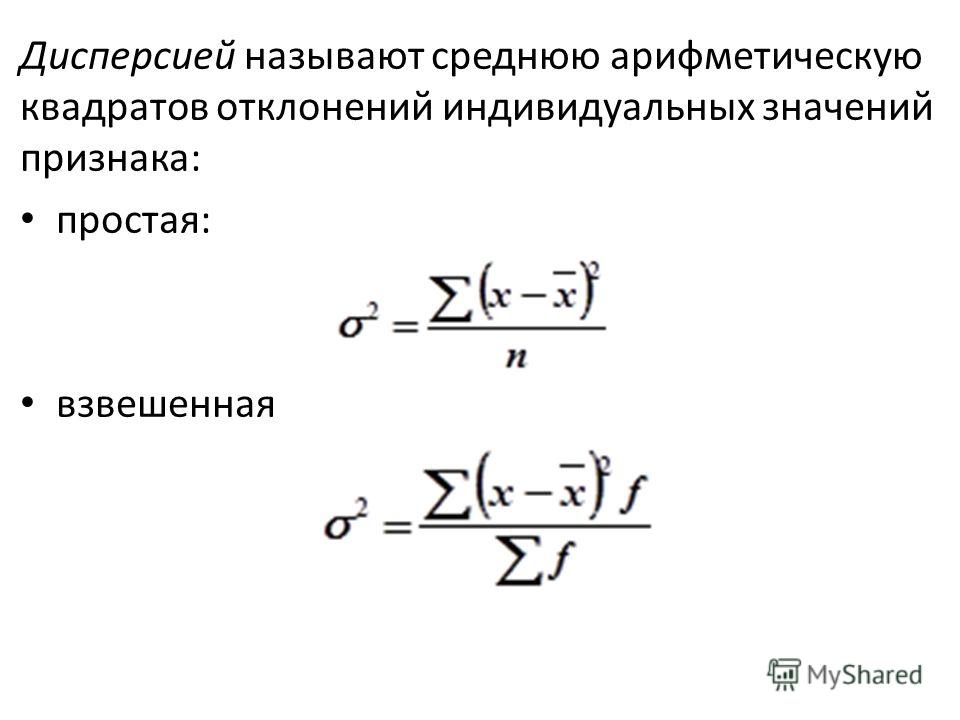

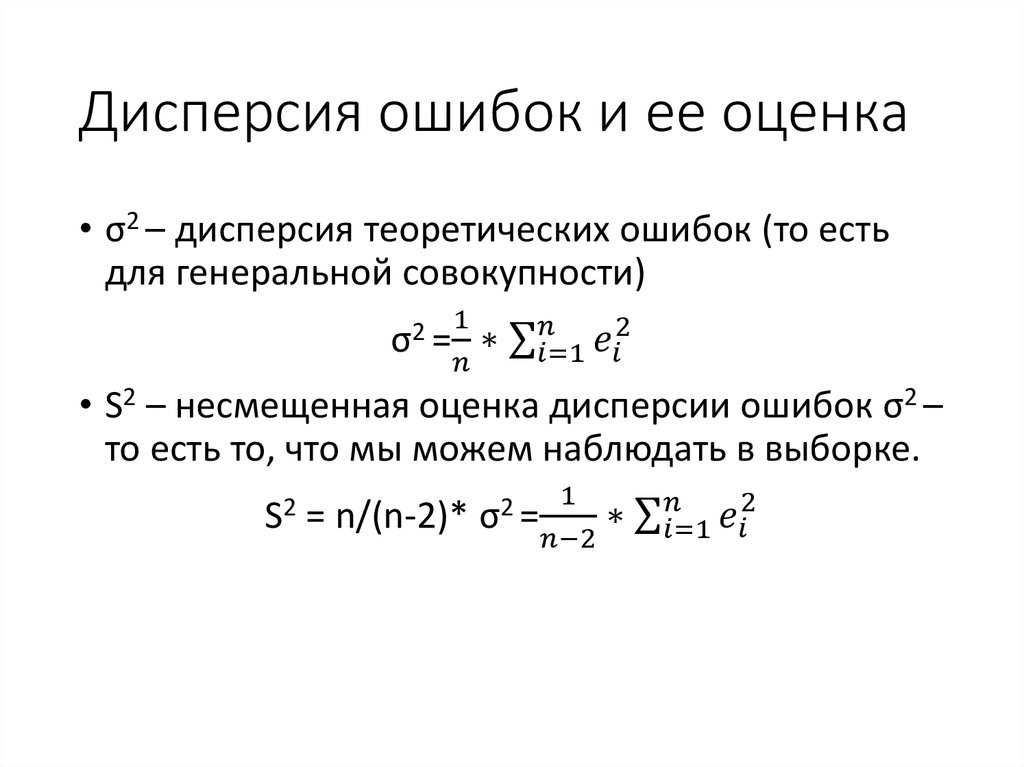

Остаточной дисперсией называется величина

(11)

В знаменателе

остаточной дисперсии стоит число

степеней свободы равное (n – 2), а не n, так как две степени свободы теряются

при определении двух параметров (a, b).

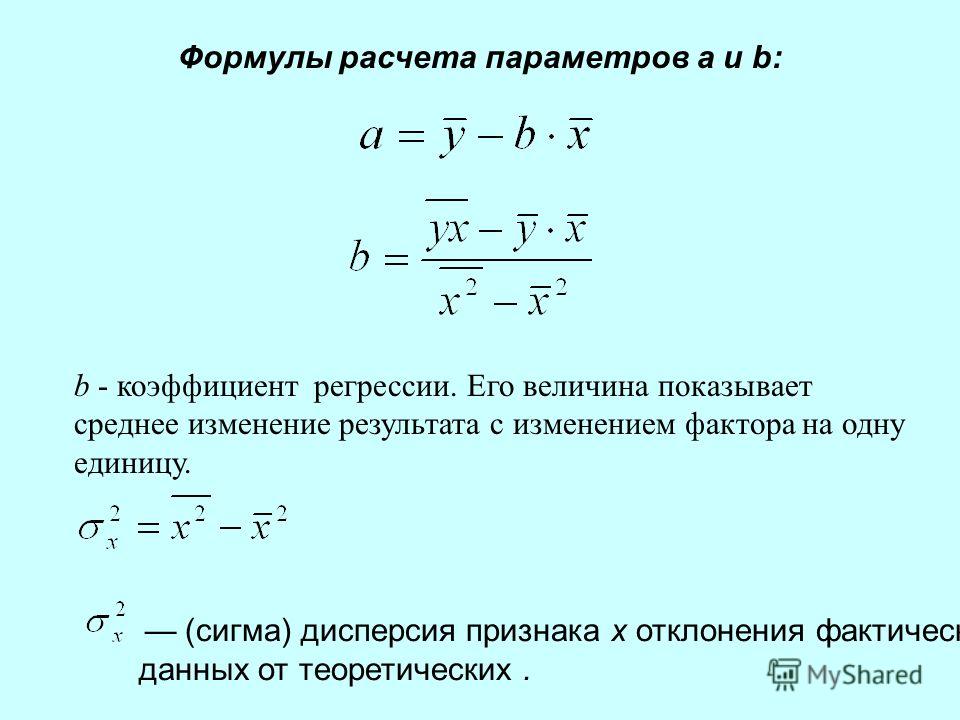

Далее вычислим значения математических ожиданий и дисперсий для коэффициентов а и b. Для коэффициента a мы имеем:

(12)

Для коэффициента b получаем:

(13)

Подставив в выражения теоретических дисперсий параметров a и b вместо σ2 ее оценку S2, получим оценки дисперсий этих параметров:

. (15)

Для проверки значимости коэффициентов a и b вычислим статистики:

, , (16)

здесь Sa, Sb— стандартные

ошибки коэффициентов регрессии т. е.

е.

; .

Статистики ta и tb подчиняются распределению Стьюдента с числом степени свободы v = n – 2. Выдвинем гипотезу Н0: a = 0 и для заданного уровня значимости α (обычно α = 0,05) и числа степеней свободы v = n – 2 найдем из таблицы распределения критерия Стьюдента критическое значение tкр = t(α,v).

Если ta > tкр гипотезу Н0 отвергаем и считаем коэффициент а значимо отличным от нуля.

Если ta > tкр у нас нет оснований отвергать гипотезу Н0 т. е. в этом случае считаем, что коэффициент а не значимо отличается от нуля.

Аналогично производится проверка на значимость и коэффициента b.

Выборочный коэффициент парной корреляции между переменными x и y определяемый по выборке из n наблюдений вычисляется по формуле: (17)

Более удобным для практических расчетов значений rxy является формула: (18)

Выборочный

коэффициент парной корреляции дает

количественную оценку тесноты линейной

связи между переменными x и y.

Он является безразмерной величиной и

изменяется в диапазоне —1

≤ rxy ≤ 1. Если rxy = 1, это

означает, что между переменными x и y существует прямо пропорциональная

линейная функциональная зависимость,

если rxy = -1 это

означает, что между переменными x и y существует обратно пропорциональная

линейная функциональная зависимость. Если rxy = 0, то это

означает, что между переменными x и y линейной зависимости нет (хотя нелинейная

зависимость может существовать), в этом

случае говорят, что переменные x и y некоррелированы. В случае, когда -1

< rxy < 1, говорят

что переменные x и y стохастически (вероятностно) линейно

связаны. Значимость этой зависимости

проверяется следующим образом: вычисляется

статистика:

Если rxy = 0, то это

означает, что между переменными x и y линейной зависимости нет (хотя нелинейная

зависимость может существовать), в этом

случае говорят, что переменные x и y некоррелированы. В случае, когда -1

< rxy < 1, говорят

что переменные x и y стохастически (вероятностно) линейно

связаны. Значимость этой зависимости

проверяется следующим образом: вычисляется

статистика:

(19)

Статистика trподчиняется распределению Стьюдента с числом степени свободы v = n – 2. Выдвигается нулевая гипотеза Н0: ρxy = 0. Далее для заданного уровня значимости α и числа степени свободы v = n – 2 по таблице распределения критерия Стьюдента находим tкр

Если |tr| > tкр, то нулевая гипотеза об отсутствии линейной зависимости между переменными x и y отвергается, в этом случае переменные x и y считаются коррелированными.

Если |tr| < tкр, то у нас нет оснований для того, чтобы отвергнуть нулевую гипотезу, в этом случае мы должны признать, что между переменными x и y не существует значимой линейной зависимости т. е. они не коррелированы.

Теперь покажем, что проверка на значимость выборочного коэффициента парной корреляции rxy и коэффициента детерминации R2 эквивалентны. С одной стороны:

(20)

с другой стороны

(21)

Из формул (20) и (21) следует, что

(22)

Из формулы (22)

следует, что tr=

из чего делаем вывод о том, что проверка

на значимость выборочного коэффициента

парной корреляции rxy и коэффициента детерминации R2эквивалентны.

Наблюдаемые значения объясняемой переменной yi () отличаются от прогнозируемых значений , рассчитанных по уравнению регрессии. Чем меньше эти отличия, тем ближе прогнозируемые значения подходят к наблюдаемым значениям yi, и тем лучше качество построенной модели. Величина отклонения наблюдаемого и прогнозируемого значения объясняемой переменной по каждому наблюдению представляет собой ошибку аппроксимации. Так как может быть как величиной положительной, так и отрицательной, то ошибку аппроксимации для каждого наблюдения принято определять в процентах и по модулю.

Выражение можно рассматривать как абсолютную ошибку аппроксимации, а выражение:

как относительную ошибку аппроксимации для i-го наблюдения.

Чтобы иметь показатель, характеризующий качество модели в целом, определяют среднюю ошибку аппроксимации по всем наблюдениям в выборке по формуле:

.

Считается [2, 3], что построенное уравнение регрессии достаточно хорошо прогнозирует наблюдаемые значения объясняемой переменной, если .

В прогнозных расчетах по построенному уравнению регрессии (2) определяется предсказываемое значение, как точечный прогноз при x = xp, т. е. путем подстановки в уравнение регрессии (2) соответствующего значения объясняющей переменной x. Однако надо признать, что точечный прогноз явно не реален. Поэтому он дополняется расчетом стандартной ошибки т.е. и соответственно интервальной оценкой наблюдаемых значений.

Ошибка предсказания равна разности между предсказанным и действительным значениями:

.

Ошибка предсказания имеет нулевое математическое значение:

Вычислим дисперсию прогноза, поскольку

то для дисперсии прогноза имеем

Заменяя в дисперсии прогноза на ее оценку S2 и извлекая квадратный корень, получим стандартную ошибку предсказания

.

Доверительный интервал для действительного значения yp определяется выражением:

,

где tкр – критическое значение t – статистики при заданном уровне значимости и соответствующем объему выборки числе степеней свободы.

На Рис. 1 отрезок отмеченный стрелками определяет доверительный интервал истинного значения объясняемой переменной yp относительно предсказанного по уравнению регрессии значения .

Рис. 1

Теперь рассмотрим

на конкретном примере, как применяется

на практике изложенная выше теория

парного линейного регрессионного

анализа.

В качестве примера рассмотрим зависимость между сменной добычей торфа на одного рабочего y(т) и мощностью пласта x(м) по следующим (условным) данным, характеризующим процесс добычи торфа в n = 10 карьерах.

Таблица 1

I | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

xi | 4 | 11 | 14 | 9 | 8 | 8 | 15 | 9 | 8 | 12 |

yi | 2 | 8 | 10 | 6 | 4 | 5 | 12 | 4 | 5 | 9 |

Для определения

вида зависимости между x и y построим корреляционное поле ( смотрите

Рис. 2 ):

2 ):

Рис. 2

По расположению точек на корреляционном поле полагаем, что зависимость между x и y линейная: y = a + bּx.

По формулам, приведенным ранее, находим:

;

;

;

;

;

;

;

;

;

;

;

;

Для повышения наглядности вычислений по МНК построим таблицу 2:

Таблица 2

№ | xi | yi | x2i | xiּyi | y2i | Аi | ||||

1 | 4 | 2 | 16 | 8 | 4 | 1. | 20.250 | 29.155 | 0.809 | 44.950 |

2 | 11 | 8 | 121 | 88 | 64 | 7.617 | 2.250 | 1.248 | 0.147 | 4.775 |

3 | 14 | 10 | 196 | 140 | 100 | 10.410 | 12.250 | 15.288 | 0.168 | 4.110 |

4 | 9 | 6 | 81 | 54 | 36 | 5. | 0.250 | 0.555 | 0.066 | 4.667 |

5 | 8 | 4 | 64 | 32 | 16 | 4.824 | 6.25 | 2.808 | 0.679 | 20.625 |

6 | 8 | 5 | 64 | 40 | 25 | 4.824 | 2.25 | 2.808 | 0.031 | 3.500 |

7 | 15 | 12 | 225 | 180 | 144 | 11. | 30.25 | 23.435 | 0.424 | 5.483 |

8 | 9 | 4 | 81 | 36 | 16 | 5.755 | 6.25 | 0.555 | 3.081 | 43.900 |

9 | 8 | 5 | 64 | 40 | 25 | 4.824 | 2.25 | 2.808 | 0.031 | 3.500 |

10 | 12 | 9 | 144 | 108 | 81 | 8. | 6.25 | 4.195 | 0.204 | 5.011 |

∑ | 98 | 65 | 1056 | 726 | 511 | 65 | 88.50 | 82.856 | 5.044 | 139.92 |

среднее | 9.8 | 6.5 | 105.6 | 72.6 | 51.1 | 6.5 | 8.85 | 8.286 | 0.564 | 13.992 |

Теперь определим

значимость параметров a = -2.623 и b = 0,931, входящих

в построенное уравнение регрессии. Для

этого зададимся уровнем значимости α = 0,05; вычислим число степеней свободы v = n – 2 = 10 – 2 = 8.

И далее по таблице распределения критерия

Стьюдента определим tкр = t(α,v1)

= t(0,05;

8) = 2,301.

Так как ta = 2,972 > tкр = 2,301 и tb = 10.837 > tкр = 2,301 оба

параметра значимо отличаются от нуля

и должны быть оставлены в модели. Значит,

построенное уравнение регрессии будет

иметь вид:

Для

этого зададимся уровнем значимости α = 0,05; вычислим число степеней свободы v = n – 2 = 10 – 2 = 8.

И далее по таблице распределения критерия

Стьюдента определим tкр = t(α,v1)

= t(0,05;

8) = 2,301.

Так как ta = 2,972 > tкр = 2,301 и tb = 10.837 > tкр = 2,301 оба

параметра значимо отличаются от нуля

и должны быть оставлены в модели. Значит,

построенное уравнение регрессии будет

иметь вид:

(23)

Теперь определим,

насколько хорошо построенное уравнение

регрессии описывает наблюдаемые значения y.

Для этого снова зададимся уровнем

значимости α = 0,05; найдем

по формулам: k1 = 1, k2 = n – 2 = 10 – 2 = 8 числа степеней свободы; далее по таблице

распределения критерия Фишера — Снедекора

найдем Fкр = F(α, k1, k2)

= F(0,05;1;8)

= 5,320. Так как F = 117,000 > Fкр = 5,320; то

делаем вывод, что построенное уравнение

регрессии адекватно описывает наблюдаемые

значения переменной y и им можно пользоваться для прогнозирования

значений y

при соответствующих значениях x.

Так как F = 117,000 > Fкр = 5,320; то

делаем вывод, что построенное уравнение

регрессии адекватно описывает наблюдаемые

значения переменной y и им можно пользоваться для прогнозирования

значений y

при соответствующих значениях x.

Для построенной модели значение коэффициента детерминации R2 = 0,936; что свидетельствует о том, что 93,6% вариации значений переменной y объясняется изменчивостью переменной x, и только 6,4% вариации значений y объясняется воздействием случайного фактора.

Для построенной модели значение выборочного коэффициента корреляции есть rxy = 0,968. По формуле (19) вычислим значение . (24)

Выдвинем гипотезу Н0:

ρxy = 0. Зададимся

уровнем значимости α = 0,05, вычислим v = n – 2= 10 – 2 = 8 и по таблице распределения критерия

Стьюдента найдем tкр = 2,310.

Для tкри tr выполняется неравенство tr = 10.823 > tкр = 2,301 из которого мы делаем вывод, что нулевая гипотеза должна быть отвергнутаи мы должны признать, что между переменными x и y существует значимая линейная зависимость. Это является еще одним подтверждением адекватности построенного уравнения регрессии (23).

Откуда в простой линейной регрессии берется формула дисперсии остатков?

Интуиция о знаках «плюс», связанных с дисперсией (из того факта, что даже когда мы вычисляем дисперсию разности независимых случайных величин, мы складываем их дисперсии) верна, но фатально неполна: если вовлеченные случайные величины не являются независимыми, то участвуют и ковариации, причем ковариации могут быть отрицательными. Существует выражение равное 92(\bar x/S_{xx}) $$

$i$-й остаток определяется как

$$\hat u_i = y_i — \hat y_i = (\beta_0 — \hat \beta_0) + ( \beta_1 — \hat \beta_1)x_i +u_i$$

Фактические коэффициенты рассматриваются как константы, регрессор фиксирован (или зависит от него) и имеет нулевую ковариацию с членом ошибки, , но оценок коррелируют с ошибкой, потому что оценки содержат зависимую переменную, а зависимая переменная содержит ошибку. Итак, у нас есть 90$ равно , а не , включенным в оценки, но не равно нулю для ошибки оценки, потому что $y_i$ и, следовательно, $u_i$ являются частью выборки и поэтому включены в оценку. У нас есть

Итак, у нас есть 90$ равно , а не , включенным в оценки, но не равно нулю для ошибки оценки, потому что $y_i$ и, следовательно, $u_i$ являются частью выборки и поэтому включены в оценку. У нас есть

$$2\text{Cov}([(\beta_0 — \hat \beta_0) + (\beta_1 — \hat \beta_1)x_i],u_i) = 2E\left([(\beta_0 — \hat \ beta_0) + (\beta_1 — \hat \beta_1)x_i]u_i\right)$$

$$=-2E\left(\hat \beta_0u_i\right)-2x_iE\left(\hat \beta_1u_i\right) = -2E\left([\bar y -\hat \beta_1 \bar x]u_i\right)-2x_iE\left(\hat \beta_1u_i\right)$$ 92}{S_{xx}}\right)$$

Так что снимаю шляпу перед текстом, который использует ОП.

(я пропустил некоторые алгебраические манипуляции, неудивительно, что алгебра МНК в наши дни преподается все меньше и меньше…)

НЕКОТОРАЯ ИНТУИЦИЯ

Таким образом, оказывается, что то, что работает «против» нас (большая дисперсия) при предсказании, работает «на нас» (более низкая дисперсия) при оценке. Это хорошая отправная точка для размышлений о том, почему отличное соответствие может быть плохим знаком для прогнозирующих способностей модели (как бы нелогично это ни звучало. ..).

..).

Тот факт, что мы оцениваем ожидаемое значение регрессора, уменьшает дисперсию на $1/n$. Почему? потому что, оценивая , мы «закрываем глаза» на некоторую ошибку-изменчивость , существующую в выборке, поскольку мы, по сути, оцениваем ожидаемое значение. Более того, чем на больше отклонение наблюдения регрессора от среднего значения выборки регрессора, тем на меньше будет дисперсия остатка, связанного с этим наблюдением… чем более отклоняется наблюдение, тем меньше отклоняется его остаток. .. Это 90 $ будет иметь тенденцию сбиваться … на более научном языке «оптимальные предикторы в смысле уменьшенной дисперсии ошибки прогнозирования представляют собой сокращение по отношению к среднему прогнозируемой переменной». Мы не пытаемся воспроизвести изменчивость зависимой переменной — мы просто стараемся оставаться «близкими к среднему».

«дисперсия остатков» по сравнению с предполагаемой дисперсией остатков?

спросил

Изменено 4 месяца назад

Просмотрено 3к раз

$\begingroup$

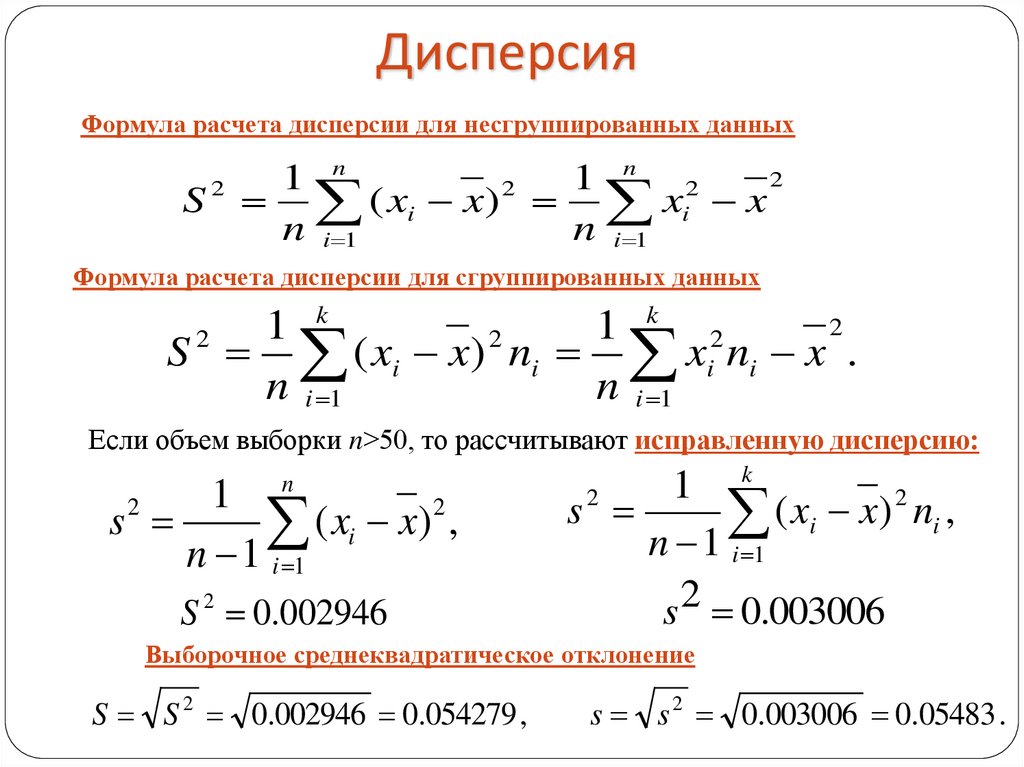

Мне дали задание «рассчитать дисперсию остатков, полученных из вашего уравнения». Это была простая линейная регрессия, поэтому я подумал: «Хорошо, это просто сумма квадратов остатков, деленная на $(n — 2)$, поскольку она потеряла две степени свободы при оценке коэффициента пересечения и наклона». Неправильный. Он не хотел, чтобы я оценивал остаточную дисперсию. Вместо этого мне сказали, что я должен разделить его на $(n — 1)$. Я не понимаю, зачем это делать.

Это была простая линейная регрессия, поэтому я подумал: «Хорошо, это просто сумма квадратов остатков, деленная на $(n — 2)$, поскольку она потеряла две степени свободы при оценке коэффициента пересечения и наклона». Неправильный. Он не хотел, чтобы я оценивал остаточную дисперсию. Вместо этого мне сказали, что я должен разделить его на $(n — 1)$. Я не понимаю, зачем это делать.

Дисперсия может быть рассчитана только вокруг параметра, и она представляет собой сумму отклонений от этого (или тех) параметров, деленную на степени свободы в зависимости от размера выборки и ограничений параметра. Если мы описательно вычисляем дисперсию одной переменной в одной совокупности, параметр будет средним, поэтому степени свободы будут $(n — 1)$. Я понимаю это и понимаю, почему это правда. Но если параметр представляет собой «подогнанное уравнение», относящееся к простой линейной модели, я не вижу никакого способа использовать два параметра и, следовательно, иметь $(n — 2)$ степеней свободы при обсуждении дисперсии остатков. \dagger$ Статистика, которую предлагает ваш преподаватель, включает поправку Бесселя для стандартная выборка IID, но остатки не являются выборкой такого рода, и, следовательно, статистика, которую он предлагает, не является беспристрастной оценкой чего-либо полезного здесь.

\dagger$ Статистика, которую предлагает ваш преподаватель, включает поправку Бесселя для стандартная выборка IID, но остатки не являются выборкой такого рода, и, следовательно, статистика, которую он предлагает, не является беспристрастной оценкой чего-либо полезного здесь.

Возможно, ваш преподаватель хотел, чтобы вы вычислили «выборочную дисперсию» остатков, используя стандартную формулу, возможно, чтобы подчеркнуть, что в данном случае это не эквивалентно оценке несмещенной дисперсии ошибки. Возможно, он пытается преподать здесь некоторый урок о различиях между несмещенной оценкой дисперсии в случае IID и несмещенной оценкой в регрессионной модели. В любом случае, вы, похоже, хорошо разбираетесь в вопросе, так что не переживайте, если вас неправильно отметили. 9\dagger$ В комментариях whuber указывает, что «дисперсия» выборки значений иногда рассматривается как сумма квадратов, деленная на $n$ — это определение исходит из того факта, что это дисперсия эмпирическое распределение выборки.

100

100 755

755 341

341 548

548