Наибольший общий делитель 24 и 48

Калькулятор «Наибольший общий делитель»

Какой наибольший общий делитель у чисел 24 и 48?

Ответ: Наибольший общий делитель чисел 24 и 48 это: 24

(двадцать четыре)

Нахождение наибольшего общего делителя для чисел 24 и 48 используя перечисление всех делителей

Первый способ нахождения НОД для чисел 24 и 48 — это перечисление всех делителей для обоих чисел и выбор из них наибольшего общего:

Все делители числа 24 : 1, 2, 3, 4, 6, 8, 12, 24

Все делители числа 48 : 1, 2, 3, 4, 6, 8, 12, 16, 24, 48

Следовательно, наибольший общий делитель для чисел 24 и 48 это 24

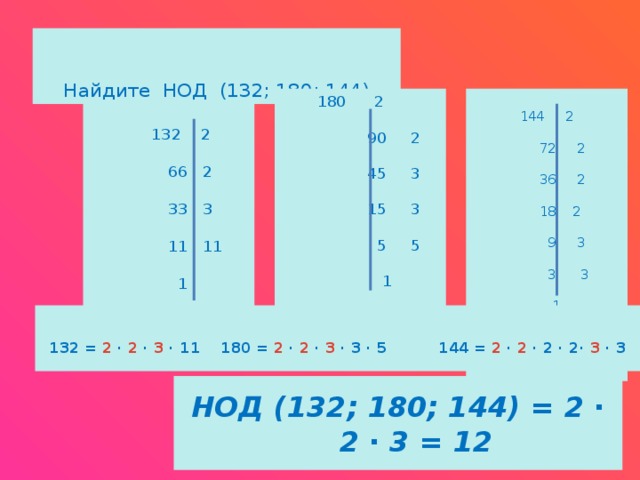

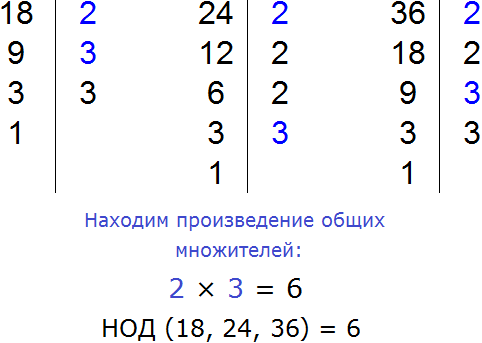

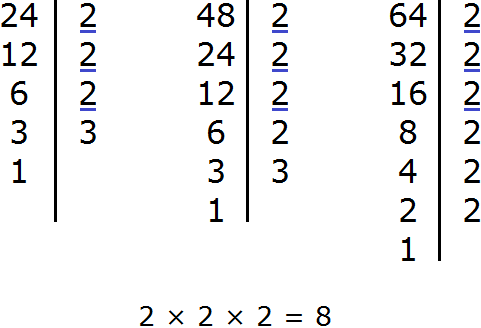

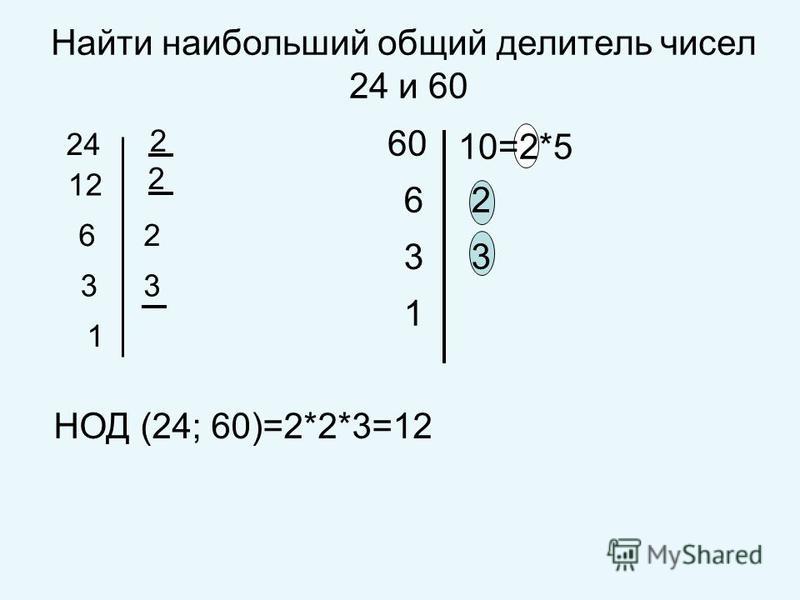

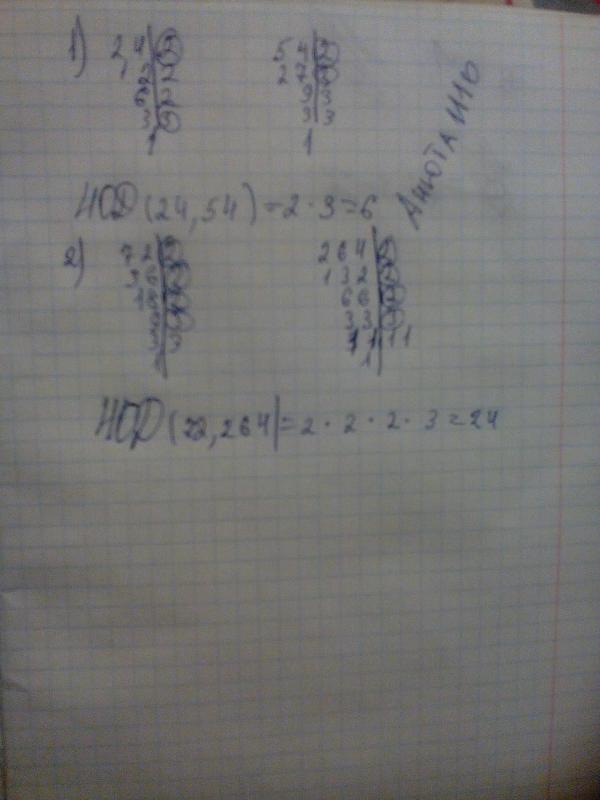

Нахождение наибольшего общего делителя для чисел 24 и 48 используя разложение чисел на простые множители

Второй способ нахождения наибольшего общего делителя для числе 24 и 48 — это перечисление всех простых множителей для чисел и перемножение общих.

Простые множители числа 24 : 2, 2, 2, 3

Простые множители числа 48 : 2, 2, 2, 2, 3

Как мы видим, у чисел есть общие простые множители: 2, 2, 2, 3

Для нахождения НОД необходимо их перемножить: 2 × 2 × 2 × 3 = 24

Поделитесь текущим расчетом

Печать

https://calculat.io/ru/number/greatest-common-factor-of/24—48

<a href=»https://calculat.io/ru/number/greatest-common-factor-of/24—48″>Наибольший общий делитель 24 и 48 — Calculatio</a>

О калькуляторе «Наибольший общий делитель»

Данный калькулятор поможет найти наибольший общий делитель двух чисел. Например, Какой наибольший общий делитель у чисел 24 и 48? Выберите первое число (например ’24’) и второе число (например ’48’). После чего нажмите кнопку ‘Посчитать’.

Наибольший общий делитель (НОД) для двух чисел - это наибольшее положительное целое число, которое делит каждое из целых чисел с нулевым остатком.

Калькулятор «Наибольший общий делитель»

Таблица наибольших общих делителей

| Число 1 | Число 2 | НОД |

|---|---|---|

| 9 | 48 | 3 |

| 10 | 48 | 2 |

| 11 | 48 | 1 |

| 12 | 48 | 12 |

| 13 | 48 | 1 |

| 14 | 48 | 2 |

| 15 | 48 | 3 |

| 16 | 48 | 16 |

| 17 | 48 | 1 |

| 18 | 48 | 6 |

| 19 | 48 | 1 |

| 20 | 48 | 4 |

| 21 | 48 | 3 |

| 22 | 48 | 2 |

| 23 | 48 | 1 |

| 24 | 48 | 24 |

| 25 | 48 | 1 |

| 26 | 48 | 2 |

| 27 | 48 | 3 |

| 28 | 48 | 4 |

| 29 | 48 | 1 |

| 30 | 48 | 6 |

| 31 | 48 | 1 |

| 32 | 48 | 16 |

| 33 | 48 | 3 |

| 34 | 48 | 2 |

| 35 | 48 | 1 |

| 36 | 48 | 12 |

| 37 | 48 | 1 |

| 38 | 48 | 2 |

Числа 24:12 Валаам ответил Валаку: «Разве я уже не сказал посланникам, которых ты послал ко мне

New International Version

Валаам ответил Валаку: «Разве я не сказал посланникам, которых ты послал ко мне,

New Living Translation

Валаам сказал Валаку , «Разве ты не помнишь, что я сказал твоим посланникам? Я сказал:

English Standard Version

И Валаам сказал Валаку: «Разве я не говорил твоим посланникам, которых ты послал ко мне,

Верийская стандартная Библия

Валаам ответил Валаку , «Разве я уже не сказал посланникам, которых вы послали мне

Библия короля Иакова

И Валаам сказал Валаку: я не говорил и с посланными твоими, которых ты посылал ко мне, говоря:

New King James Version

И сказал Валаам Валаку: ты послал ко мне, говоря:

Новая американская стандартная Библия

И Валаам сказал Валаку: «Разве я не говорил посланным твоим, которых ты послал ко мне, говоря:

NASB 1995

Валаам сказал Валаку: Посланникам твоим, которых ты прислал ко мне, я не говорю:

NASB 1977

И сказал Валаам Валаку: «Разве я не сказал твоим посланникам, которых ты послал ко мне, сказав:

Расширенный перевод Библии

Валаам сказал Валаку: ,

Христианская стандартная Библия

Валаам ответил Валаку: «Разве я не сказал ранее посланным, которых ты послал ко мне:

Холман Христианская стандартная Библия

Валаам ответил Валаку: «Разве я не сказал ранее посланным, которых ты послал ко мне:

Американский стандарт, версия

И Валаам сказал Валаку: Я также не говорил твоим посланникам, которых ты послал ко мне, говоря:

Арамейская Библия на простом английском языке

И Валаам ответил и сказал Валаку: «Вот, я также сказал твоим посланникам, которых ты послал мне.

Брентон Перевод Септуагинты

И сказал Валаам Валаку: разве я не говорил и с посланными твоими, которых ты посылал ко мне, говоря:

Contemporary English Version

Валаам ответил: «Я сказал посланным твоим

Библия Дуэ-Реймса

Валаам ответил Валаку: Разве я не сказал твоим посланникам, которых ты послал ко мне:

Перевод Благой Вести

Валаам ответил: «Я сказал посланным, которых ты послал ко мне, что

Международная стандартная версия

Но Валаам ответил на Валак: «Я сказал твоим посланникам,

JPS Tanakh 1917

И Валаам сказал Валаку: «Я также не говорил твоим посланникам, которых ты посылал ко мне, говоря:

Буквальный стандартный перевод

И Валаам сказал Валаку: « Не говорил ли я и посланным твоим, которых ты прислал ко мне, говоря:

New American Bible

Валаам ответил Валаку: «Разве я не сказал даже посланным, которых ты послал ко мне,

NET Bible

Валаам сказал Валаку: «Разве я не сказал и твоим посланникам, которых ты послал ко мне,

New Revised Standard Version

И Валаам сказал Валаку: «Разве я не сказал твоим посланникам, которых ты послал ко мне,

New Heart English Bible

Валаам сказал Валаку: «Разве я не сказал твоим посланникам, которых ты послал ко мне , говоря,

Всемирная английская Библия

Валаам сказал Валаку: «Разве я также не сказал твоим посланникам, которых ты послал ко мне, сказав:

Буквальный перевод Юнга

говорить, говоря,

Дополнительные переводы . ..

..

Используйте Slurm для отправки заданий и управления ими в исследовательских вычислительных системах IU

На этой странице:

- Обзор

- Пакетные задания

- О сценариях заданий

- Серийные работы

- заданий OpenMP

- рабочих мест MPI

- Гибридные задания OpenMP-MPI

- Другое

ПакетОпции

- Интерактивные задания

- Отслеживайте или удаляйте свою работу

- Просмотр информации о разделе и узле

- Получить помощь

Обзор

Исследовательские суперкомпьютеры Университета Индианы используют Slurm Workload Manager для координации управления ресурсами и планирования заданий.

Пользовательские команды Slurm включают многочисленные параметры для указания ресурсов и других атрибутов, необходимых для запуска пакетных заданий или интерактивных сеансов. Параметры можно вызывать из командной строки или с помощью директив, содержащихся в сценарии задания.

Общие пользовательские команды в Slurm включают:

| Команда | Описание |

|---|---|

пакет | Отправьте пакетный скрипт в Slurm. Команда немедленно завершает работу, когда сценарий передается демону контроллера Slurm и ему назначается идентификатор задания Slurm. Дополнительные сведения см. в разделе «Пакетные задания» ниже. |

| Запустить задание на выделенных ресурсах. Обычно используется в сценариях заданий для запуска программ, srun также используется для запроса ресурсов для интерактивных заданий. |

сальник | Отслеживание информации о состоянии задания. Дополнительную информацию см. в разделе «Отслеживание или удаление вашей работы» ниже. |

сканцель | Завершить поставленное в очередь или выполняющееся задание до его завершения. Дополнительную информацию см. в разделе «Отслеживание или удаление вашей работы» ниже. Дополнительную информацию см. в разделе «Отслеживание или удаление вашей работы» ниже. |

инфо | Просмотр информации о разделе. Дополнительные сведения см. в разделе «Просмотр информации о разделе и узле» ниже. |

Пакетные задания

О сценариях заданий

Чтобы запустить задание в пакетном режиме, сначала подготовьте сценарий задания, указав приложение, которое вы хотите запустить, и ресурсы, необходимые для его запуска. Затем используйте команду sbatch , чтобы отправить сценарий задания в Slurm. Например, если ваш скрипт называется my_job.script , вы должны ввести sbatch my_job.script , чтобы отправить скрипт в Slurm; если команда выполняется успешно, она возвращает идентификатор задания в стандартный вывод; например:

[имя_пользователя@h2 ~]$ sbatch my_job.script Отправлено пакетное задание 9472

Сценарии заданий Slurm чаще всего имеют по крайней мере одну исполняемую строку, которой предшествует список параметров, указывающих ресурсы и атрибуты, необходимые для запуска вашего задания (например, время настенных часов, количество узлов и процессоров и имена файлов для задания). результат и ошибки). Когда вы пишете сценарий задания, обязательно создайте его в соответствии с потребностями вашей программы. Самое главное, убедитесь, что ваш сценарий заданий будет запрашивать надлежащее количество ресурсов, включая память и время, которые необходимы для запуска вашей программы.

результат и ошибки). Когда вы пишете сценарий задания, обязательно создайте его в соответствии с потребностями вашей программы. Самое главное, убедитесь, что ваш сценарий заданий будет запрашивать надлежащее количество ресурсов, включая память и время, которые необходимы для запуска вашей программы.

Последовательные задания

Сценарий задания для запуска последовательного пакетного задания может выглядеть следующим образом:

#!/бин/баш #SBATCH -J job_name #SBATCH -p общий #SBATCH -o имя_файла_%j.txt #SBATCH -e имя_файла_%j.err #ПОДБАТЧ --mail-type=ВСЕ #SBATCH [email protected] #ДОПОЛНИТЕЛЬНО --nodes=1 #SBATCH --ntasks-per-node=1 #ДОПОЛНИТЕЛЬНЫЙ --time=02:00:00 #ДОПОЛНИТЕЛЬНЫЙ --mem=16G # Загрузите любые модули, которые нужны вашей программе модуль загрузки имя_модуля # Запустите свою программу srun ./my_program my_program_arguments

В приведенном выше примере:

- Первая строка указывает, что сценарий следует читать с помощью интерпретатора команд Bash.

- Строки

#SBATCH— это директивы, передающие параметры командеsbatch:-

-J имя_работыуказывает имя для распределения работы. Указанное имя будет отображаться вместе с идентификационным номером задания при запросе запущенных заданий в системе. -

-p general -

-o имя_файла_%j.txtи-e имя_файла_%j.errуказывает Slurm подключить стандартный вывод задания и стандартную ошибку, соответственно, к указанным именам файлов, где%jавтоматически заменяется на идентификатор работы. -

--mail-type=<тип>предписывает Slurm отправлять электронную почту, связанную с заданием, когда происходит событие указанного типа; допустимые значения типавсе,начало,конециошибка. -

--mail-user=username@iu.указывает адрес электронной почты, на который Slurm будет отправлять почту, связанную с работой. edu

edu -

--nodes=1запрашивает, чтобы для этого задания был выделен как минимум один узел. -

--ntasks-per-node=1указывает, что на каждом узле должна быть запущена одна задача. -

--time=02:00:00запрашивает два часа для выполнения задания. -

--mem=16Gзапрашивает 16 ГБ памяти.

-

- Внизу находятся две исполняемые строки, которые будут выполняться заданием. В этом случае команда

moduleиспользуется для загрузки модуля (имя_модуля), а затемsrunиспользуется для выполнения приложения с указанными аргументами. В своем скрипте заменитеmy_programиmy_program_argumentsименем вашей программы и любыми необходимыми аргументами соответственно.

Сведения о выполнении заданий с поддержкой графического процессора см. в разделе Запуск заданий с ускорением на графическом процессоре в Carbonate или Big Red 200 в IU.

в разделе Запуск заданий с ускорением на графическом процессоре в Carbonate или Big Red 200 в IU.

Задания OpenMP

Если ваша программа может использовать преимущества нескольких процессоров (например, если она использует OpenMP), вы можете добавить директиву #SBATCH для передачи параметра --cpus-per-task в sbatch . Например, вы можете добавить эту строку, чтобы запросить выделение 12 ЦП на задачу для вашего задания:

#SBATCH --cpus-per-task=12

Если вы включаете эту строку, убедитесь, что она не запрашивает более максимальное количество процессоров, доступных на узел (у каждой системы свой максимум). Этот тип параллельной программы может использовать только несколько процессоров, находящихся на одном узле. Обычно перед вызовом такой программы следует установить OMP_NUM_THREADS переменная среды для указания количества потоков OpenMP, которые можно использовать. Если вы не хотите, чтобы на каждом ЦП работало более одного потока, это значение обычно равно количеству запрошенных ЦП.

# Запустите свою программу экспорт OMP_NUM_THREADS=12 srun ./my_program my_program_arguments

Задания MPI

Если ваша программа использует MPI (то есть код использует директивы MPI), она может использовать преимущества нескольких процессоров на более чем одном узле. Запрашивайте более одного узла только в том случае, если ваша программа специально структурирована для обмена данными между узлами. Программы MPI запускают несколько копий одной и той же программы, которые затем взаимодействуют через MPI. Одна задача Slurm используется для запуска каждого процесса MPI. Например, если ваша программа MPI может успешно использовать 48 процессов, а максимальное количество процессоров, доступных на каждом узле, равно 24, вы можете изменить приведенный выше пример сценария последовательного задания, задав --nodes=2 (для запроса двух узлов). ) и

#ДОПОЛНИТЕЛЬНО --nodes=2 #SBATCH --ntasks-per-node=24

Вы также можете указать общее количество задач в вашей команде srun :

srun -n 48 ./my_mpi_program my_program_arguments

Количество процессов, которые могут успешно выполняться на одном узле, ограничено объемом памяти, доступной на этом узле. Если каждому процессу программы требуется 20 ГБ памяти, а на узле доступно 240 ГБ памяти, вы можете запустить максимум 12 задач на каждом узле. В таком случае для запуска 48 задач ваш скрипт установит --nodes=4 (для запроса четырех узлов) и --ntasks-per-node=12 (для запроса 12 задач на узел). Кроме того, в таком случае ваш сценарий также должен установить --mem для запроса максимального объема памяти на узел, поскольку не будут запрошены все процессоры узла. Чтобы определить правильные значения для вашего сценария задания, убедитесь, что вы знаете объем памяти, доступный для каждого узла, и количество процессоров, доступных для каждого узла для используемой вами системы.

Гибридные задания OpenMP-MPI

В гибридном задании OpenMP-MPI каждый процесс MPI использует несколько потоков. В дополнение к директивам

В дополнение к директивам #SBATCH для MPI ваш сценарий должен включать директиву #SBATCH , которая запрашивает несколько процессоров для каждой задачи, и исполняемую строку, помещенную перед вашей командой srun , которая устанавливает переменную среды OMP_NUM_THREADS . Как правило, для каждого потока каждого процесса должен быть выделен один ЦП. Если на каждом узле 24 процессора, и вы хотите дать каждому процессу четыре потока, то на каждом узле может выполняться максимум шесть задач (если на каждом узле достаточно памяти для запуска шести копий программы).

Например, если вы хотите запустить 12 процессов, каждый с четырьмя потоками, включите в сценарий следующие директивы #SBATCH :

#ДОПОЛНИТЕЛЬНО --nodes=2 #SBATCH --ntasks-per-node=6 #SBATCH --cpus-per-task=4

Кроме того, включите строку, которая устанавливает OMP_NUM_THREADS=4 перед вашей командой srun :

экспорт OMP_NUM_THREADS=4 srun -n 12 ./my_mpi_program my_program_arguments

Другое

sbatch options В зависимости от ресурсов, необходимых для запуска исполняемых строк, вам может потребоваться включить другие sbatch вариантов в вашем сценарии работы. Вот еще несколько полезных:

| Опция | Действие |

|---|---|

--begin=ГГГГ-ММ-ДДЧЧ:ММ:СС | Отложить выделение задания до указанной даты и времени, после чего задание может быть выполнено. Например, чтобы отложить распределение вашей работы до 22:30 31 октября 2022 года, используйте:--begin=2022-10-31T22:30:00 |

--без запроса | Укажите, что задание нельзя запустить повторно. Установка этого параметра предотвращает повторную постановку задания в очередь после того, как оно было прервано, например, из-за запланированного простоя или вытеснения заданием с более высоким приоритетом. |

Полную документацию по команде sbatch и ее параметрам см. на странице руководства sbatch (в Интернете см. sbatch; на исследовательских суперкомпьютерах IU введите man sbatch ).

Интерактивные задания

Чтобы запросить ресурсы для интерактивного задания, используйте команду srun с параметром --pty .

Например:

- Чтобы запустить сеанс Bash, который использует один узел в общем разделе, в командной строке введите:

srun -p вообще --pty bash

- Для выполнения отладки отправьте интерактивное задание в раздел отладки или общий раздел; Например:

- Чтобы запустить интерактивное задание с включенной переадресацией X11, добавьте параметр

--x11флаг; Например:srun -p общие --x11 --time=01:00:00 --pty bash

Когда для вашего задания будут выделены запрошенные ресурсы, вы попадете в командную строку на вычислительном узле.

Как только вы разместитесь на вычислительном узле, вы сможете запускать графические X-приложения и свои собственные двоичные файлы из командной строки. Возможно, вам потребуется загрузить модуль для нужного X-клиента перед запуском приложения.

Как только вы разместитесь на вычислительном узле, вы сможете запускать графические X-приложения и свои собственные двоичные файлы из командной строки. Возможно, вам потребуется загрузить модуль для нужного X-клиента перед запуском приложения.

По завершении интерактивного сеанса введите в командной строке выход из для освобождения выделенных ресурсов.

Полную документацию по команде srun см. на странице руководства srun (в Интернете см. srun; на исследовательских суперкомпьютерах IU введите man srun ).

Полную документацию по команде salloc см. на странице руководства salloc (в Интернете см. salloc; на исследовательских суперкомпьютерах IU введите man salloc ).

Отслеживание или удаление задания

Чтобы отслеживать состояние заданий в разделе Slurm, используйте команду squeue . Некоторые полезные опции скребка включают:

| Опция | Описание |

|---|---|

-а | Показать информацию обо всех заданиях. |

-j | Показать информацию для указанного идентификатора задания. |

-j | Показать все информационные поля (с вертикальной чертой, разделяющей каждое поле) для указанного идентификатора задания. |

-л | Отображение информации в длинном формате. |

-n <имя_работы> | Показать информацию для указанного имени задания. |

-p <имя_раздела> | Показать задания в указанном разделе. |

-t <список_состояний> | Показать задания, находящиеся в указанном состоянии. Valid jobs states include PENDING , RUNNING , SUSPENDED , COMPLETED , CANCELLED , FAILED , TIMEOUT , NODE_FAIL , PREEMPTED , BOOT_FAIL , DEADLINE , OUT_OF_MEMORY , ЗАВЕРШЕНИЕ , НАСТРОЙКА , ИЗМЕНЕНИЕ РАЗМЕРА , ОТМЕНЕНО , и SPECIAL_EXIT . |

-u <имя пользователя> | Показать задания, принадлежащие указанному пользователю. |

Например:

Полную документацию по команде squeue см. на странице руководства squeue (в Интернете см. squeue; на исследовательских суперкомпьютерах IU введите man squeue ).

Чтобы удалить ожидающее или выполняющееся задание, используйте команду scancel с идентификатором задания; например, чтобы удалить задание с идентификатором задания 8990 , в командной строке введите:

сканцель 8990

Альтернативно:

- Чтобы отменить задание с именем

my_job, введите:scancel -n my_job

- Чтобы отменить задание, принадлежащее пользователю

, имя пользователя, введите:scancel -u имя пользователя

Полную документацию по команде scancel см. на странице руководства

на странице руководства scancel (в Интернете см. scancel; на исследовательских суперкомпьютерах IU введите man scancel ).

Чтобы просмотреть информацию об узлах и разделах, которыми управляет Slurm, используйте команду sinfo .

По умолчанию sinfo (без опций) отображает:

- Все имена разделов

- Доступность каждого раздела

- Максимальное время работы в стене, разрешенное для заданий в каждом разделе

- Количество узлов в каждом разделе

- Состояние узлов в каждом разделе

- Имена узлов в каждом разделе

Чтобы отобразить информацию об узле, используйте sinfo -N , в котором перечислены:

- Все имена узлов

- Раздел, которому принадлежит каждый узел

- Состояние каждого узла

Чтобы отобразить дополнительную информацию об узле, используйте sinfo -lN , которая добавляет следующие поля к предыдущему выводу:

- Количество ядер на узел

- Количество сокетов на узел, ядер на сокет и потоков на ядро

- Размер памяти на узел в мегабайтах

В качестве альтернативы, чтобы указать, какие информационные поля должны отображаться, и управлять форматированием вывода, используйте sinfo с параметром -o ; например (замените # на число, чтобы установить ширину отображения поля, а field1 на и field2 на на желаемые характеристики поля):

sinfo -o "%<#><поле1> %<#><поле2>"

Доступные полевые спецификации включают:

| Спецификация | Отображаемое поле |

|---|---|

%<#>P | Имя раздела (установить ширину поля # символов) |

%<#>N | Список имен узлов (установить ширину поля # символов) |

%<#>с | Количество ядер на узел (задайте ширину поля # символов) |

%<#>м | Размер памяти на узел в мегабайтах (задайте ширину поля # символов) |

%<#>л | Максимально допустимое время стены (установите ширину поля # символов) |

%<#>с | Максимальное количество узлов, разрешенное для задания (задайте ширину поля # символов) |

%<#>G | Общий ресурс, связанный с узлом (установите ширину поля на # символов) |

Например, в Carbonate следующая команда sinfo выводит список для конкретного узла, который включает имена разделов, имена узлов, количество ядер на узел, объем памяти на узел, максимально допустимое время стены для каждого узла. задания, а также количество и тип универсальных ресурсов (GPU), доступных на каждом узле:

задания, а также количество и тип универсальных ресурсов (GPU), доступных на каждом узле:

sinfo -No "%10P %8N %4c %7m %12l %10G"

Результат выглядит примерно так:

СПИСОК УЗЛОВ РАЗДЕЛОВ ЦП ПАМЯТЬ ВРЕМЯ ОГРАНИЧЕНИЕ GRES дл dl1 24 192888 2-00:00:00 GPU:v100:2 dl dl2 24 192888 2-00:00:00 GPU:v100:2 дл dl3 24 192888 2-00:00:00 GPU:p100:2 дл dl4 24 192888 2-00:00:00 GPU:p100:2 дл dl5 24 192888 2-00:00:00 GPU:p100:2 dl dl6 24 192888 2-00:00:00 GPU:p100:2 дл дл7 24 192888 2-00:00:00 GPU:p100:2 дл dl8 24 192888 2-00:00:00 GPU:p100:2 дл dl9 24 192888 2-00:00:00 GPU:p100:2 dl-debug dl10 24 192888 8:00:00 GPU:p100:2 дл dl11 24 192888 2-00:00:00 GPU:v100:2 дл dl12 24 192888 2-00:00:00 GPU:v100:2

Полную документацию по команде sinfo см. на странице руководства sinfo (в Интернете см. sinfo; на исследовательских суперкомпьютерах IU введите ман синфо ).

Получить помощь

SchedMD, компания, которая распространяет и поддерживает каноническую версию Slurm, предоставляет онлайн-документацию для пользователей, включая сводку команд и параметров Slurm, справочные страницы для всех команд Slurm и Rosetta Stone of Workload Managers для помощи определение Slurm-эквивалентов команд и опций, используемых в других системах управления ресурсами и планирования (например, TORQUE/PBS).

edu

edu  /my_mpi_program my_program_arguments

/my_mpi_program my_program_arguments

/my_mpi_program my_program_arguments

/my_mpi_program my_program_arguments

Как только вы разместитесь на вычислительном узле, вы сможете запускать графические X-приложения и свои собственные двоичные файлы из командной строки. Возможно, вам потребуется загрузить модуль для нужного X-клиента перед запуском приложения.

Как только вы разместитесь на вычислительном узле, вы сможете запускать графические X-приложения и свои собственные двоичные файлы из командной строки. Возможно, вам потребуется загрузить модуль для нужного X-клиента перед запуском приложения.