44. Дисперсия и ее свойства.

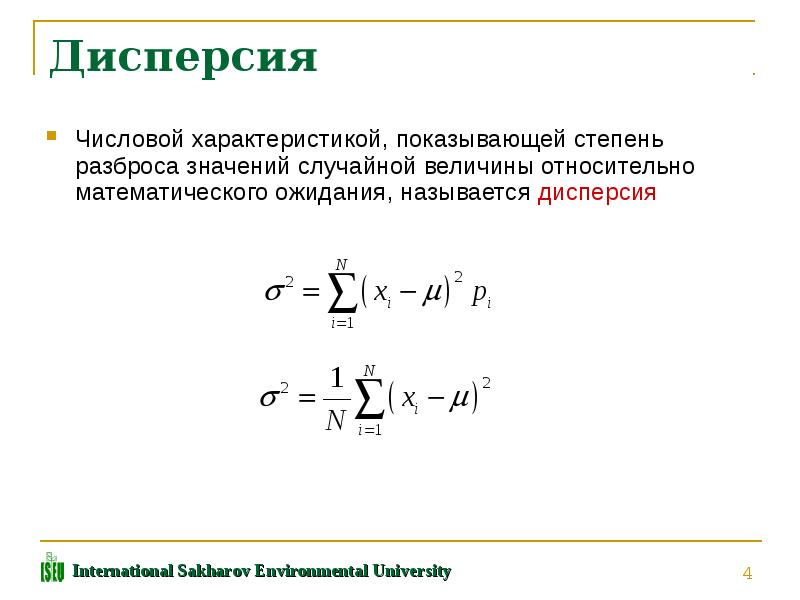

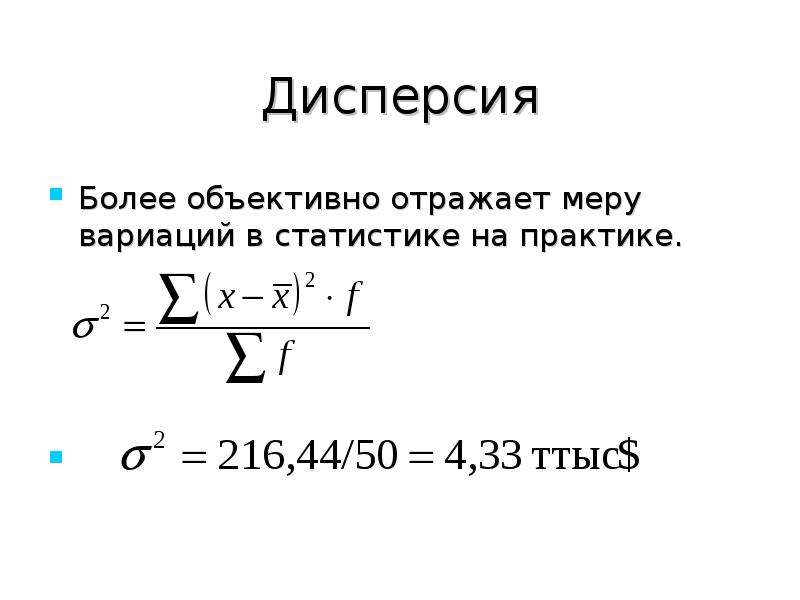

Дисперсия — средний квадрат отклонений индивидуальных значений признака от их средней величины.

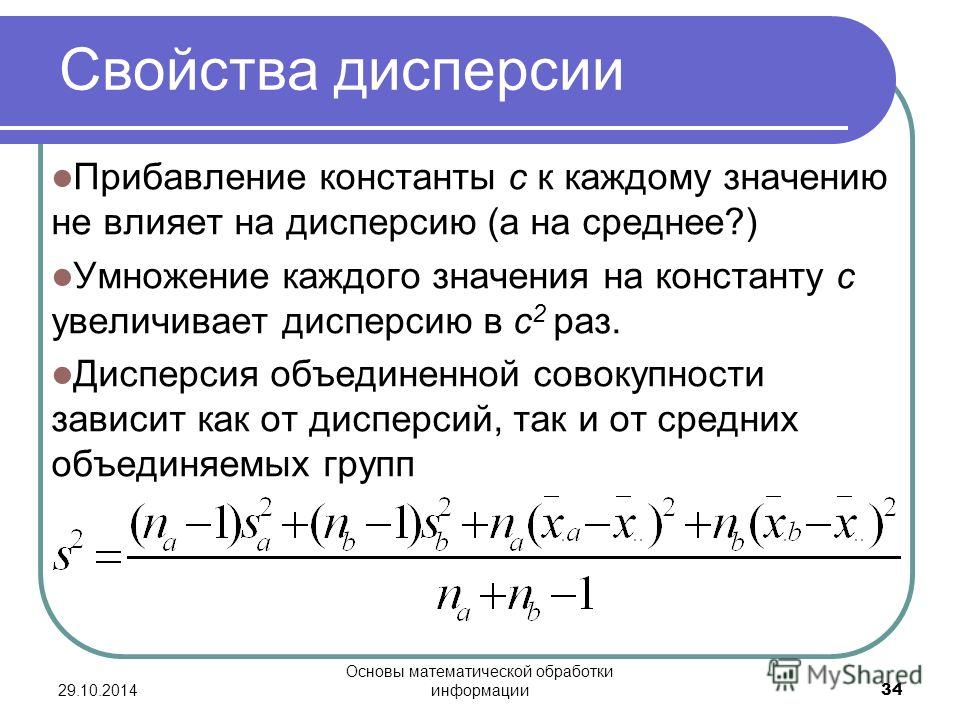

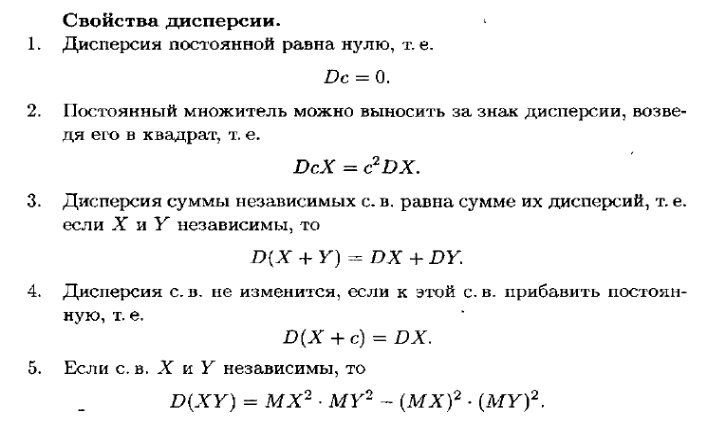

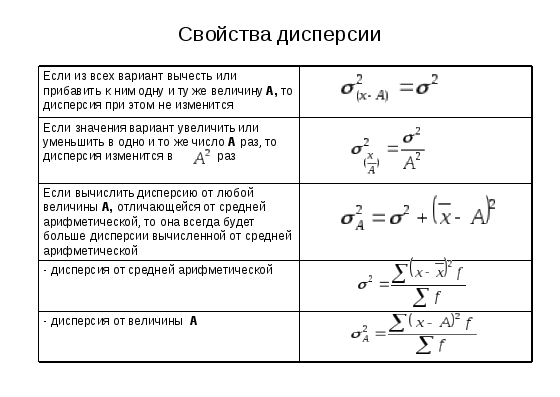

Свойства дисперсии:

1. Дисперсия постоянной величины равна нулю.

2. Уменьшение всех значений признака на одну и ту же величину А не меняет величины дисперсии. Значит средний квадрат отклонений можно вычислить не по заданным значениям признака, а по отклонениям их от какого-то постоянного числа.

3. Уменьшение всех значений признака в k раз уменьшает дисперсию в k2 раз, а среднее квадратическое отклонение — к раз. Значит, все значения признака можно разделить на какое-то постоянное число (скажем, на величину интервала ряда), исчислить среднее квадратическое отклонение, а затем умножить его на постоянное число.

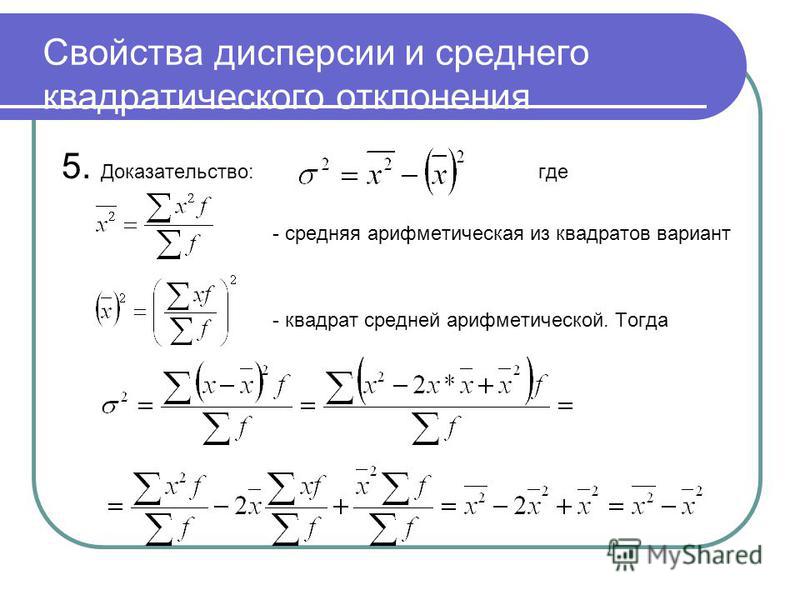

4. Если исчислить

средний квадрат отклонений от любой

величины

А, то в той

или иной степени отличающейся от средней

арифметической (X~),

то он всегда будет больше среднего

квадрата отклонений, исчисленного от

средней арифметической.

45. Внутригрупповая и межгрупповая дисперсия.

Выделяют дисперсию общую, межгрупповую и внутригрупповую. Общая дисперсия s2 измеряет вариацию признака во всей совокупности под влиянием всех факторов, обусловивших эту вариацию.

Межгрупповая дисперсия (s2x) характеризует систематическую вариацию, т.е. различия в величине изучаемого признака, возникающие под влиянием признака-фактора, положенного в основание группировки.

Внутригрупповая дисперсия (s2i) отражает случайную вариацию, т.е. часть вариации, происходящую под влиянием неучтенных факторов и не зависящую от признака-фактора, положенного в основание группировки.

46. Правило сложения дисперсий.

Существует

закон, связывающий три вида дисперсии. Общая дисперсия равна сумме средней из

внутригрупповых и межгрупповых дисперсий:

Общая дисперсия равна сумме средней из

внутригрупповых и межгрупповых дисперсий:

Данное соотношение называют правилом сложения дисперсий. Согласно этому правилу, общая дисперсия, возникающая под действием всех факторов, равна сумме дисперсии, возникающей за счет группировочного признака.

Зная любые два вида дисперсий, можно определить или проверить правильность расчета третьего вида.

Правило сложения дисперсий широко применяется при исчислении показателей тесноты связей, в дисперсионном анализе, при оценке точности типической выборки и в ряде других случаев.

47. Взаимосвязи общественных явлений, их виды, формы.

Многообразие взаимосвязей в которых находятся социально-экономические явления, рождают необходимость в их классификации.

По видам

различают функциональную и корреляционную

зависимость.

Функциональной называют такую зависимость, при которой одному значению факторного признака X соответствует одно строго определенное значение результативного признака Y.

В отличие от функциональной зависимости, корреляционная выражает такую связь между социально-экономическими явлениями, при которой одному значению факторного признака X могут соответствовать несколько значений результативного признака Y.

По направлению различают прямую и обратную зависимость.

Прямой называют такую зависимость, при которой значение факторного признака X и результативного признака Y изменяются в одном направлении. Т.о. при увеличении значения X, значения Y в среднем увеличиваются, а при уменьшении X — Y уменьшается.

Обратная зависимость между факторным и

результативным признаками, если они

изменяются в противоположных направлениях. n\mathsf DX_i+2\sum_{1\leqslant i<j\leqslant n}\mathop{\mathrm{cov}}(X_i,X_j),D(X1+…+Xn)=i=1∑nDXi+21⩽i<j⩽n∑cov(Xi,Xj),где

n\mathsf DX_i+2\sum_{1\leqslant i<j\leqslant n}\mathop{\mathrm{cov}}(X_i,X_j),D(X1+…+Xn)=i=1∑nDXi+21⩽i<j⩽n∑cov(Xi,Xj),где

cov(Xi,Xj)=E{(Xi−EXi)(Xj−EXj)}\mathop{\mathrm{cov}}(X_i,X_j)=\mathsf E\{(X_i-\mathsf EX_i)(X_j-\mathsf EX_j)\}cov(Xi,Xj)=E{(Xi−EXi)(Xj−EXj)}обозначает ковариацию случайных величин XiX_iXi иXj X_jXj. Если случайные величины X1,…,XnX_1,\ldots,X_nX1,…,Xn попарно независимы, то cov(Xi,Xj)=0\mathop{\mathrm{cov}}(X_i,X_j)=0cov(Xi,Xj)=0. Поэтому для попарно независимых случайных величин

D(X1+…+Xn)=DX1+…+DXn.(2)\tag{2} \mathsf D(X_1 +\ldots + X_n) = \mathsf DX_1 +\ldots + \mathsf DX_n.D(X1+…+Xn)=DX1+…+DXn.(2)Обратное утверждение неверно: из (2) не следует независимость. Однако, как правило, применение формулы (2) базируется на независимости случайных величин. Строго говоря, для справедливости (2) достаточно лишь, чтобы cov(Xi,Xj)=0\mathop{\mathrm{cov}}(X_i,X_j)=0cov(Xi,Xj)=0, т. е. чтобы случайные величины X1,…,XnX_1,\ldots,X_nX1,…,Xn были попарно некоррелированы.

Применения понятия дисперсии развиваются по следующим двум направлениям. Во-первых, применения в области предельных теорем теории вероятностей. Если последовательность случайных величин X1,X2…,Xn,…X_1,X_2\ldots,X_n,\ldotsX1,X2…,Xn,… обладает тем свойством, что DXn→0\mathsf DX_n\to 0DXn→0 при n→∞n\to\inftyn→∞, то для любого ε>0\varepsilon>0ε>0 при n→∞n\to\inftyn→∞

Р{∣Xn−EXn∣>ε}→0\mathsf Р \{|X_n-\mathsf EX_n|>\varepsilon\}\to 0Р{∣Xn−EXn∣>ε}→0(см. Неравенство Чебышёва), т. е. практически при больших nnn случайная величина XXX совпадает с неслучайной величиной EXn\mathsf EX_nEXn. Развитие этих соображений приводит к доказательству закона больших чисел, к доказательству состоятельности оценок в математической статистике, а также к иным применениям, в которых устанавливается сходимость по вероятности случайных величин. Другое применение в области предельных теорем связано с понятием нормировки. Нормировка случайной величины XXX производится путём вычитания математического ожидания и деления на среднее квадратичное отклонение DX\sqrt{\mathsf DX}DX, иными словами, рассматривается величина Y=(X−EX)/DXY=(X-\mathsf EX)/\sqrt{\mathsf DX}Y=(X−EX)/DX. 2DY=σ2. Поэтому параметры теоретического закона имеют следующий смысл: a=EYa=\mathsf EYa=EY и σ=DY\sigma=\sqrt{\mathsf DY}σ=DY. Отсюда вытекает способ определения этих параметров по выборке.

2DY=σ2. Поэтому параметры теоретического закона имеют следующий смысл: a=EYa=\mathsf EYa=EY и σ=DY\sigma=\sqrt{\mathsf DY}σ=DY. Отсюда вытекает способ определения этих параметров по выборке.

Дата публикации: 24 декабря 2022 г. в 21:21 (GMT+3)

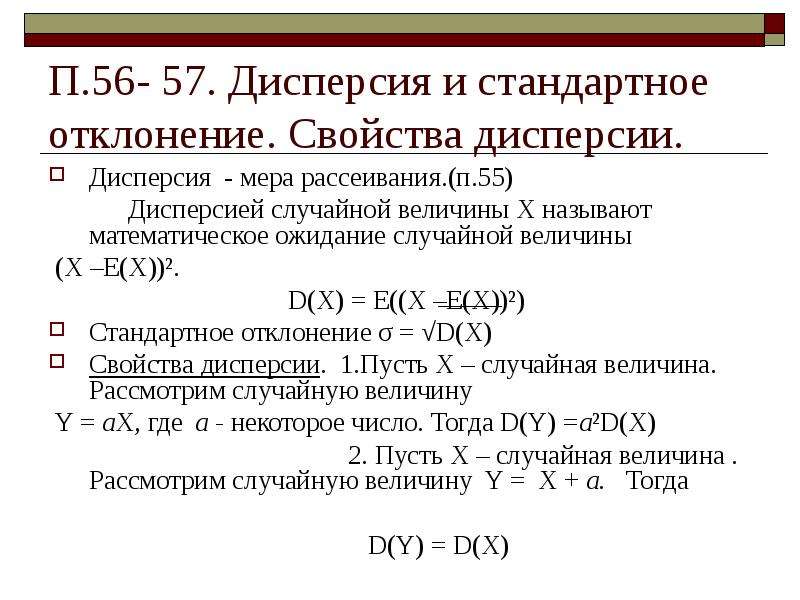

Свойства дисперсии

Статистическая дисперсия описывает дисперсию чисел в наборе данных по сравнению со средним или средним значением. Он рассчитывается путем умножения стандартного отклонения на квадрат. Дисперсия может определять степень растяжения или сжатия распределения.

В этой статье мы рассмотрим свойства ожидания и дисперсии, свойства среднего и дисперсии и решим несколько примеров задач. Дисперсия имеет тот недостаток, что, в отличие от стандартного отклонения, ее единицы отличаются от случайной величины, поэтому после завершения расчета стандартное отклонение чаще сообщается как мера дисперсии.

Определение дисперсии

Прогнозируемая вариация между значениями в наборе данных — это дисперсия. Он вычисляет разницу между каждой цифрой и средним значением. Трейдеры и рыночные аналитики часто используют дисперсию для прогнозирования волатильности рынка и постоянства определенного дохода от инвестиций с течением времени. Дисперсия обычно обозначается знаком σ², тогда как ее квадратный корень, т. е. стандартное отклонение, обозначается символом σ.

Есть два типа дисперсии

Отклонение населения

Под населением понимается все членство в группе. Дисперсия населения используется для определения того, как каждая точка данных колеблется или распределяется в определенной совокупности. Он вычисляет квадрат расстояния каждой точки данных от среднего значения генеральной совокупности.

Выборочная дисперсия

Трудно рассмотреть каждую точку данных, если совокупность слишком велика. В этой ситуации берется выборка точек данных из совокупности для создания выборки, которую можно использовать для характеристики всей группы. В результате выборочная дисперсия равна среднему квадрату отклонения от среднего. Выборочное среднее всегда используется для определения дисперсии. 9

В результате выборочная дисперсия равна среднему квадрату отклонения от среднего. Выборочное среднее всегда используется для определения дисперсии. 9

S² = выборка дисперсии

н= количество наблюдений

Как найти дисперсию?

Дисперсия может быть определена с помощью следующих шагов:

Вычислить среднее значение наблюдений. Разделите сумму всех наблюдений на количество наблюдений, чтобы получить этот результат.

Затем из каждого наблюдения следует вычесть среднее значение; после возведения в квадрат каждого из этих значений сложите все значения, полученные на предыдущем шаге, после вычитания. Затем разделите значение на n в случае дисперсии населения и n-1 в случае дисперсии выборки.

Свойства дисперсии

Ниже приведены некоторые свойства дисперсии, которые можно использовать для решения как простых, так и сложных задач на суммы.

- Нулевая дисперсия указывает на то, что все точки данных сбора данных одинаково важны.

- Когда дисперсия высока, данные сильно расходятся со средним значением. С другой стороны, небольшая дисперсия указывает на то, что значения точек данных ближе друг к другу и сгруппированы вокруг среднего значения.

- Var(X + C) = Var(X), где X — случайная величина, а C — константа.

- Var(aX + b) = a2, здесь a и b — константы.

- Var(CX) = C2

Var(X), C — константа. - Var(x1 + x2 +……+ xn) = Var(x1) + Var(x2) +……..+Var(xn), где x1, x2,……, xn — независимые случайные величины.

Свойства ожидания и дисперсии

Если X — дискретная случайная величина, то ожидаемое значение X (или среднее значение) представляет собой средневзвешенное значение всех возможных значений, которые может принять X, каждое из которых взвешивается в соответствии с вероятностью того, что оно произойдет . Обычно E(X) или m представляет ожидаемое значение X.

E(X) = S x P(X = x)

Другими словами, ожидаемое значение равно: [(каждый возможный результат) * (вероятность происходящего результата)].

Точнее, ожидание — это то, что вы ожидаете от результатов эксперимента в среднем.

Это были некоторые свойства ожидания и дисперсии.

Свойства среднего и дисперсии

- Пусть X и Y — случайные величины, тогда E(X + Y) = E(X) + E(Y).

- Если X1, X2, … , Xn — случайные величины, то E(x1 + x2 +……+ xn) = E(X1) + E(X2) + … + E(Xn) = Σi E(Xi).

- Для случайных величин X и Y E(XY) = E(X) E(Y). И X, и Y здесь являются независимыми переменными.

- Если X — случайная величина, а a — константа, то E(aX)= a E(X) и E(X + a) = E(X) + a.

- Независимо от случайной величины, X > 0, E(X) > 0.

- E(Y) ≥ E(X), когда X и Y таковы, что Y ≥ X.

Заключение

После помня все эти теории и свойства, потренируйтесь на некоторых решенных примерах и вопросах. Ниже приведены некоторые ключевые моменты, которые вы должны помнить о свойствах ожидания и дисперсии и свойствах среднего и дисперсии.

Дисперсия измеряет изменчивость данных, отражающую распределение точек данных вокруг среднего значения. Выборочная дисперсия и дисперсия генеральной совокупности являются двумя формами дисперсии. Существует два типа данных: сгруппированные данные и разгруппированные данные. В результате возможны сгруппированная выборочная дисперсия, негруппированная выборочная дисперсия, сгруппированная дисперсия совокупности и негруппированная дисперсия совокупности.

Квадрат стандартного отклонения представляет собой дисперсию. Зависимая случайная величина и независимая случайная величина описываются ковариацией.

Дисперсия в статистике: определение, формулы, свойства и примеры | MIT

Дисперсия — это широко используемое понятие в вероятностной и описательной статистике для измерения изменчивости заданных данных. Дисперсия — это метод определения различных терминов в финансах. Это то же самое, что и стандартное отклонение, но измеряется в квадратах.

Дисперсия — это метод определения различных терминов в финансах. Это то же самое, что и стандартное отклонение, но измеряется в квадратах.

Давайте рассмотрим термин дисперсия.

Какая разница в статистике?Дисперсия может быть определена как статистическая мера отклонения между числами в наборе данных. Дисперсия набора измеряет, насколько далеко каждое число от ожидаемого значения (среднего), а также от других чисел.

Результатом дисперсии является квадрат стандартного отклонения. Термин стандартное отклонение — это еще один статистический метод, который измеряет среднее значение квадратов отклонений. Символически термин дисперсия может быть записан как s 2 , σ 2 или Var(x).

Набор данных в дисперсии может быть совокупностью или выборкой. Выборочные данные представляют собой набор выборочных значений, взятых из всей совокупности для измерения оценочного значения. Принимая во внимание, что набор данных о населении представляет собой набор целого ряда значений, таких как население, принимающее все данные.

Существует два основных вида дисперсии:

- Выборочная дисперсия

- Дисперсия населения

Формулы для дисперсии выборки и генеральной совокупности:

31| σ 2 = [∑(x i – μ) 2 /N] | s 2 = [∑(x i – x̄) 2 /(N – 1)] | |

| > 9010 3 σ 2 — обозначение дисперсии генеральной совокупности. > мк — среднее значение популяционных данных. > X i — набор заданных значений данных. > N — общее количество наблюдений. | > s 2 — обозначение выборочной дисперсии. > x̄ — среднее значение выборочных данных. > X i — набор заданных значений данных.  > N — общее количество наблюдений. |

Есть некоторые преимущества и недостатки дисперсии. Кратко обсудим их.

| Преимущества |

| Он используется для измерения взаимосвязи между числами и средними значениями, чтобы упростить работу статистиков, поскольку другой способ довольно сложен, например, распределение чисел по квартилям. |

| Отклонения от ожидаемых значений обрабатываются одинаково в дисперсии независимо от их направления. |

| В данных нет никакой изменчивости, так как сумма квадратов отклонений не может равняться нулю. |

Некоторые свойства дисперсии: 7 Вар(Х + С) = Var(X)

2) Произведение постоянного члена на дисперсию должно брать квадрат постоянного члена. например

например

Var(C * X) = C 2 * Var(X)

3) Аналогично, произведение и сумма постоянного члена с дисперсией должны брать квадрат постоянного члена. Например,

Var(aX + b) = a 2 * Var(X)

4) Дисперсия должна применяться к каждому члену отдельно, если случайные величины X 1 , X 2 , …, X n задаются, например,

Var(X 1 , X 2 , …, X n ) = Var(X 1 ) + Var(X 2 ) +……..+Var(X n )

Примеры отклоненийНиже приведены несколько примеров дисперсии.

Пример 1: Для выборочной дисперсии

Измерьте изменчивость данных данной выборки.

Данные выборки = 12, 15, 16, 20, 25, 24, 23, 30, 35, 36, 42

Решение –

Шаг 1: принимая частное суммы наблюдений и общего количества значений данных.

Сумма данных образца = 12 + 15 + 16 + 20 + 25 + 24 + 23 + 30 + 35 + 36 + 42

Сумма = 278

Общее количество наблюдения = n = 11

Среднее значение = 278 /11

Среднее значение выборки = 25,27

Шаг 2: Теперь найдите отклонение (отличие каждого значения данных от среднего).

Данные| 12 – 25,27 = -13,27 | |

| 15 | 15 – 25,27 = -10,27 |

| 16 | 16 – 25,27 = -9,27 |

| 20 | 20 – 25,27 = -5,27 |

| 25 | 25 – 25,27 = -0,27 |

| 24 | 24 – 25,27 = -1,27 |

| 23 | 23 – 25,27 = -2,27 |

| 30 | 30 – 25,27 = 4,73 |

| 35 | 35 – 25,27 = 9,73 |

| 36 | 36 – 25,27 = 10,73 |

| 42 | 42 – 25,27 = 16,73 |

Шаг 3: Теперь возьмем квадрат отклонений, чтобы все результаты были положительными.

| ( z i – z̄) 2 |

| (-13,27) 2 = 176,09 |

| (-10,27) 2 = 105,47 |

| (-9,27) 2 = 85,93 |

| (-5,27) |

| (-0,27) 2 = 0,0 7 |

| (-1,27) 2 = 1,61 |

| (- 2,27) 2 = 5,15 |

| (4,73) 2 = 22,37 |

| (9,73) 2 = 94,67 |

| (10,73) 2 = 115,13 |

| (16,73) 2 = 279,89 |

Шаг 4: Теперь возьмите сумму квадратов отклонений.

∑(z i – z̄) 2 = 176,09 + 105,47 + 85,93 + 27,77 + 0,07 + 1,61 + 5,15 + 22,37 + 94,67 + 115,13 + 279,89

∑(z i – z̄) 2 = 914,15

Шаг 5: Используйте формулу выборочной дисперсии для оценки выборочной дисперсии.

∑(z i – z̄) 2 / (N – 1) = 914,15 / 11 – 1

∑(z i – z̄) 2 / (N – 1) = 914,15 / 10

∑(z i – z̄) 2 / (N – 1) = 91,415

Следовательно, выборочная дисперсия данных выборки равна 91.415.

Калькулятор дисперсии от calculates.tech можно использовать, чтобы избежать трудоемких вычислений дисперсии.

Пример 2: Для данных о населении

Оцените среднее квадратов отклонений от заданных данных о населении.

Данные о населении = 9, 11, 13, 15, 14, 16, 18, 23, 26, 28, 30

Решение –

Шаг 1: Прежде всего, найдите среднее значение генеральной совокупности, взяв частное суммы наблюдений и общего количества значений данных.

Сумма данных о населении = 9 + 11 + 13 + 15 + 14 + 16 + 18 + 23 + 26 + 28 + 30

Сумма = 203

Общее число наблюдений = N = 11 = 203/11

Среднее значение населения = µ = 18,455

Шаг 2: Теперь найдите отклонение (отличие каждого значения данных от среднего).

| Значения данных | y i – µ |

| 9 | 90 206 9 – 18,455 = -9,45|

| 11 | 11 – 18,455 = -7,45 |

| 13 | 13 – 18,455 = -5,45 |

| 15 | 15 – 18,455 = -3,45 |

| 14 | 902 06 14 – 18,455 = -4,45|

| 16 | 16 – 18,455 = -2,45 |

| 18 | 18 – 18,455 = =0,45 |

| 23 | 23 – 18,455 = 4,55 |

| 26 9 0135 | 26 – 18,455 = 7,55 |

| 28 | 28 – 18,455 = 9,55 |

| 30 | 30 – 18,455 = 11,55 |

Шаг 3: Теперь возьмем квадрат отклонений, чтобы все результаты были положительными.

| ( y i – мк) 2 |

| (-9,45) 2 = 89,30 |

| (-7,45) 2 = 55,50 |

| (-5,45) 2 = 29,70 |

| (-3,45) 2 = 11,90 |

| (-4,45) 2 = 19,80 |

| (-2,45) 2 = 6,00 901 35 |

| (=0,45) 2 = 0,20 |

| (4,55) 2 = 20,70 |

| (7,55) 2 = 57,00 |

| (9,55) 2 = 91,20 |

| (11,55) 2 = 133. 40 |

Шаг 4: Теперь возьмите сумму квадратов отклонений.