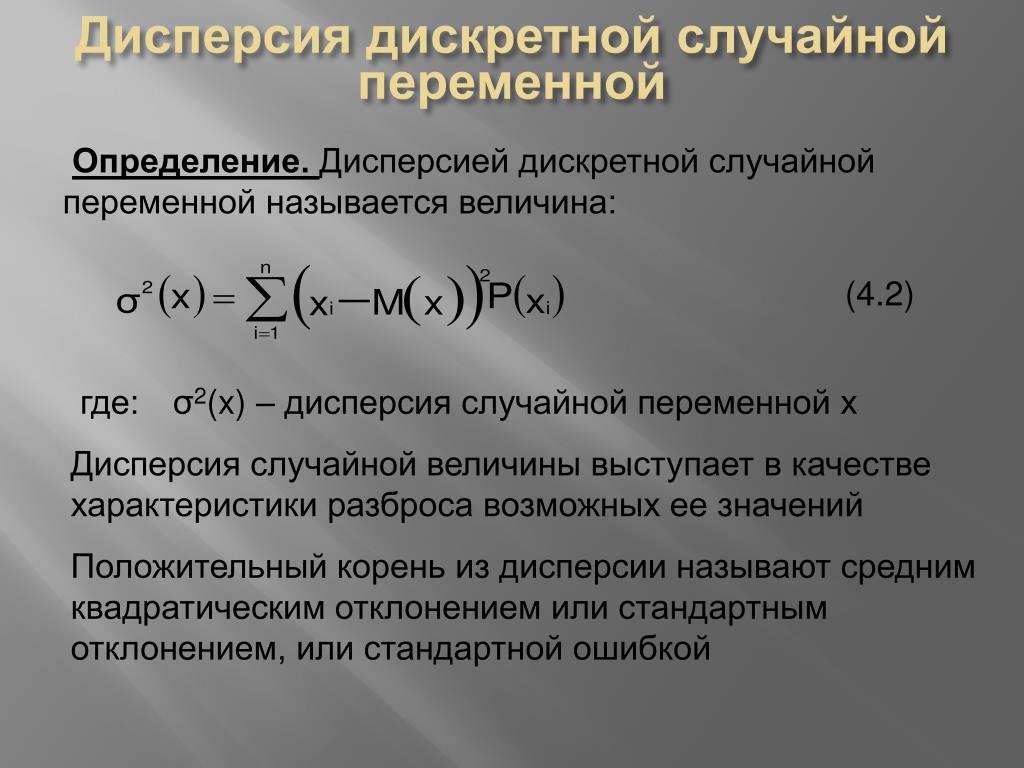

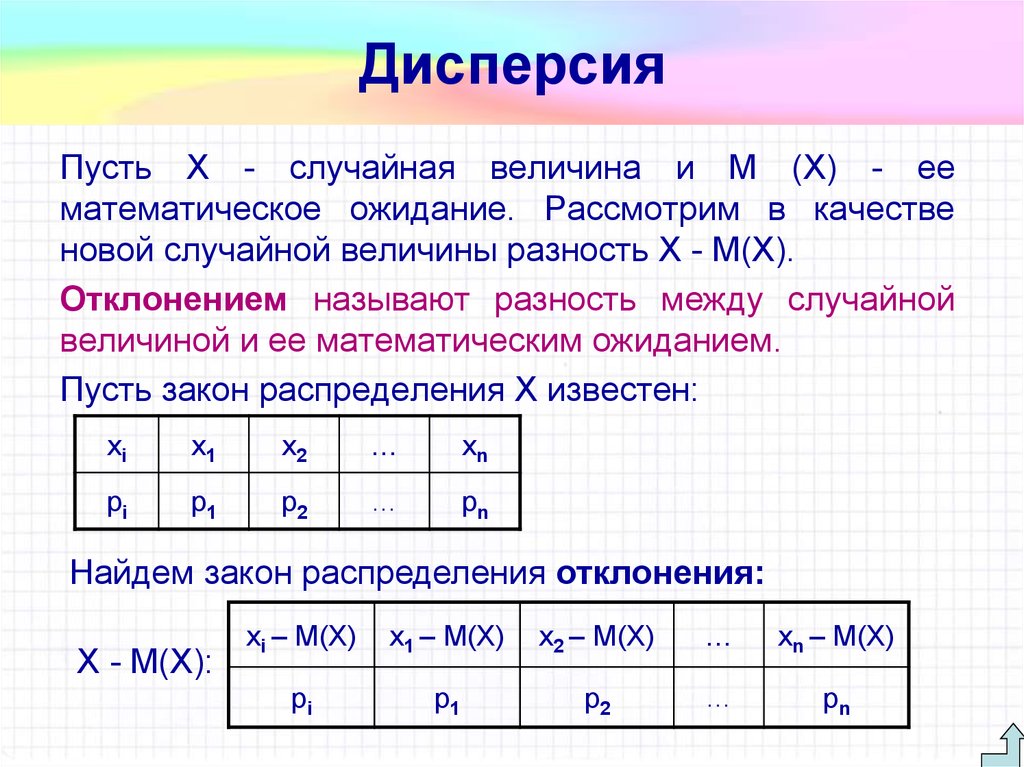

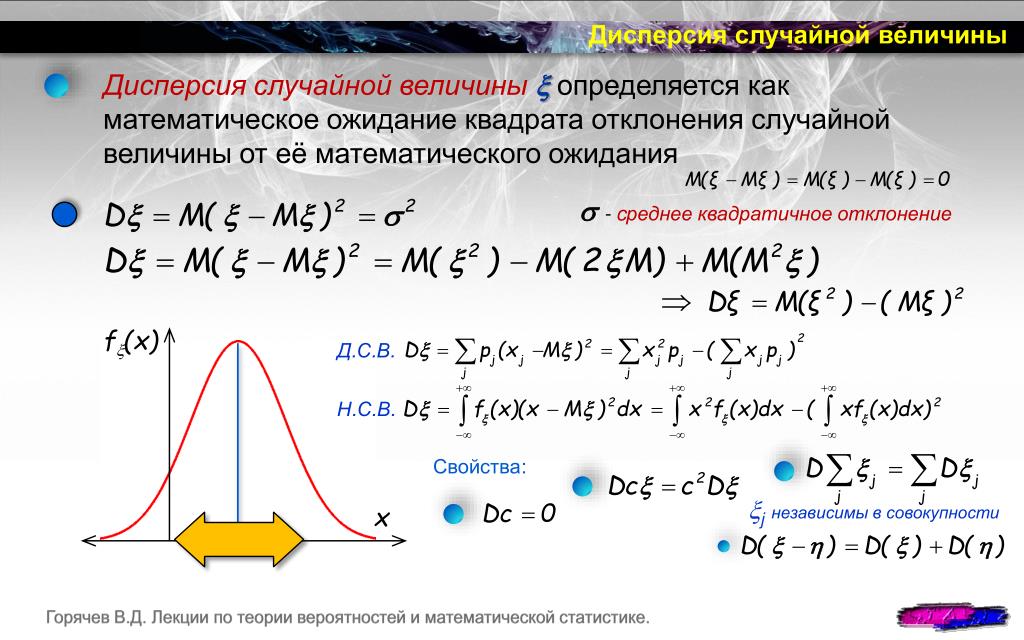

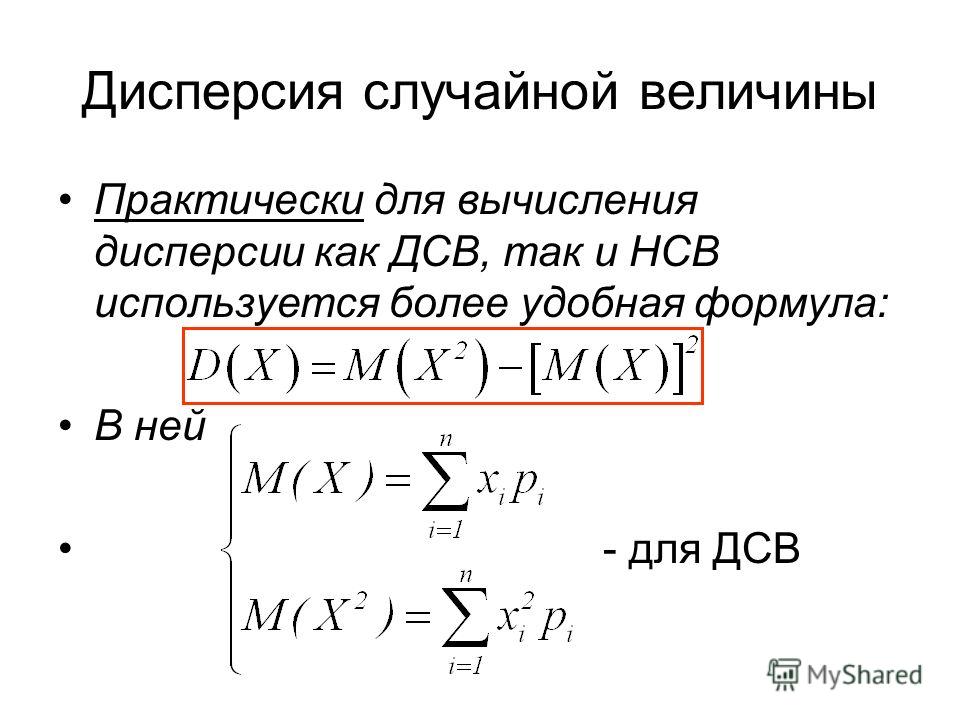

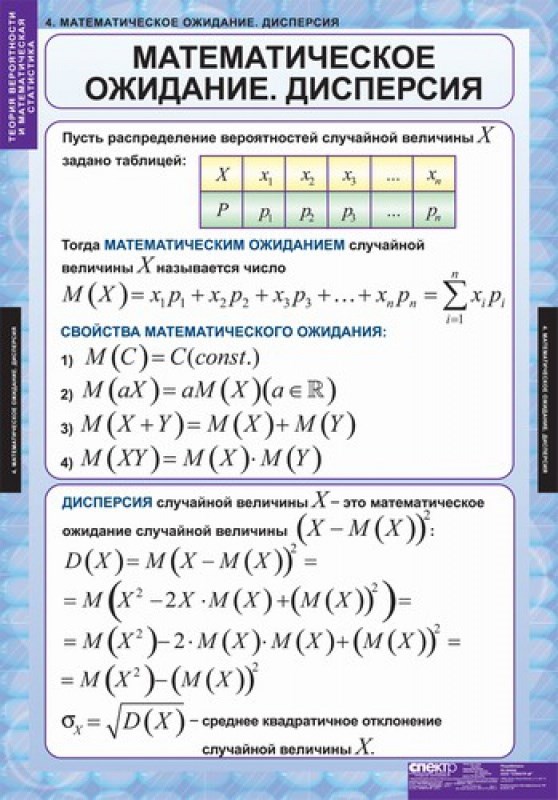

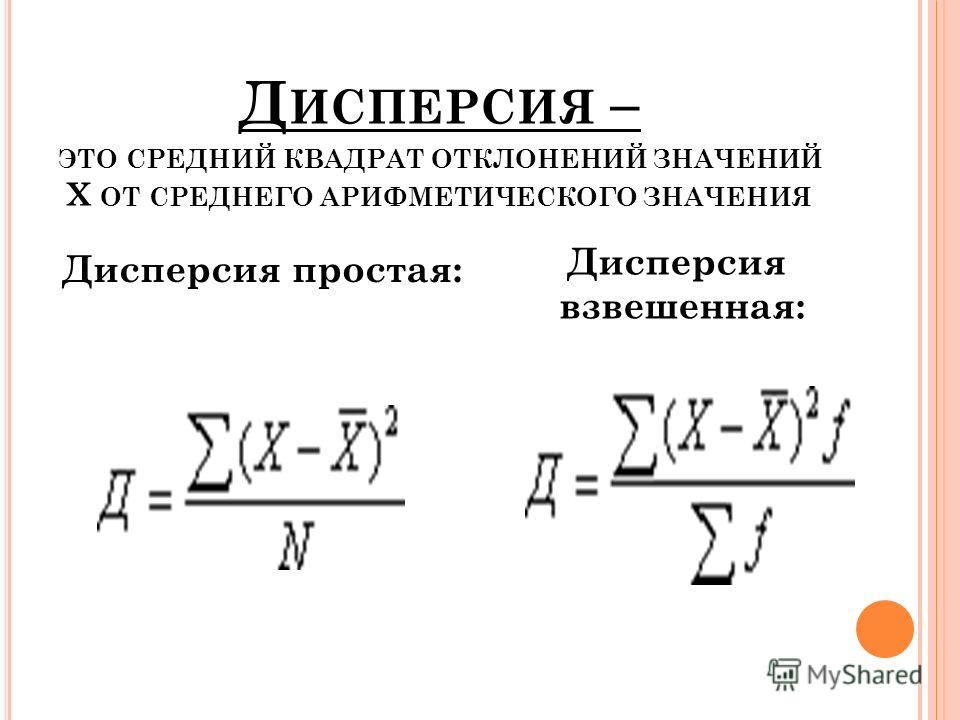

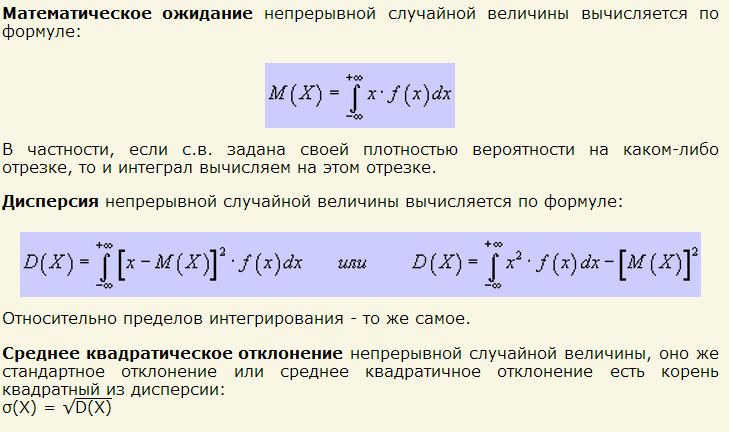

Здесь, в формуле, M – это матожидание случайной величины Х, существующей в некотором вероятностном пространстве. Значение дисперсии определяется как то, что она представляет собой математическое ожидание отклонения, возведённого в квадрат. Под отклонением подразумевается отклонение случайной величины от её математического ожидания.

Определение 2

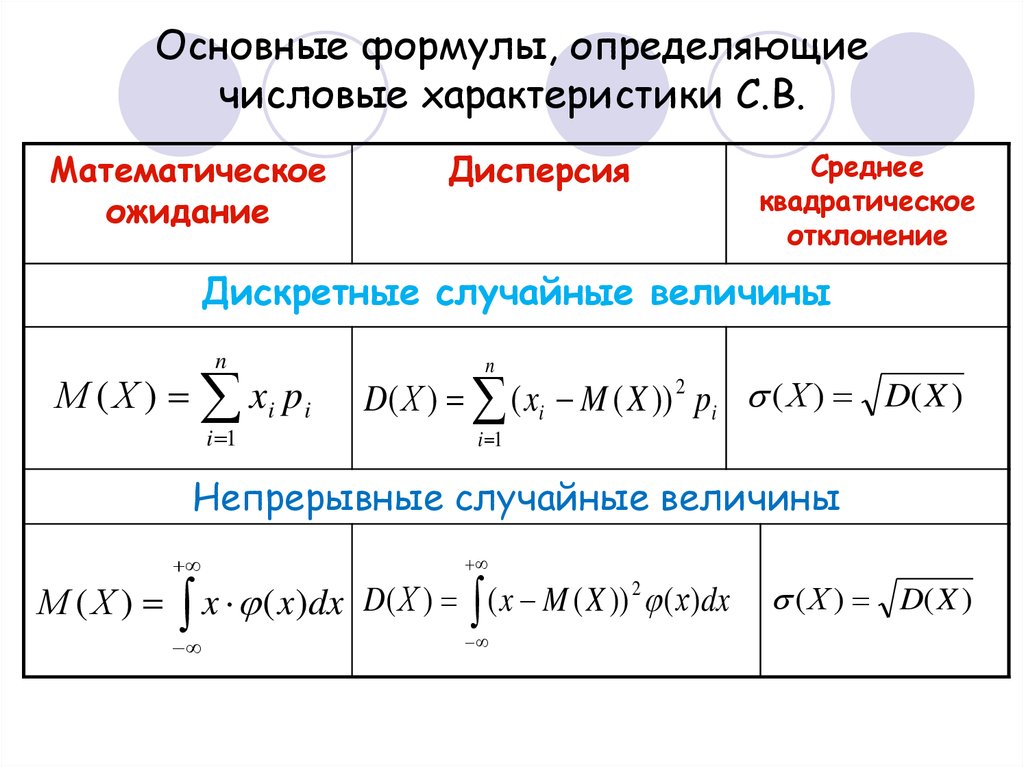

Существует также ещё один параметр, применяемый в данном разделе теории вероятностей. Это среднее квадратическое отклонение случайной величины. Его принимают равным квадратному корню из дисперсии и вычисляют как:

$\sigma(X)=\sqrt{D(X)}$

Пример 1

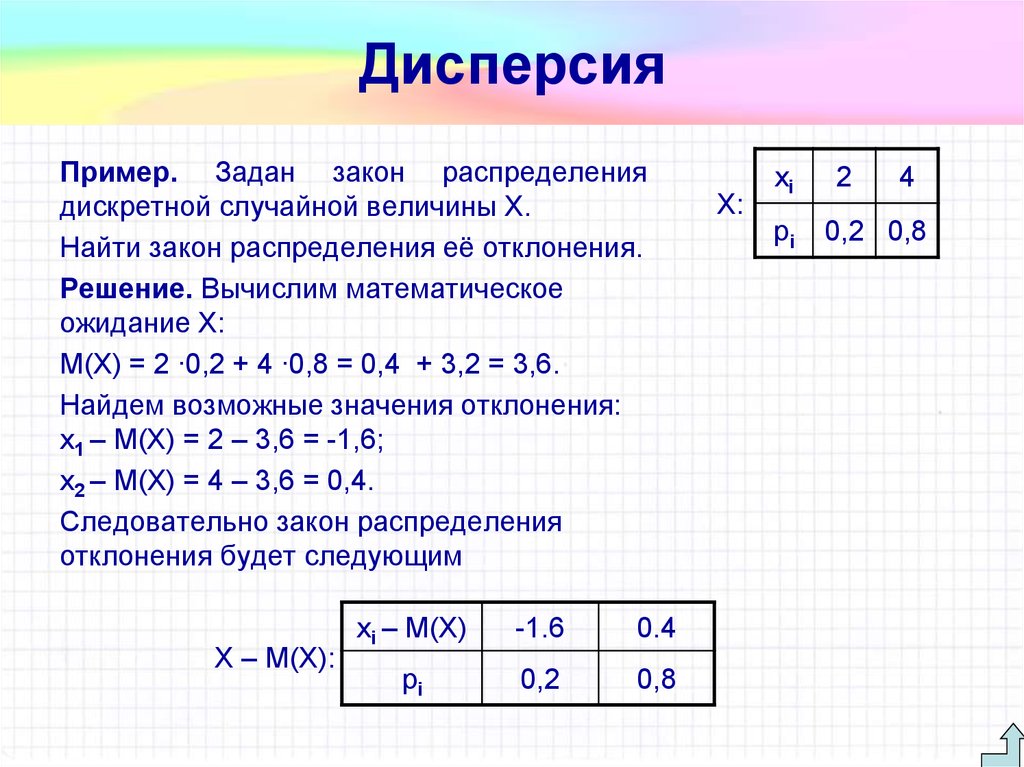

Предположим существует некоторая случайная величина Х. Её закон распределения представлен следующим образом:

- Вероятность события Х=1 составляет Р=1/6;

- Вероятность события Х=2 составляет Р=1/2;

- Вероятность события Х=3 составляет Р=1/3.

Тогда матожидание величины может быть вычислено следующим образом:

Чтобы вычислить дисперсию, запишем распределение для отклонения случайной величины от её матожидания, а также для квадрата этого отклонения:

Х-М(Х)= $-\frac{7}{6}$, Р= $\frac{1}{6}$. 2D(X)$

2D(X)$

Свойство 3

Если имеются две случайные величины независимые друг от друга, то будет верно утверждение, что дисперсия их суммы равняется сумме их дисперсий, а именно:

$D(X+Y)=D(X)+D(Y)$

Также из данного свойства можно вывести два следствия. Первое гласит, что дисперсия суммы нескольких случайных величины будет равняться сумме их дисперсий.

$D(X_1+X_2+…+X_n)=D(X_1)+D(X_2)+…+D(X_n)$

Другое следствие: дисперсия суммы случайной величины и постоянной будет равняться дисперсии просто случайной величины. Это следует из первого и третьего свойства дисперсии.

$D(C+X)=D(X)$

Свойство 4

Рассмотрим разность двух случайных величин. Общая дисперсия будет равна сумме их дисперсий. Это утверждение легко вывести из первого и третьего свойств.

$D(X-Y)=D(X)+D(Y)$

236

проверенных автора готовы помочь в написании работы любой сложности

Мы помогли уже 4 396 ученикам и студентам сдать работы от решения задач до дипломных на отлично! Узнай стоимость своей работы за 15 минут!

Пример 2

Необходимо определить дисперсию и среднеквадратическое отклонение для каждой из двух случайных величин, со следующими законами распределения:

- • Для Х — (Х=-0,1; Р=0,1), (Х=-0,01; Р=0,2), (Х=0; Р=0,4), (Х=0,01; Р=0,2), (Х=0,1; Р=0,1).

2 \cdot 0,3 = 260 $

2 \cdot 0,3 = 260 $Теперь нетрудно определить среднеквадратическое отклонение:

$\sigma(X)=\sqrt{0,00204}\approx 0,04517$

$\sigma(Y)=\sqrt{260}\approx\ 16,1$

Согласно полученным данным становится очевидно, что среднеквадратическое отклонение Х гораздо меньше, чем среднеквадратическое отклонение Y. Аналогична и большая разница дисперсий. Это при том, что матожидание обеих величин одинаково. Подобная разница характеризуется тем, что величины отражают различные свойства закона распределения случайных величин.

Пример 3

Банк предлагает четыре альтернативных проекта, связанных с инвестированием. При этом для каждого из проектов предоставлен прогноз по прибыли

- Проект 1: (Х=500; Р=1).

- Проект 2: (Х=1000; Р=0,5), (Х=0; Р=0,5).

- Проект 3: (Х=500; Р=0,5), (Х=1000; Р=0,25), (Х=0; Р=0,25).

- Проект 4: (Х=500; Р=0,5), (Х=-8500; Р=0,25), (Х=9500; Р=0,25).

Вычислим для каждого из проектов математическое ожидание, дисперсию, а также среднеквадратическое отклонение.

2 \cdot 0,25 = 40 500 000 $

2 \cdot 0,25 = 40 500 000 $Теперь нетрудно определить среднеквадратическое отклонение:

$\sigma(Х_1)=\sqrt{0}\approx 0$

$\sigma(Х_2)=\sqrt{2500}\approx\ 5$

$\sigma(Х_3)=\sqrt{1250}\approx 35,36$

$\sigma(Х_4)=\sqrt{40500000}\approx\ 636$

Математическое ожидание всех инвестиционных проектов одинаковое. В данном случае это означает, что в среднем, в долгосрочной перспективе доход на каждом проекте одинаков. Среднеквадратичное же отклонение характеризует риск, с которым столкнётся инвестор. Чем выше значение, тем больше риск. Наименее рискованным будет первый проект, наиболее рискованным четвёртый.

13. Дисперсия случайной величины, ее свойства. Среднеквадратичное отклонение.

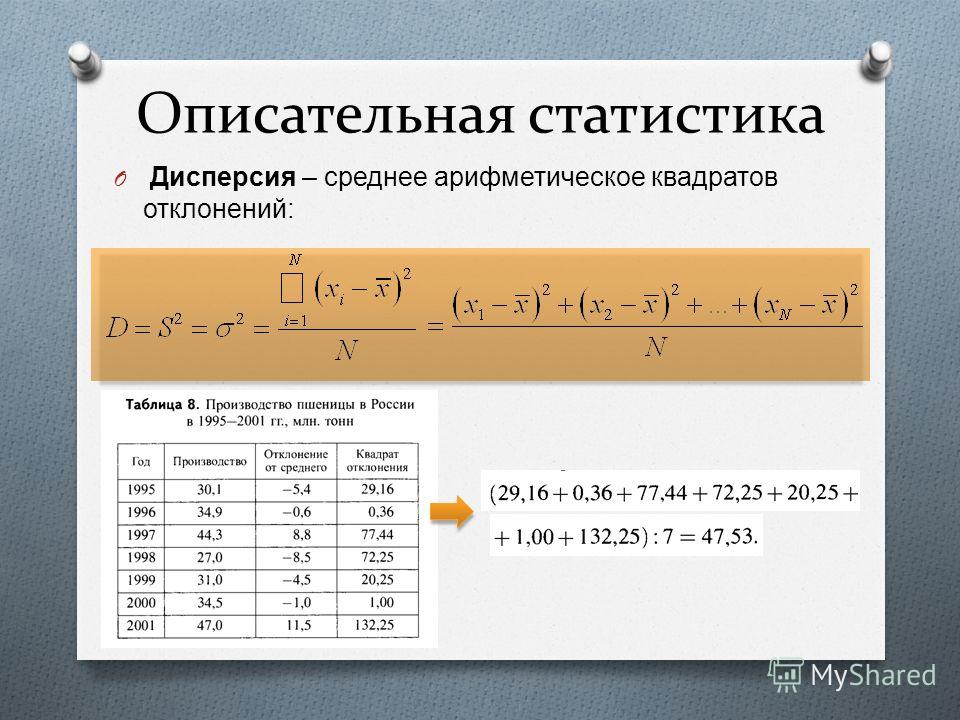

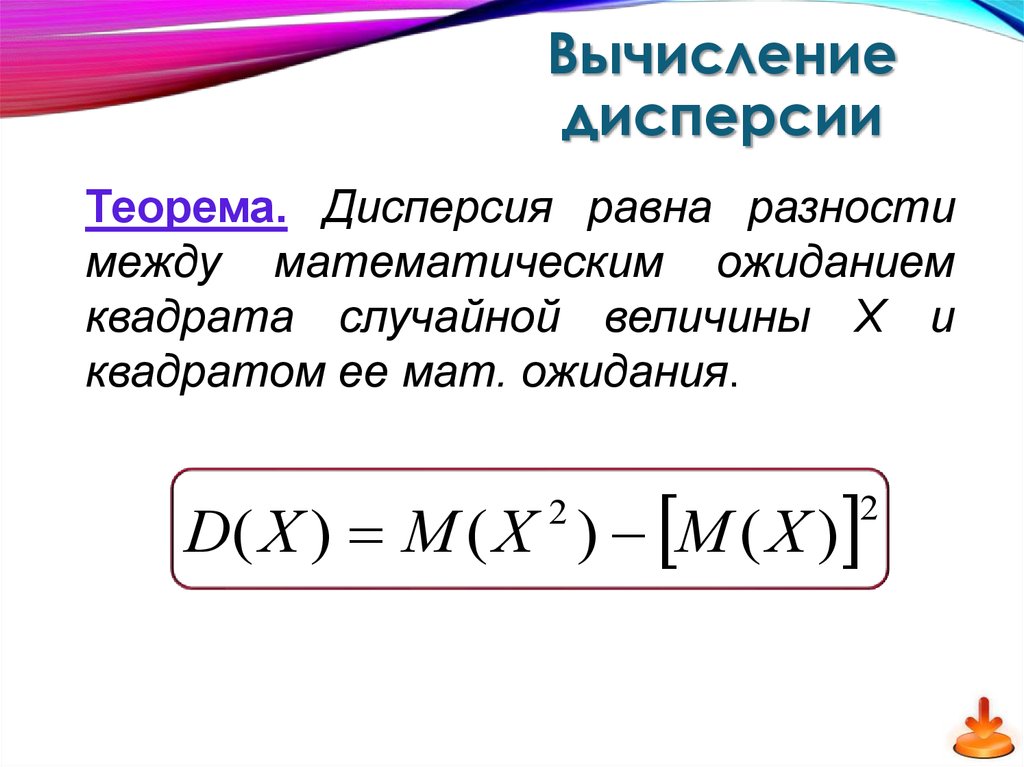

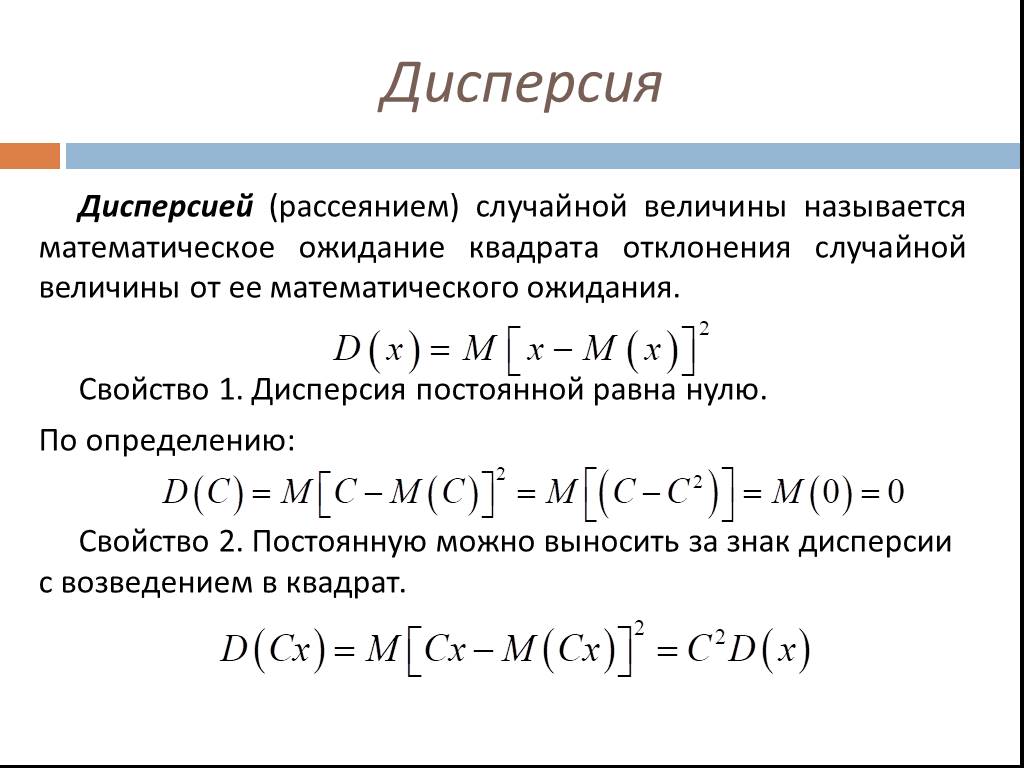

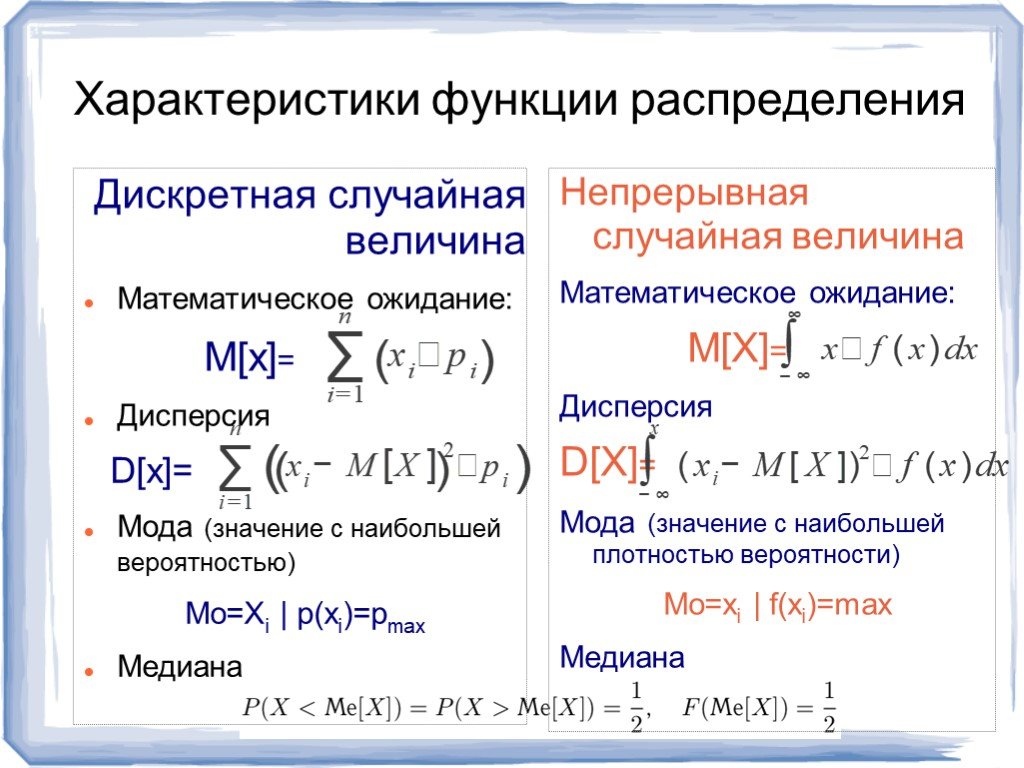

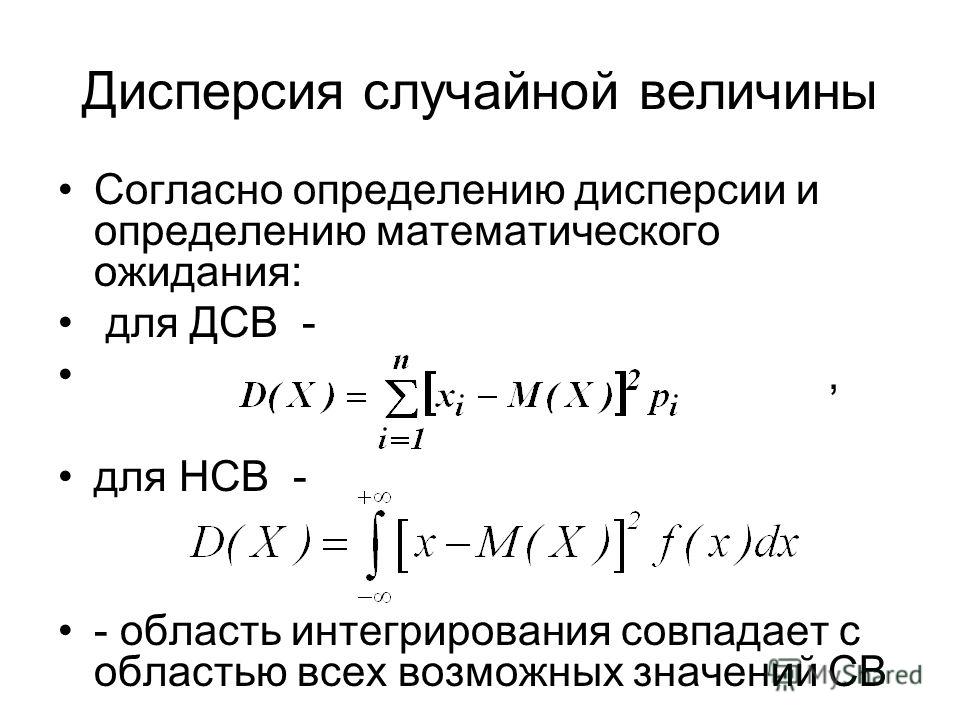

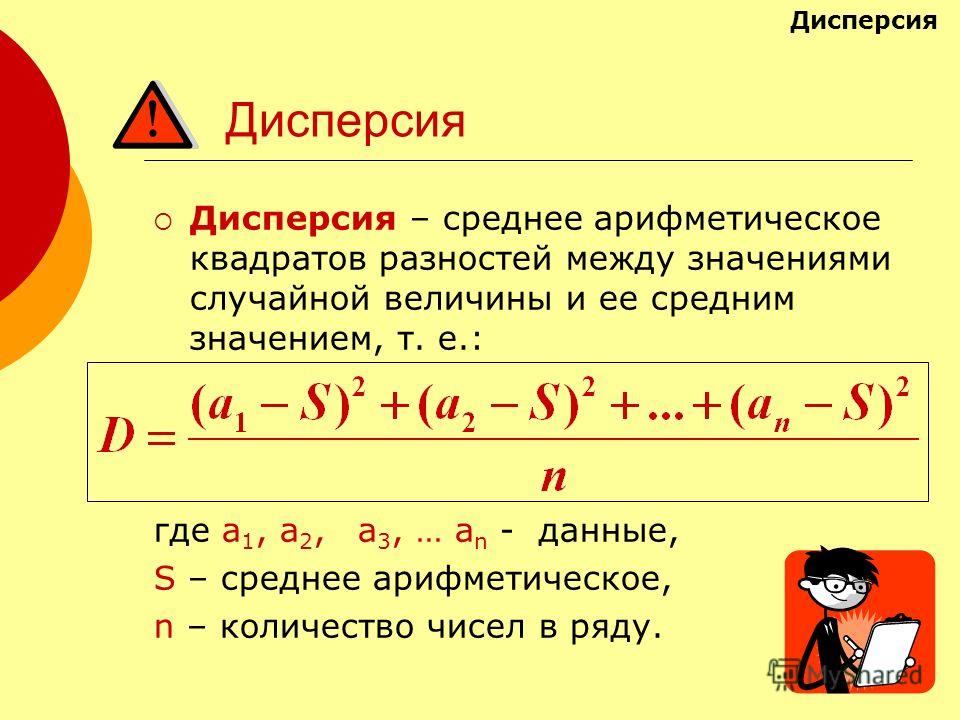

Дисперсией случайной величины X называется математическое ожидание квадрата отклонения случайно величины Х от ее математического ожидания: D(X)=M(X—M(X))2.

Свойства: 1) D[C]=0, где C=

2) D[CX]=C в квадрате на D[X]-постоянный множитель можно выносить за знак дисперсии,возведя его в квадрат

3) X,Y независимы, D[X+(-)Y]=D[X]+D[Y]

4) D[X+C]=D[X]

Для оценки рассеяния возможных значений случ вел вокруг ее среднего значения кроме дисперсии служат и некоторые другие характеристики.к их числу относят и среднекв отклон.

Среднеквадратическим отклонение случайной величины Х называется число, вычисляемое по формуле

Легко показать,что дисперсия имеет размерность ,равную квадрату размерности случ аеличины.

Т.к.

среднекв отклон = квадратному корню из

дисперсии,то размерность сигма(Х)

совпадает с размерностью Х.Поэтому в

тех случаях,когда желательно,чтобы

оценка рассеяния имела размерность

случ велич,вычисляют среднекв отклон,а

не дисперсию.

Т.к.

среднекв отклон = квадратному корню из

дисперсии,то размерность сигма(Х)

совпадает с размерностью Х.Поэтому в

тех случаях,когда желательно,чтобы

оценка рассеяния имела размерность

случ велич,вычисляют среднекв отклон,а

не дисперсию.Моме́нт случа́йной величины́ — числовая характеристика распределения данной случайной величины

Если дана случайная величина определённая на некотором вероятностном пространстве, то:

если математическое ожидание в правой части этого равенства определено;

если математическое ожидание в правой части этого равенства определено. Если определены моменты -го порядка, то определены и все моменты низших порядков В силу линейности математического ожидания центральные моменты могут быть выражены через начальные, и наоборот. Например:

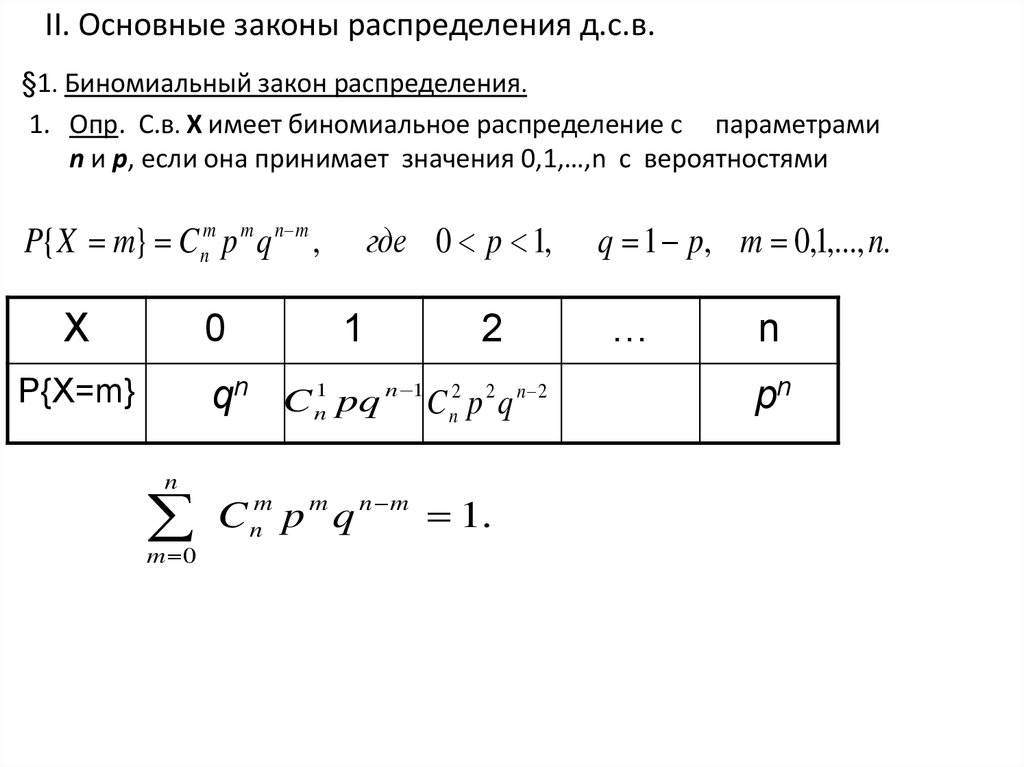

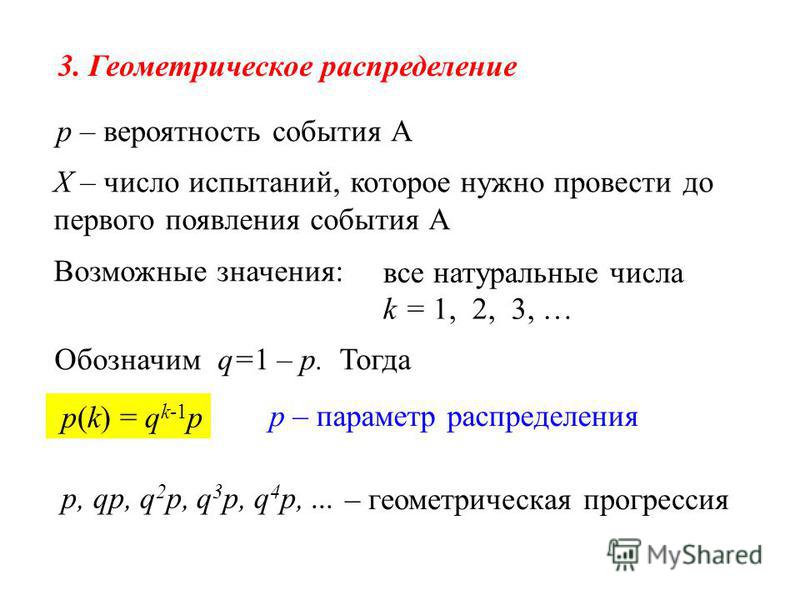

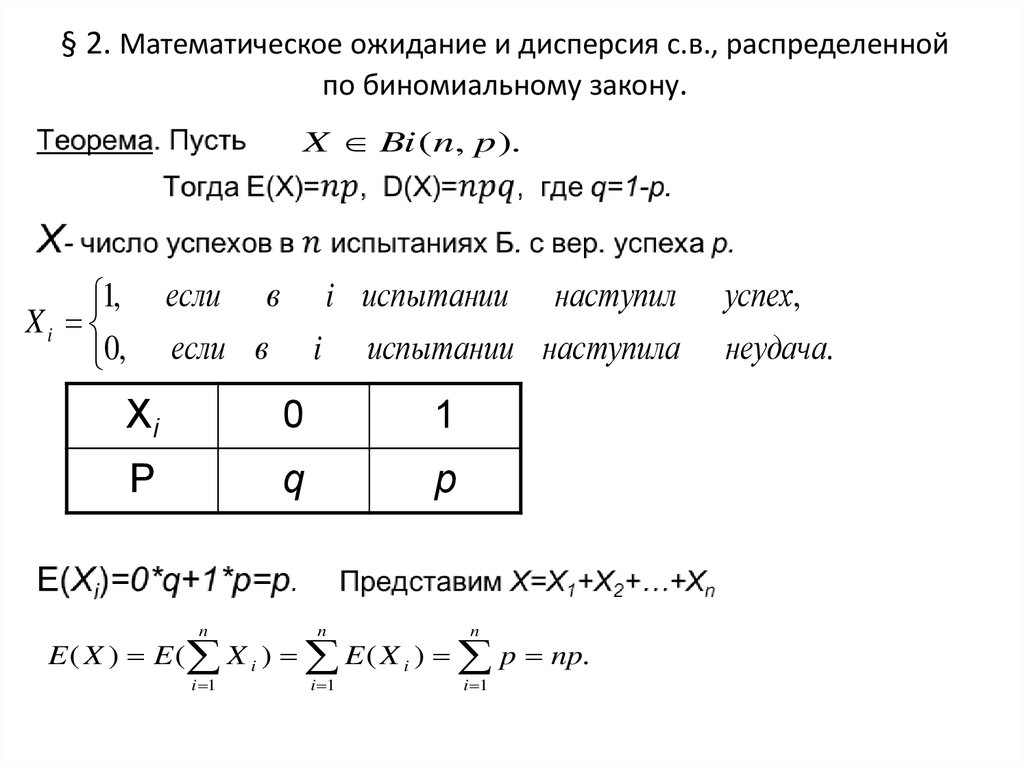

Биномиальным называется закон распределения дискретной случайной величины X – числа появлений события A в n независимых испытаниях, в каждом из которых появляется либо событие А, либо событие , и вероятность появления события А равна p, а вероятность появления события равна q=1-p.

Тогда P(X=k) – вероятность появления события А ровно k раз в n испытаниях – вычисляется по формуле Бернулли:

Если число испытаний n очень велико, а вероятность p появления события А в каждом испытании очень мала, то для вычисления

P(X=k) используют формулу Пуассона: , где . При этом говорят, что случайная величина Ч распределена по закону Пуассона.Мат ожид этого распредМ=np,а дисперсия D=npq

Распределение Пуассона.

Если число испытаний n очень велико, а вероятность p появления события А в каждом испытании очень мала, то для вычисления P(X=k) используют формулу Пуассона: , где . При этом говорят, что случайная величина Ч распределена по закону Пуассона.

Мат

ожид и дисперсия = лямбда

Мат

ожид и дисперсия = лямбдаТеорема Пуассона в теории вероятностей описывает способ получения распределения Пуассона как предел биномиальных распределений.Формулировка

Пусть есть Пусть также дана последовательность такая, что

Тогда

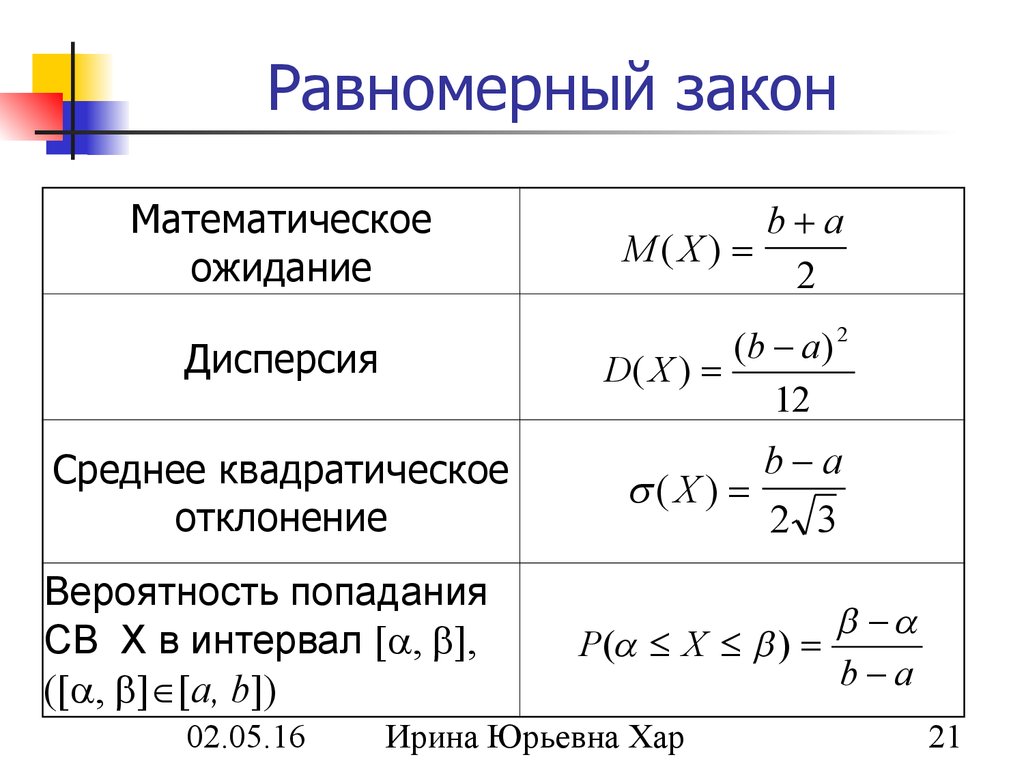

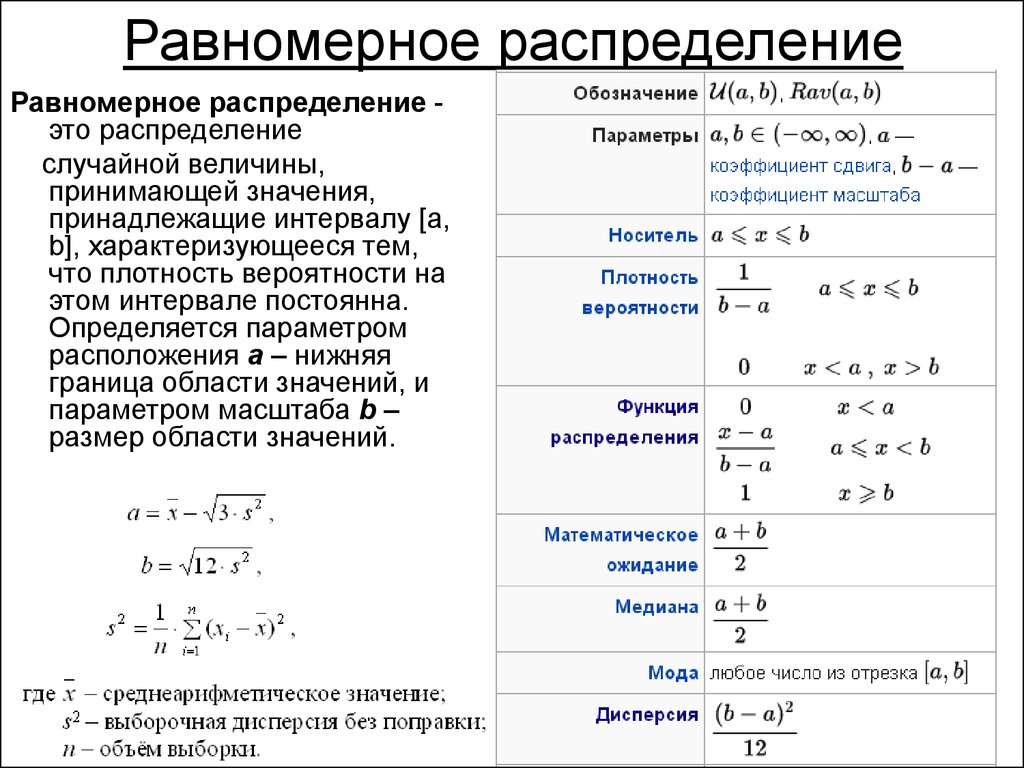

Равномерное распределение, его числовые характеристики.

Равномерным распределением называется распределение таких непрерывных случайных величин, все значения которых лежат на некотором интервале (a;b) и плотность распределения вероятностей задается формулой: . — функция распределения вероятностей таких случайных величин.

Мат ожид : М=(а+b)/2 дисперсия: D=(b-а)в квадрате/12

Числовые характеристики непрерывной случайной величины Х, равномерно распределенной в интервале (a;b), вычисляется по формулам: .

Вероятность попадания величины Ч в промежуток (а1;а2), где (а1;а2) (a;b), вычисляется по формуле: .

Показательное распределение, его числовые характеристики.

Показательным (или экспоненциальным) называется распределение таких непрерывных случайных величин, у которых функция плотности распределения вероятностей задается формулой: , где – некоторое постоянное положительное число.

Функция распределения F(x) таких случайных величин задается формулой:

Для непрерывной случайной величины Х, имеющей показательное распределение вероятностей, числовые характеристики вычисляются по формулам: M(X)=1/λ, D(X)=1/ λ

Вероятность попадания величины Х в интервал (a;b) вычисляется по формуле: P(a<X<b)=e-λa—e-λb.

Мат ожид =1/лямбда,а дисперсия -1/лямбда в квадрате

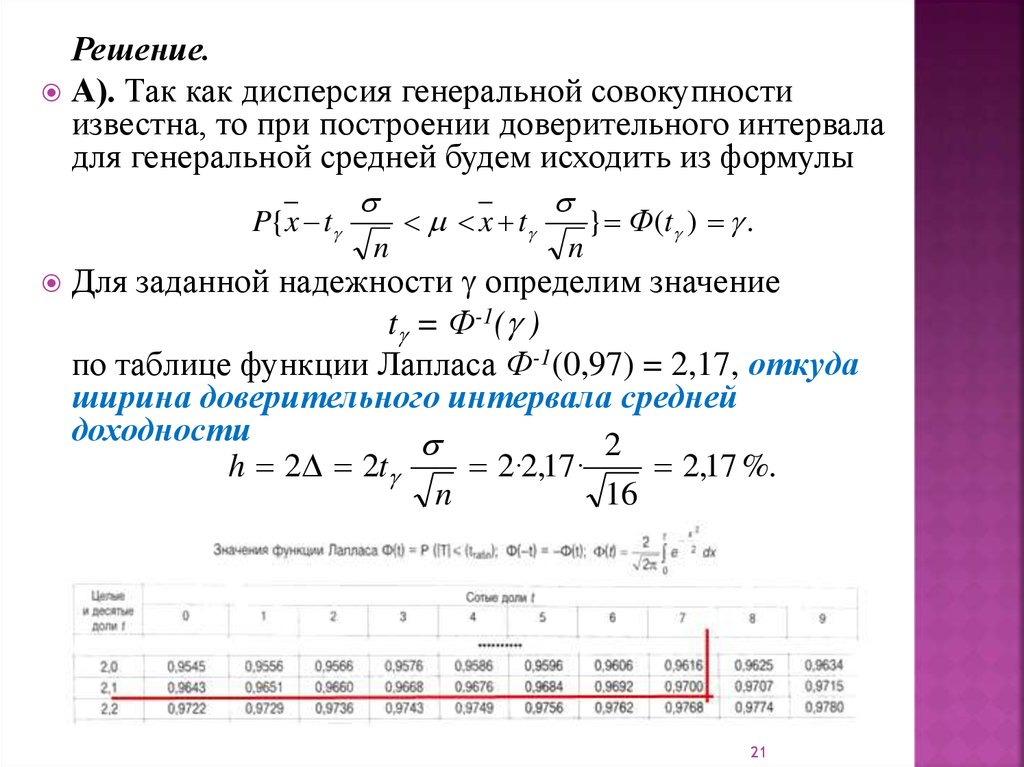

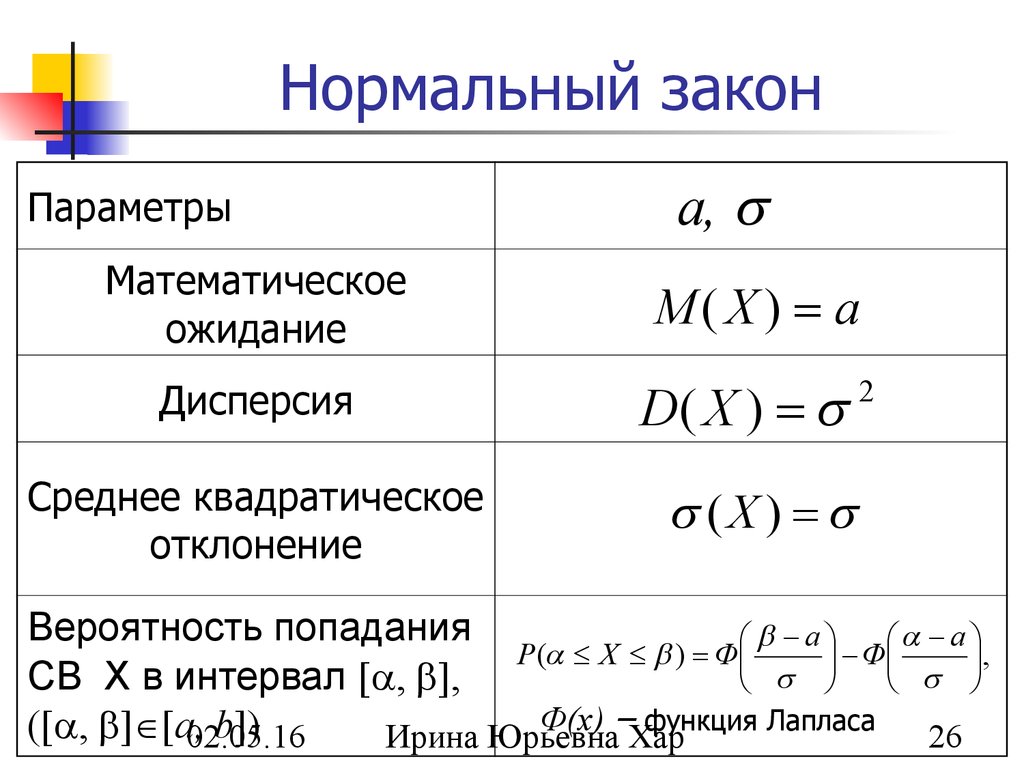

15. Нормальное распределение, его числовые характеристики. Выражение функции распределения через интеграл Лапласа. Вероятность попадания нормально распределенной случайной величины в заданный промежуток. «Правило трех сигм».

Нормальным называется распределение вероятностей тех непрерывных случайных величин, у которых плотность распределения задается формулой: где – некоторые числа(параметры) Достаточно знать эти параметры, чтобы задать нормальное распределение. Выясним смысл этих параметров и докажем, что m — это математическое ожидание, а сигма -среднеквадратическое отклонение.

В зависимости от параметров

аист

нормальное распределение может называться

немного по-разному. Общим

называется нормальное распределение

с произвольными параметрами м и

сигма (сигма>0)

В зависимости от параметров

аист

нормальное распределение может называться

немного по-разному. Общим

называется нормальное распределение

с произвольными параметрами м и

сигма (сигма>0)Нормированным называют нормальное распределение с параметрами m=0 и сигма=1. Например, если Х-нормальная величина с параметрами m и сигма, то U=(Х-m)/сигма — нормированная нормальная величина, причем, M(U)=0 и сигма(U)=1. Плотность нормированного распределения задается функцией, которая табулирована. Причем, если F(x) — функция общего нормального распределения, a F0(x) —

функция нормированного распределения, то легко проверить, что F(x)=Fo((x-m)/сигма).

График плотности нормального распределения называют нормальной кривой или кривой Гаусса. Если исследовать эту функцию, видно, что

Изменение величины параметра m не изменяет форму нормальной кривой, а приводит лишь к ее сдвигу вдоль оси ОХ: вправо, если m возрастает и влево, если m убывает.

По иному обстоит дело, если изменяется параметр сигма. Как уже было выяснено, максимум функции плотности нормального распределения равен 1/[сигма(2пи)1/2]. Поэтому, с возрастанием сигмы максимальная ордината нормальной кривой убывает, а сама кривая становится более пологой, т.е. сжимается к оси ОХ, при убывании сигмы нормальная кривая становится более «островершинной». Важно отметить, что при любых значениях параметров аист, площадь, ограниченная нормальной кривой и осью ОХ остается равной единице (свойство плотности распределения). При m=0 и сигма=1 кривую называют нормированной.

В случае нормального закона распределения функция распределения вероятностей вычисляется по формуле: , где – функция Лапласа (или интеграл вероятностей, или функция ошибок).

Числовые характеристики случайной величины Х, заданной нормальным законом распределения, вычисляются по формулам: .

Вероятность того, что случайная величина Х примет значения из интервала (a;b), вычисляется по формуле: .

Следствие1: вероятность того, что модуль разности |X—a| меньше некоторого числа δ .

Следствие2: (правило трех сигм): если в следствии1 вместо δ подставить число 3δ, то вероятность того, что модуль разности |X—a|<3δ. На практике правило 3 сигм применяют так:если распределение изучаемой случ вел неизвестно,но условие,указанное в приведенном правиле,выполняется,то есть основание предполагать ,что изучаемая величина распределена нормально.

Урок 28 Дисперсия | Введение в вероятность

Мотивирующий пример

На уроке 22 вы показали, что в рулетке каждая ставка имеет ровно тот же ожидаемый выигрыш. То есть их п.м.с. имеют один и тот же центр масс.

Значит ли это, что все ставки одинаковы? Нет! Ставка на один номер более рискованно, потому что у вас есть небольшой шанс (\(1/38\)) заработать много денег (35 долларов).

2].

\тег{28.1}

\end{уравнение}\] 92 \cdot \frac{20}{38} & \text{(LOTUS)}\\

&= 0,997.

\конец{выравнивание*}\]

2].

\тег{28.1}

\end{уравнение}\] 92 \cdot \frac{20}{38} & \text{(LOTUS)}\\

&= 0,997.

\конец{выравнивание*}\]Мы видим, что дисперсии этих ставок очень разные, хотя их ожидаемые значения одинаковы.

Возможно, вас удивит, насколько велика дисперсия ставки на один номер. Это потому что дисперсия составляет в квадрате единиц. То есть дисперсия ставки на один номер составляет 33,21 доллара в квадрате . Поскольку единицы измерения в квадрате часто не поддаются интерпретации (что такое «доллар в квадрате»?), принято сообщать квадратный корень из дисперсии, число, называемое стандартное отклонение .

Определение 28.2 (Стандартное отклонение) Стандартное отклонение случайной величины \(X\) определяется как \[ \text{SD}[X] = \sqrt{\text{Var}[X]}. \] Она находится в тех же единицах, что и исходная случайная величина. Он измеряет, в среднем, насколько случайная величина находится от его центра.

Пример 28.2 (SD рулетки) Выше мы показали, что дисперсия \[ \text{Переменная}[X] = 33,21. \] Стандартное отклонение \[ \text{SD}[X] = \sqrt{\text{Var}[X]} = \sqrt{33,21} = \$5,76. \] Это стандартное отклонение выражается в долларах, как и случайная величина \(X\). 92\\ &= n \frac{N_1}{N} \left( (n-1) \frac{N_1}{N} + 1 — n \frac{N_1}{N} \right) \\ &= n \frac{N_1}{N} \underbrace{\left( 1 — \frac{N_1}{N} \right)}_{\frac{N_0}{N}}. \конец{выравнивание*}\]

Позже в этой книге мы увидим более простой способ получения того же результата.

Теперь, если мы знаем, что случайная величина \(X\) имеет биномиальное распределение, мы можем использовать формулу \[ \text{Var}[X] = n\frac{N_1}{N} \frac{N_0}{N} \] вместо того, чтобы вычислять его с нуля. Мы можем аналогичным образом вывести формулы для дисперсий всех названных распределений. Формулы приведены в Приложении A.1.

Если ваша случайная величина соответствует одному из этих именованных распределений, тогда вы можете просто посмотреть его дисперсию в Приложении A.

1. это еще один

преимущество изучения этих именованных дистрибутивов!

1. это еще один

преимущество изучения этих именованных дистрибутивов!Основная практика

Покажите, что дисперсия случайной величины \(\text{Пуассона}(\mu)\) равна \(\mu\). (Другими словами, я с просьбой вывести результат из приведенной выше таблицы.)

(Подсказка: на уроке 24 вы получили \(E[X(X-1)]\) для случайной величины Пуассона. Используйте этот результат и следуйте примеру 28.3 выше.)

Описать случайную величину \(X\) с \(\text{Var}[X] = 0\).

В карнавальной игре на удачу бросают три кости. Вы делаете ставку на выпадение определенного числа (1, 2, 3, 4, 5, 6). Выплата составляет 1 к 1, если это число выпадает (ровно) на одном кубике, 2 к 1, если оно выпадает на двух кубиках, и 3 к 1, если оно выпадает на всех трех. (Вы теряете свою первоначальную ставку, если ваше число не выпадает ни на одном из кубиков.) Если вы делаете ставку в 1 доллар на число три, что стандартное отклонение вашего нетто выигрышей?

(Подсказка: вы уже рассчитали математическое ожидание в Уроке 22.

Используйте это вместе с сокращенной формулой (28.2).)

Используйте это вместе с сокращенной формулой (28.2).)Пакеты поступают на определенный узел внутренней сети университета со средней скоростью 10 пакетов в минуту. Предположим, что прибытие пакетов удовлетворяет предположениям о пуассоновском процессе. Что такое стандартное отклонение количество прибытий, которые вы ожидаете увидеть за 5-минутный период?

Дополнительная практика 92}\).

(Подсказка: вы вычислили \(E[(X+1)X]\) для отрицательной биномиальной случайной величины в Уроке 24.)

- Среднее, мода и медиана. Здесь я представил 3 наиболее распространенных показателя центральной тенденции («три М») в статистике. Я показал, как вычислить каждый из них для набора значений, а также их интуитивную интерпретацию. В текущем посте я сосредоточусь только на среднем значении.

- Закон больших чисел. Интуитивное введение. Это очень важная теорема теории вероятностей, которая связывает вероятности исходов с их относительной частотой возникновения.

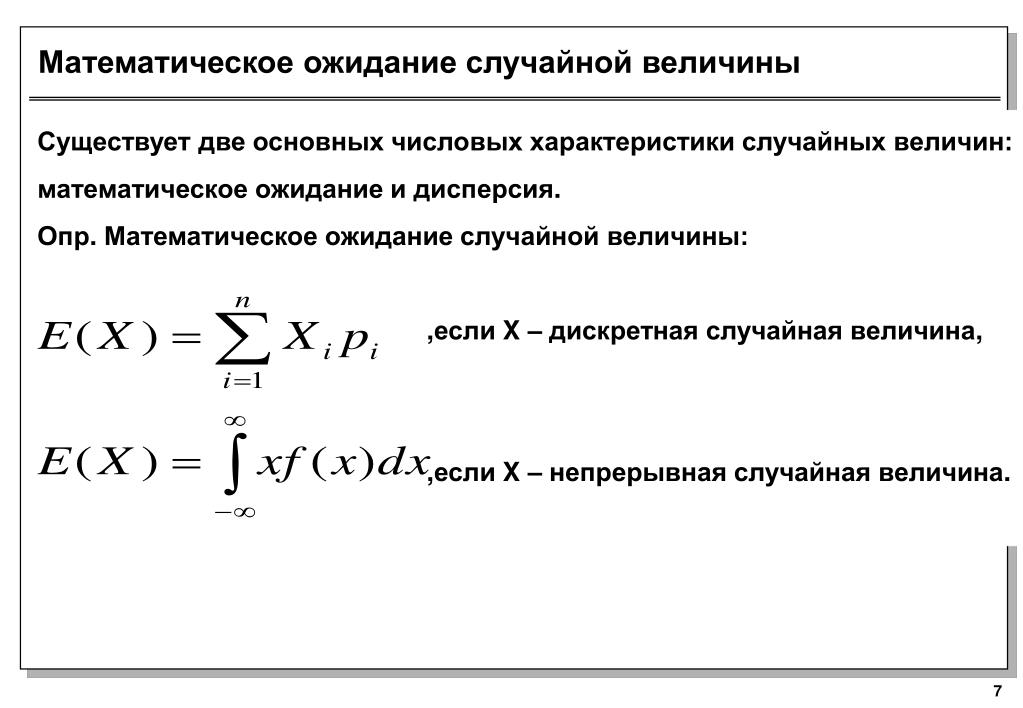

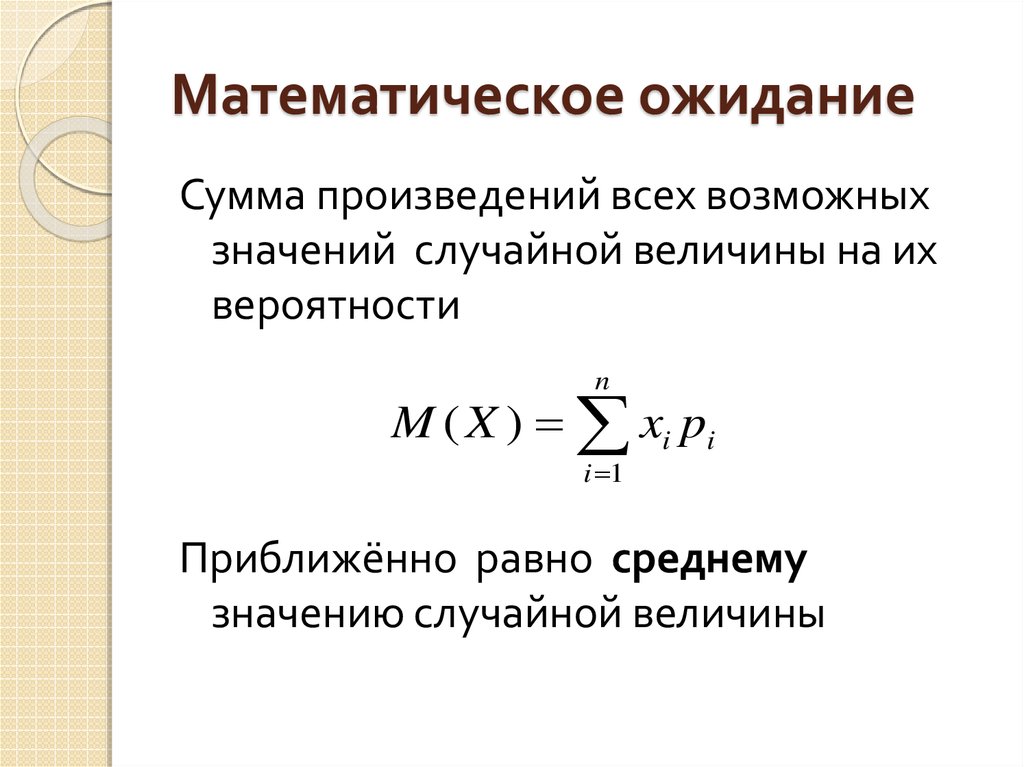

- Интуитивное объяснение ожидаемого значения: В этом посте я показал, как вычислить долгосрочное среднее значение случайной величины, умножив каждое из ее возможных значений на соответствующие вероятности и суммируя эти произведения.

- Дисперсия: Измерение дисперсии: В этом посте я определил различные меры дисперсии набора значений. В текущем посте я сосредоточусь исключительно на дисперсии.

- Введение в распределения вероятностей. Наконец, в этом посте я рассказал о распределениях вероятностей, которые представляют собой присвоения вероятностных масс или плотностей вероятностей каждому возможному результату случайной величины. Распределения вероятностей также являются главным героем текущего поста.

- Среднее = 1/6 + 1/6 + 1/6 + 3/6 + 3/6 + 5/6 = 2,33

- Среднее значение = 3/6 * 1 + 2/6 * 3 + 1/6 * 5 = 2,33

- Когда M приближается к бесконечности, среднее значение выборки размером M будет приближаться к среднему значению исходной коллекции.

- Среднее значение распределения вероятностей есть не что иное, как его ожидаемое значение.

- Среднее и дисперсия

- Закон больших чисел

- Ожидаемое значение

- Распределение вероятностей 788 Я также ввел различие между выборками и популяциями.

Среднее значение и дисперсия распределений вероятностей

В моем предыдущем посте я познакомил вас с распределениями вероятностей .

Короче говоря, распределение вероятностей просто берет всю вероятностную массу случайной величины и распределяет ее по возможным результатам. Поскольку каждая случайная величина имеет общую вероятностную массу, равную 1, это просто означает разбиение числа 1 на части и присвоение каждой части какому-либо элементу выборочного пространства переменной (неформально говоря).

В этом посте я хочу немного углубиться в распределения вероятностей и исследовать некоторые их свойства. А именно, я хочу поговорить о мерах центральной тенденции ( среднее ) и дисперсии ( дисперсии ) распределения вероятностей.

Содержание

Связь с предыдущими постами

Этот пост является естественным продолжением моих предыдущих 5 постов. В каком-то смысле он связывает все понятия, которые я в них ввел:

Без лишних слов давайте посмотрим, как они все объединятся.

Введение

Любой конечный набор чисел имеет среднее значение и дисперсию. В моих предыдущих сообщениях я дал их соответствующие формулы. Вот как можно вычислить среднее значение, если мы пометим каждое значение в наборе как x 1 , x 2 , x 3 , x 4 , …, x n , …, x N :

Если вы не знакомы с этой нотацией, взгляните на мой пост, посвященный оператору суммы. Все, что говорит эта формула, это то, что для вычисления среднего значения N вы сначала берете их сумму, а затем делите на N (их количество).

Все, что говорит эта формула, это то, что для вычисления среднего значения N вы сначала берете их сумму, а затем делите на N (их количество).

Вот как можно рассчитать дисперсию той же коллекции:

Итак, вы вычитаете каждое значение из среднего значения коллекции и возводите результат в квадрат. Затем вы складываете все эти квадраты разностей и делите окончательную сумму на N. Другими словами, дисперсия равна средней квадратичной разнице между значениями и их средним значением.

Если вы имеете дело с конечными наборами, это все, что вам нужно знать о вычислении их среднего значения и дисперсии. Конечные коллекции включают популяций с конечным размером и выборок популяций. Но при работе с бесконечными популяциями все немного по-другому.

Позвольте мне сначала определить различие между выборками и совокупностями, а также понятие бесконечной совокупности.

Выборки по сравнению с совокупностями

Выборка — это просто подмножество результатов из более широкого набора возможных результатов, полученного из совокупности .

Например, если вы измеряете рост случайно выбранных студентов из какого-то университета, выборка представляет собой выбранное вами подмножество студентов. Население может состоять из всех студентов одного и того же университета. Или это могут быть все студенты университетов страны. Или все студенты университетов мира. Важно, чтобы все члены выборки также были членами более широкой совокупности.

Очевидно, что образцы различаются по размеру. Технически даже 1 элемент можно считать образцом. Полезен ли тот или иной размер, конечно, зависит от ваших целей. Как правило, чем больше выборка, тем более репрезентативной она будет для населения, из которого она была составлена.

Максимальный размер выборки, безусловно, равен размеру совокупности. Таким образом, если ваша выборка включает каждого члена населения, вы — это , по сути, имеющие дело с самим населением.

Также важно отметить, что набор значений является выборкой или генеральной совокупностью, зависит от контекста. Например, если вы хотите узнать что-то только о студентах Университета X, то студенты Университета X составляют все ваше население. С другой стороны, если вы хотите узнать что-то обо всех студентах страны, то студенты из Университета X будут выборкой вашей целевой группы.

Например, если вы хотите узнать что-то только о студентах Университета X, то студенты Университета X составляют все ваше население. С другой стороны, если вы хотите узнать что-то обо всех студентах страны, то студенты из Университета X будут выборкой вашей целевой группы.

Конечные и бесконечные популяции

Одно из различий между выборкой и совокупностью состоит в том, что выборка всегда имеет конечный размер. С другой стороны, размер популяции может быть конечным, но также может быть и бесконечным. Бесконечное население — это просто население с бесконечным числом членов.

Где мы сталкиваемся с бесконечными популяциями в реальной жизни? Ну, мы действительно не знаем. В любой данный момент количество любого вида сущностей является фиксированной конечной величиной. Даже число атомов в наблюдаемой Вселенной конечно. Бесконечные популяции — это скорее математическая абстракция. Они рождаются из гипотетического бесконечного повторения случайного процесса.

Например, если мы предположим, что Вселенная никогда не умрет и наша планета сможет поддерживать жизнь вечно, мы могли бы считать популяцию когда-либо существовавших и когда-либо существовавших организмов бесконечной.

Но бесконечные популяции действительно вступают в игру, когда мы говорим о распределениях вероятностей. Распределение вероятностей — это то, из чего вы можете генерировать сколь угодно большие выборки. На самом деле, в некотором смысле это суть распределения вероятностей. Вы помните из моего вступительного поста, что один из способов просмотра распределения вероятностей случайной величины — это теоретический предел ее относительного частотного распределения (поскольку число повторений приближается к бесконечности).

Среднее значение и дисперсия бесконечных совокупностей

Как я уже говорил ранее, имея дело с конечными совокупностями, вы можете вычислить среднее значение или дисперсию совокупности точно так же, как вы это делаете для выборки этой совокупности. А именно, принимая во внимание всех членов населения, а не только выбранное подмножество. Например, чтобы вычислить среднее значение совокупности, вы должны суммировать значения каждого члена и разделить на общее количество членов.

Но что, если мы имеем дело со случайной величиной, которая может постоянно давать результаты (например, подбрасывание монеты или бросание игральной кости)? В этом случае у нас будет бесконечная популяция, а выборка будет состоять из любого конечного числа произведенных результатов.

Итак, вы можете думать о множестве результатов случайной величины как о бесконечной последовательности результатов, полученных в соответствии с ее распределением вероятностей. Но как вычислить среднее значение или дисперсию бесконечной последовательности результатов?

Ответ на самом деле удивительно прост. Ожидаемое значение на помощь!

В своем посте об ожидаемом значении я определил его как сумму произведений каждого возможного значения случайной величины и вероятности этого значения.

Итак, как мы можем использовать концепцию ожидаемого значения для вычисления среднего значения и дисперсии распределения вероятностей? Ну, интуитивно говоря, среднее значение и дисперсия распределения вероятностей — это просто среднее значение и дисперсия выборки распределения вероятностей, когда размер выборки приближается к бесконечности. Другими словами, среднее значение распределения — это «ожидаемое среднее», а дисперсия распределения — это «ожидаемая дисперсия» очень большой выборки результатов распределения.

Другими словами, среднее значение распределения — это «ожидаемое среднее», а дисперсия распределения — это «ожидаемая дисперсия» очень большой выборки результатов распределения.

Давайте посмотрим, как это работает на самом деле.

Среднее значение распределения вероятностей

Допустим, нам нужно вычислить среднее значение набора {1, 1, 1, 3, 3, 5}.

Согласно формуле это равно:

Используя распределительное свойство умножения над сложением, эквивалентный способ выражения левой части:

Или:

То есть вы берете каждое уникальное значение в наборе и умножаете его на коэффициент k / 6 , где k — количество вхождений значения.

Среднее и ожидаемое значение распределения — это одно и то же

Не напоминает ли фактор

вероятности (согласно классическому определению вероятности)? Обратите внимание, например, что:

На самом деле, проще всего интерпретировать их как вероятности, если представить случайным образом взятые значения из {1, 1, 1, 3, 3, 5} и сразу после этого заменить их. Тогда каждое из трех значений будет иметь вероятность выпадения при каждом отдельном испытании.

Тогда каждое из трех значений будет иметь вероятность выпадения при каждом отдельном испытании.

С помощью этого процесса мы, по сути, создаем случайную величину из конечного набора. И, как и все случайные величины, она имеет бесконечную совокупность потенциальных значений, поскольку вы можете продолжать рисовать столько из них, сколько захотите. И, естественно, оно имеет базовое распределение вероятностей.

Если вы повторите процесс рисования M раз, по закону больших чисел мы знаем, что относительная частота каждого из трех значений будет приближаться к k / 6 по мере того, как M приближается к бесконечности. Итак, используя представление формулы среднего

, мы можем заключить следующее:

А теперь внимательно посмотрите на последнее выражение. Вы заметили, что она на самом деле эквивалентна формуле ожидаемой стоимости? Таким образом, мы достигаем важного понимания!

Если вы помните, в моем посте об ожидаемом значении я определил его именно как долгосрочное среднее случайной величины. Итак, это должно иметь большой смысл.

Среднее дискретных распределений

Вот общая формула для среднего любого дискретного распределения вероятностей с N возможными исходами:

Как видите, это идентично выражению для ожидаемого значения. Сравним это с формулой для среднего конечного набора:

Опять же, поскольку N является константой, используя свойство распределения, мы можем поместить 1/N в оператор суммы. Тогда каждый терм будет иметь вид

.

Вы снова можете интерпретировать фактор

как вероятность каждого значения в наборе. Я надеюсь, что это дало вам хорошее представление о взаимосвязи между двумя формулами.

Теперь давайте воспользуемся этим, чтобы вычислить среднее фактического распределения. Вернемся к одному из моих любимых примеров бросания игральной кости. Возможные значения: {1, 2, 3, 4, 5, 6}, и каждое имеет вероятность

Возможные значения: {1, 2, 3, 4, 5, 6}, и каждое имеет вероятность

. Итак, среднее (и ожидаемое значение) этого распределения равно:

Итак, среднее значение распределения вероятностей равно 3,5, и что? Ну, во-первых, если вы создадите конечную выборку из распределения, ее среднее значение будет приближаться к 3,5 по мере увеличения ее размера.

Давайте посмотрим, как это работает на симуляции прокатки игральной кости. Анимация ниже показывает 250 независимых бросков кубика. Высота каждой полосы представляет собой процент каждого результата после каждого броска.

Нажмите на изображение, чтобы запустить/перезапустить анимацию.

Обратите внимание, как среднее значение колеблется вокруг ожидаемого значения 3,5 и в конце концов начинает приближаться к нему. Если размер выборки превысит 1 миллион, среднее значение выборки будет очень близко к 3,5.

Среднее непрерывного распределения

В моем вводном посте о распределениях вероятностей я объяснил разницу между дискретными и непрерывными случайными величинами. Давайте быстро напомним о последнем.

Давайте быстро напомним о последнем.

Короче говоря, выборочное пространство непрерывной случайной величины находится на прямой с действительными числами. Поскольку его возможные результаты — действительные числа, между ними нет промежутков (отсюда и термин «непрерывный»). Функция, лежащая в основе его распределения вероятностей, называется функцией плотности вероятности .

В посте я также объяснил, что точные исходы всегда имеют вероятность 0, и только интервалы могут иметь ненулевые вероятности. И, чтобы вычислить вероятность интервала, вы берете интеграл функции плотности вероятности по нему.

Новый взгляд на непрерывные случайные величины

Давайте посмотрим на пример высоты сосны из того же поста. График ниже показывает его функцию плотности вероятности. Заштрихованная область — это вероятность того, что дерево будет иметь высоту от 14,5 до 15,5 метров.

Давайте использовать обозначение f(x) для функции плотности вероятности (здесь x обозначает высоту). Тогда выражение для интеграла будет:

Тогда выражение для интеграла будет:

В разделе интегралов моего поста, посвященного нулевой вероятности, я сказал, что один из способов взглянуть на интегралы — это как на оператор суммы, но для непрерывных случайных величин. То есть приведенное выше выражение означает «бесконечную сумму» всех значений f(x), где x находится в интервале [14.5, 15.5]. Что получается примерно 0,383.

Поскольку общая вероятностная масса всегда равна 1, следующее также должно иметь смысл:

Фактически, эта формула справедлива в общем случае для любой непрерывной случайной величины. Интеграл его функции плотности вероятности от отрицательной до положительной бесконечности всегда должен быть равен 1, чтобы не противоречить аксиомам вероятности Колмогорова.

Вам может быть интересно, почему мы интегрируем от отрицательной к положительной бесконечности. Что, если возможные значения случайной величины являются лишь подмножеством действительных чисел? Например, дерево не может иметь отрицательную высоту, поэтому отрицательных действительных чисел явно нет в пространстве выборки. Другим примером может быть равномерное распределение на фиксированном интервале, подобное этому:

Другим примером может быть равномерное распределение на фиксированном интервале, подобное этому:

На самом деле это не проблема, поскольку мы можем просто присвоить 0 плотности вероятности всем значениям за пределами выборочного пространства. Таким образом, они не будут способствовать окончательному значению интеграла. То есть интегрирование от положительной до отрицательной бесконечности дало бы тот же результат, что и интегрирование только по интервалу, где функция больше нуля.

Формула среднего значения непрерывной случайной величины

Итак, после всего сказанного не должно быть слишком удивительным, если я скажу вам, что формула среднего значения для непрерывных случайных величин выглядит следующим образом:

Обратите внимание на сходство с дискретный вариант формулы:

Вместо

здесь имеем . По сути, мы умножаем каждый x на его плотность вероятности и «суммируем» произведения.

Как и в случае с дискретными случайными величинами, здесь среднее равно ожидаемому значению. И если мы продолжим генерировать значения из функции плотности вероятности, их среднее значение будет сходиться к теоретическому среднему распределению.

И если мы продолжим генерировать значения из функции плотности вероятности, их среднее значение будет сходиться к теоретическому среднему распределению.

Кстати, если вы не знакомы с интегралами, не беспокойтесь о терме dx . Это означает что-то вроде «бесконечно малый интервал по x». Не стесняйтесь проверить мой пост о нулевых вероятностях, чтобы получить представление об этом.

Важно отметить, что не все функции плотности вероятности имеют определенные средние значения. Хотя эта тема выходит за рамки текущего поста, причина в том, что приведенный выше интеграл не сходится к 1 для некоторых функций плотности вероятности (он расходится к бесконечности). Я собираюсь вернуться к этому в будущих постах, связанных с такими дистрибутивами.

Ну, это по средствам. Если есть что-то, в чем вы не уверены, что понимаете полностью, не стесняйтесь спрашивать в разделе комментариев ниже.

Теперь давайте взглянем на другую основную тему этого поста: дисперсию.

Дисперсия распределения вероятностей

В этом разделе я обсуждаю основную формулу дисперсии вероятностных распределений. Чтобы увидеть две полезные (и проницательные) альтернативные формулы, ознакомьтесь с моим последним постом.

Сразу скажу, что интуиция здесь очень похожа на интуицию средств. Дисперсия распределения вероятностей — это теоретический предел дисперсии выборки распределения, когда размер выборки приближается к бесконечности.

Формула дисперсии для набора с N значениями:

А вот формула дисперсии дискретного распределения вероятностей с N возможными значениями:

Вы видите аналогию с формулой среднего? По сути, дисперсия — это ожидаемое значение квадрата разницы между каждым значением и средним значением распределения. В конечном случае это просто среднеквадратическая разница.

И для полноты картины вот формула дисперсии для непрерывных распределений вероятностей:

Опять же, обратите внимание на прямое сходство с дискретным случаем. В частности, сходства между терминами:

В частности, сходства между терминами:

В обоих случаях мы «суммируем» все возможные значения случайной величины и умножаем каждую квадратную разницу на вероятность или плотность вероятности значения. Чтобы получить лучшую интуицию, давайте воспользуемся дискретной формулой для расчета дисперсии распределения вероятностей. На самом деле, давайте продолжим пример с прокаткой штампов.

Дисперсия броска кубика

Давайте сделаем это шаг за шагом.

Сначала нам нужно вычесть каждое значение в {1, 2, 3, 4, 5, 6} из среднего значения распределения и взять квадрат. Что ж, из предыдущего раздела мы уже знаем, что среднее значение равно 3,5. Итак, 6 термов:

Ну, в этом случае все они имеют вероятность 1/6, так что мы можем просто использовать свойство дистрибутивности:

Что равно:

Таким образом, дисперсия этого распределения вероятностей составляет примерно 2,92.

Чтобы получить представление об этом, давайте сделаем еще одну симуляцию бросков костей. Я написал короткий код, который генерирует 250 случайных бросков и вычисляет текущую относительную частоту каждого результата и дисперсию выборки после каждого броска. Нажмите на изображение ниже, чтобы увидеть анимированную симуляцию:

Нажмите на изображение, чтобы запустить/перезапустить анимацию.

Вы видите, как текущая дисперсия продолжает колебаться вокруг теоретического ожидания 2,92? Он не совсем сходится уже после 250 бросков, но если мы продолжим увеличивать количество бросков, в конце концов он сойдётся.

Суть в том, что по мере приближения распределения относительной частоты выборки к теоретическому распределению вероятностей, из которого она была взята, дисперсия выборки будет приближаться к теоретической дисперсии распределения.

Среднее значение и дисперсия функций случайных величин

Этот раздел был добавлен к сообщению 7 ноября 2020 года.

В заключение этого поста я хочу показать вам кое-что очень простое и интуитивно понятное, что будет полезно для вас во многих контекстах.

Теперь вы знаете общие формулы для вычисления среднего значения и дисперсии распределения вероятностей как для дискретных, так и для непрерывных случаев. Эти формулы работают с элементами выборочного пространства, связанными с распределением. Чтобы вычислить среднее значение, вы умножаете каждый элемент на его вероятность (и суммируете или интегрируете эти продукты). Точно так же для дисперсии вы умножаете квадрат разницы между каждым элементом и средним значением на вероятность элемента.

Теперь представьте, что вы берете выборочное пространство случайной величины X и передаете его некоторой функции. Назовем эту функцию g(x). Обратите внимание, что таким образом вы получаете новую случайную величину Y, которая имеет разные элементы в пространстве выборки. Например, если

и X = {1, 2, 3}, то Y = {1, 4, 9}.

Однако, несмотря на то, что значения различны, их вероятности будут идентичны вероятностям соответствующих им элементов в X:

Это означает, что вы можете рассчитать среднее значение и дисперсию Y, подставив вероятности X в формулы. Например, если мы придерживаемся примера и определим , формулы для среднего значения и дисперсии Y будут следующими:

И непрерывный случай аналогичен. Если у нас есть непрерывная случайная величина X с функцией плотности вероятности f(x), то для любой функции g(x):

Еще один пример броска кубика

Одним из применений того, что я вам только что показал, будет расчет среднего значения и дисперсии ваших ожидаемых денежных выигрышей/проигрышей, если вы делаете ставку на результаты случайной величины. Связь между результатами и их денежной стоимостью будет представлена функцией.

Например, кто-то предлагает вам следующую игру. Вы бросите обычный шестигранный кубик со сторонами, помеченными 1, 2, 3, 4, 5 и 6. Если выпадет нечетное число, вы выиграете сумму (в долларах), равную кубу выпавшего числа. количество. А если это четное число, вы теряете квадрат числа. Мы можем представить эти выплаты следующей функцией:

Используя среднюю формулу:

Для применения формулы дисперсии, давайте первым рассчитаем различия в квадрате, используя среднее значение.

Теперь давайте применим формулу:

Обратите внимание, что я не ввел никаких единиц измерения, потому что технически дисперсия должна быть выражена в «долларах в квадрате», что немного сбивает с толку.

Резюме

Одной из моих целей в этом посте было показать фундаментальную взаимосвязь между следующими понятиями из теории вероятностей:

И что еще более важно, разница между конечным и бесконечным населением. Я попытался донести интуицию, что в некотором смысле распределение вероятностей представляет собой бесконечную совокупность значений, извлеченных из него. И что среднее значение и дисперсия распределения вероятностей по сути являются средним значением и дисперсией этой бесконечной совокупности.

И что еще более важно, разница между конечным и бесконечным населением. Я попытался донести интуицию, что в некотором смысле распределение вероятностей представляет собой бесконечную совокупность значений, извлеченных из него. И что среднее значение и дисперсия распределения вероятностей по сути являются средним значением и дисперсией этой бесконечной совокупности.Другими словами, это теоретическое ожидаемое среднее значение и дисперсия выборки распределения вероятностей, когда размер выборки приближается к бесконечности.

Основной вывод из этого поста — формулы среднего и дисперсии для конечных наборов значений по сравнению с их вариантами для дискретных и непрерывных распределений вероятностей. Надеюсь, мне удалось дать вам хорошее интуитивное представление о связи между ними. Давайте еще раз посмотрим на эти формулы.

Вот формулы для среднего:

Конечный набор N значений Дискретное распределение вероятностей с N возможными исходами Непрерывное распределение вероятностейА вот формулы для дисперсии:

Конечный набор N значений Дискретное распределение вероятностей с N возможными исходами Непрерывное распределение вероятностей Возможно потратьте некоторое время, чтобы сравнить эти формулы, чтобы убедиться, что вы видите связь между ними.

2 \cdot 0,3 = 260 $

2 \cdot 0,3 = 260 $ 2 \cdot 0,25 = 40 500 000 $

2 \cdot 0,25 = 40 500 000 $

Т.к.

среднекв отклон = квадратному корню из

дисперсии,то размерность сигма(Х)

совпадает с размерностью Х.Поэтому в

тех случаях,когда желательно,чтобы

оценка рассеяния имела размерность

случ велич,вычисляют среднекв отклон,а

не дисперсию.

Т.к.

среднекв отклон = квадратному корню из

дисперсии,то размерность сигма(Х)

совпадает с размерностью Х.Поэтому в

тех случаях,когда желательно,чтобы

оценка рассеяния имела размерность

случ велич,вычисляют среднекв отклон,а

не дисперсию.

Мат

ожид и дисперсия = лямбда

Мат

ожид и дисперсия = лямбда

В зависимости от параметров

аист

нормальное распределение может называться

немного по-разному. Общим

называется нормальное распределение

с произвольными параметрами м и

сигма (сигма>0)

В зависимости от параметров

аист

нормальное распределение может называться

немного по-разному. Общим

называется нормальное распределение

с произвольными параметрами м и

сигма (сигма>0)

1. это еще один

преимущество изучения этих именованных дистрибутивов!

1. это еще один

преимущество изучения этих именованных дистрибутивов! Используйте это вместе с сокращенной формулой (28.2).)

Используйте это вместе с сокращенной формулой (28.2).)