Как вычислять математическое ожидание? | Математическое ожидание в ставках на спорт

Заложенное в ставке математическое ожидание является отображением ожидаемого (среднего) размера выигрыша по этой ставке, а потому вычисление этого показателя представляет огромную важность для игрока при сравнении коэффициентов букмекеров. Как вычислять математическое ожидание ставок на спорт для прогнозирования выигрышей? Читайте дальше и узнайте ответ на этот вопрос.

Математическое ожидание

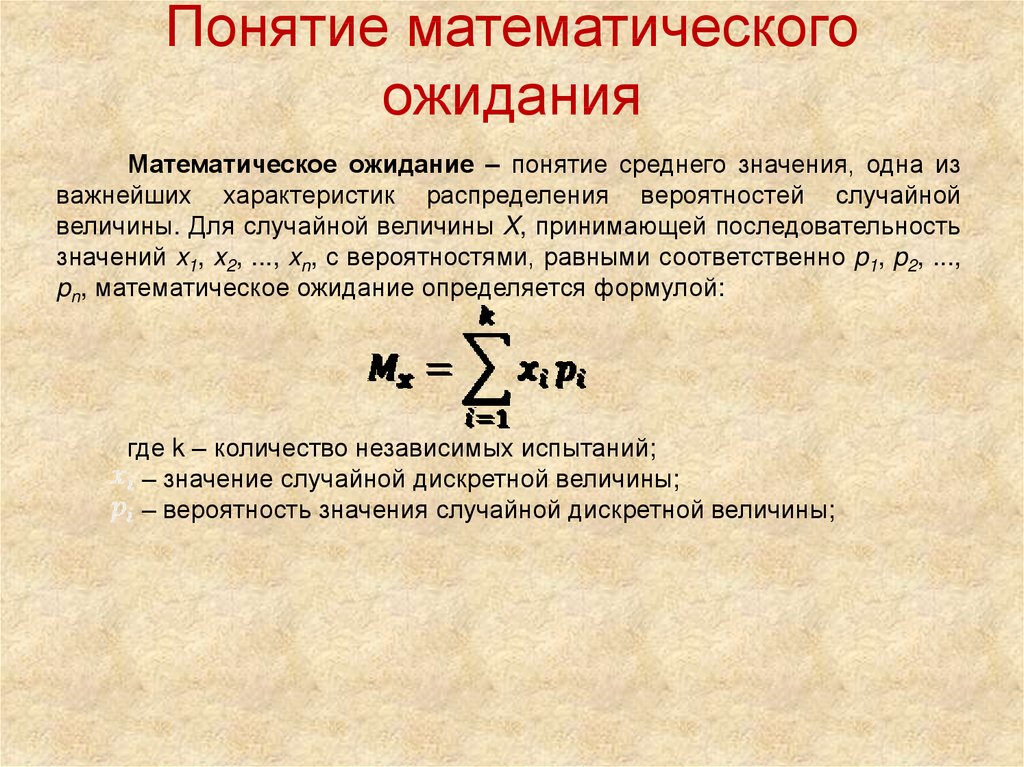

Сумма, которую игрок может выиграть или проиграть при многократном размещении ставки с одинаковым коэффициентом. Для ее расчета используется простая формула: необходимо умножить значение вероятности выигрыша на сумму, которую можно выиграть по ставке, и вычесть вероятность проигрыша, умноженную на сумму, которую можно проиграть на одной ставке.

Словарь терминов►

Вот простой пример математического ожидания, реализованный на практике. Если вы ставите 10 долл. США на выпадение орла при броске монеты и каждый раз в случае выигрыша будете получать 11 долл. США, то математическое ожидание будет равняться 0,5.

США, то математическое ожидание будет равняться 0,5.

Это означает, что если вы все время будете ставить на орла, то, как ожидается, в среднем размер вашего выигрыша по каждой ставке в 10 долл. США составит 0,50 долл. США.

Как вычислить математическое ожидание?

Формула вычисления математического ожидания сравнительно проста. Умножьте вероятность выигрыша на сумму, которую можно выиграть по ставке, и вычтите вероятность проигрыша, умноженную на сумму, которую можно проиграть на одной ставке.

(Вероятность выигрыша) x (сумма выигрыша по ставке) − (вероятность проигрыша) x (сумма проигрыша по ставке).

Для вычисления математического ожидания ставок на спорт в эту формулу можно подставлять десятичные коэффициенты и выполнить следующие расчеты.

- Рассчитайте десятичные коэффициенты для каждого варианта исхода (победа, поражение или ничья).

- Вычислите размер потенциальных выигрышей для каждого результата. Для этого умножьте сумму ставки на десятичный коэффициент и вычтите сумму ставки.

- Чтобы вычислить вероятность того или иного результата, разделите 1 на коэффициент этого результата.

- Подставьте эти данные в указанную формулу.

Например, если бы команда Manchester United (1,263) играла против команды Wigan (13,500) с коэффициентом на ничью 6,500, ставка в размере 10 долл. США на победу Wigan принесла бы игроку 125 долл. США, а вероятность выигрыша ставки составила бы 0,074 или 7,4 %.

Вероятность иного исхода составляет сумму вероятностей победы Man Utd и ничьей, или 0,792 + 0,154 = 0,946. Сумма проигрыша по каждой ставке равна сумме первоначальной ставки (10 долл. США). Следовательно, итоговая формула будет выглядеть так:

(0,074 x 125 долл. США) – (0,946 x 10 долл. США) = –0,20 долл. США

Математическое ожидание для этой ставки является отрицательным, а из этого следует, что в среднем размер проигрыша по каждой ставке 10 долл. США составит 0,20 долл. США.

В чем заключается польза математического ожидания при размещении ставок на спорт?

Помните: отрицательное математическое ожидание ставки не означает, что ставка проиграет. В отличие от примера с подбрасыванием монеты, коэффициенты спортивных ставок субъективны по своей сути. Если вы сумеете перехитрить букмекера, то вам, возможно, удастся заработать.

В отличие от примера с подбрасыванием монеты, коэффициенты спортивных ставок субъективны по своей сути. Если вы сумеете перехитрить букмекера, то вам, возможно, удастся заработать.

Если вычисленная вами вероятность того или иного результата игры отличается от предполагаемой вероятности, заложенной в коэффициенты, вы сможете определить ставку с положительным математическим ожиданием и повысить шансы на выигрыш.

Например, коэффициенты указывают на то, что вероятность победы команды Wigan составляет всего 7,4 %. Если результаты ваших вычислений (для которых вы, возможно, использовали систему, похожую на распределение Пуассона) указывают на то, что вероятность победы Wigan равна 10 %, то математическое ожидание для ставки на эту команду увеличивается до 3,262 долл. США.

Помимо этого, математическое ожидание является идеальным средством сравнения коэффициентов арбитражных ставок, речь о которых идет в нашей статье Что такое арбитражные ставки?.

Благодаря вычислению математического ожидания ставок игроки получают дополнительную информацию о ценности предложений своего букмекера. Математическое ожидание у букмекеров, предлагающих низкие размеры маржи (например, Пиннакл), составляет примерно −0,20 долл. США. Как правило, среднестатистические букмекерские компании принимают ставки с математическим ожиданием −1,00 долл. США, и это значит, что вероятный проигрыш по каждой ставке суммой 10 долл. США составляет 1 долл. США.

Математическое ожидание у букмекеров, предлагающих низкие размеры маржи (например, Пиннакл), составляет примерно −0,20 долл. США. Как правило, среднестатистические букмекерские компании принимают ставки с математическим ожиданием −1,00 долл. США, и это значит, что вероятный проигрыш по каждой ставке суммой 10 долл. США составляет 1 долл. США.

Обобщённые линейные модели

Мотивация

До сих пор мы рассматривали в основном модели вида

$$y\sim f(x) + \varepsilon$$

с шумом $\varepsilon$ из того или иного распределения. Но у этих моделей (а) шум не зависит от $x$ и (б) $y$ может принимать любые значения. А что, если мы захотим предсказывать время ожидания доставки? Казалось бы, чем дольше время потенциального ожидания, тем больше его дисперсия. А как корректно предсказывать таргет, который принимает только целые значения?

Один из подходов мы обсудим в этой главе. Грубо говоря, вместо того, чтобы прибавлять один и тот же шум, мы зафиксируем семейство распределений $p(y\vert\mu(x))$, в котором изменяемым параметром будет зависящее от $x$ математическое ожидание $\mu(x)$. {-1}(\sigma(\langle x, w\rangle)) = \langle x, w\rangle$.

{-1}(\sigma(\langle x, w\rangle)) = \langle x, w\rangle$.

Обобщая, можно сказать, что, если данные таковы, что $\mathbb E(Y \vert X)$ не является линейной функцией от $x$, мы линеаризуем $\mathbb E(Y \vert X)$ с помощью функции связи $g$.

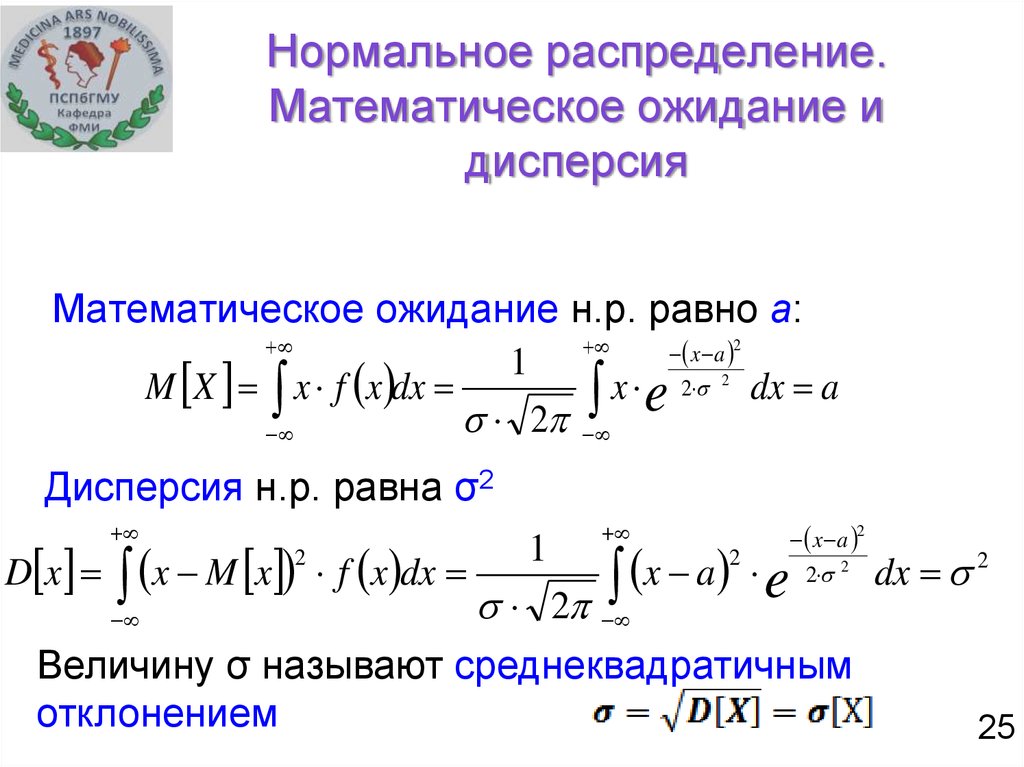

Замечание: Вообще говоря, нормальное распределение определяется не только своим математическим ожиданием, но и стандартным отклонением. То есть, в отличие от логистической регрессии, модель линейной регрессии не позволяет для данного $x$ оценить все параметры распределения $y \vert x$, и дисперсию приходится фиксировать изначально. К счастью, выбор её значения в нормальном распределении не влияет ни на оптимальный вектор весов $w$, ни на итоговые предсказания $\mathbb E(Y \vert X)$, которые выдаёт обученная модель.

Задав эти две составляющие – параметризованное семейство распределений и функцию связи – мы получим обобщённую линейную модель (GLM). Для нового объекта $x$ она выдаст предсказание $\widehat{y} = \mathbb{E}(y\vert x) = g^{-1}(\langle x, w\rangle)$, а выбор класса распределений $y \vert x$ потребуется нам для подбора весов $w$. В принципе, можно выбрать любой класс распределений $y \vert x$ и любую монотонную функцию связи $g$, получив некоторую вероятностную модель. Однако обычно для упрощения поиска оптимальных весов $w$ в GLM предполагают, что $y \vert x$ принадлежит одному из достаточно простых семейств экспоненциального класса.

В принципе, можно выбрать любой класс распределений $y \vert x$ и любую монотонную функцию связи $g$, получив некоторую вероятностную модель. Однако обычно для упрощения поиска оптимальных весов $w$ в GLM предполагают, что $y \vert x$ принадлежит одному из достаточно простых семейств экспоненциального класса.

Что даёт нам принадлежность экспоненциальному классу?

В контексте GLM обычно рассматривают подкласс экспоненциального класса, состоящий из семейств, представимых в виде

$$\color{#348FEA}{p(y \vert \theta, \phi) = \exp\left(\frac{y\theta — a(\theta)}{\phi} + b(y, \phi)\right)}$$

где $\theta$ и $\phi$ – скалярные параметры, причём $\phi$ – нечто фиксированное, чаще всего дисперсия, которая чаще всего полагается равной $1$, а значения $\theta$ параметризуют распределения из семейства. Нетрудно переписать плотность в более привычном для нас виде, чтобы стало очевидно, что это семейство действительно из экспоненциального класса:

$$p(y \vert \theta, \phi) = \frac1{\exp\left(\frac{a(\theta)}{\phi}\right)}\exp(b(y,\phi))\exp\left(\frac{y\theta}{\phi}\right)$$

Действительно, если вспомнить, что $\varphi$ – это константа, а не параметр, то получается очень похоже на

$$p(y\vert\nu) = \frac1{h(\nu)}g(y)\cdot\exp\left(\nu^Tu(y)\right)$$

В частности, мы видим, что $u(y)$ состоит из единственной компоненты $u_1(y)$, равной $\frac{y}{\phi}$. {-1}(\mathbb{E}(y\vert x))$.

{-1}(\mathbb{E}(y\vert x))$.

Пример 3. Хорошо, про линейную и логистическую регрессию мы и так знали. Давайте попробуем решить с помощью GLM новую задачу. Пусть мы хотим по каким-то признакам $X$ предсказать количество «лайков», которое пользователи поставят посту в социальной сети за первые 10 минут после публикации. Конечно, можно использовать для этого линейную регрессию. Однако предположение линейной регрессии, что $Y \vert X\sim\mathcal N$, в данном случае странное по нескольким причинам. Во-первых, количество лайков заведомо не может быть отрицательным, а нормальное распределение всегда будет допускать ненулевую вероятность отрицательного значения. Во-вторых, количество лайков – всегда целое число. В-третьих, у распределения количества лайков, скорее всего, положительный коэффициент асимметрии (skewness). То есть, если модель предсказывает, что под постом будет 100 лайков, мы скорее можем ожидать, что под ним окажется 200 лайков, чем 0. {-1}$ не симметричен. Можно сказать, что модель, основанная на функции связи cloglog, похожа на логистическую регрессию в области точек, уверенно отнесённых к нулевому классу, но с уменьшением этой уверенности они приписываются близкие к единице вероятности всё «охотнее».

{-1}$ не симметричен. Можно сказать, что модель, основанная на функции связи cloglog, похожа на логистическую регрессию в области точек, уверенно отнесённых к нулевому классу, но с уменьшением этой уверенности они приписываются близкие к единице вероятности всё «охотнее».

Эта функция связи может оказаться полезной, если объекты положительного класса редки (обнаружение редких событий).

Что такое ожидаемое значение?. Интуитивное объяснение ожидаемого… | by Devin Soni

Интуитивное объяснение ожидаемого значения на простых примерах с использованием игр

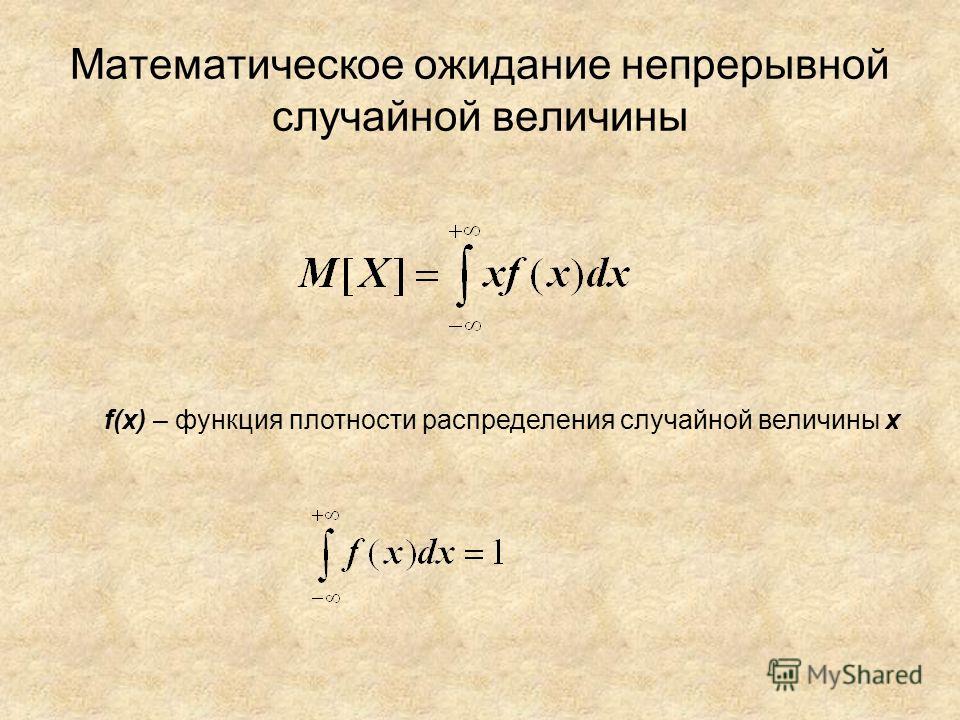

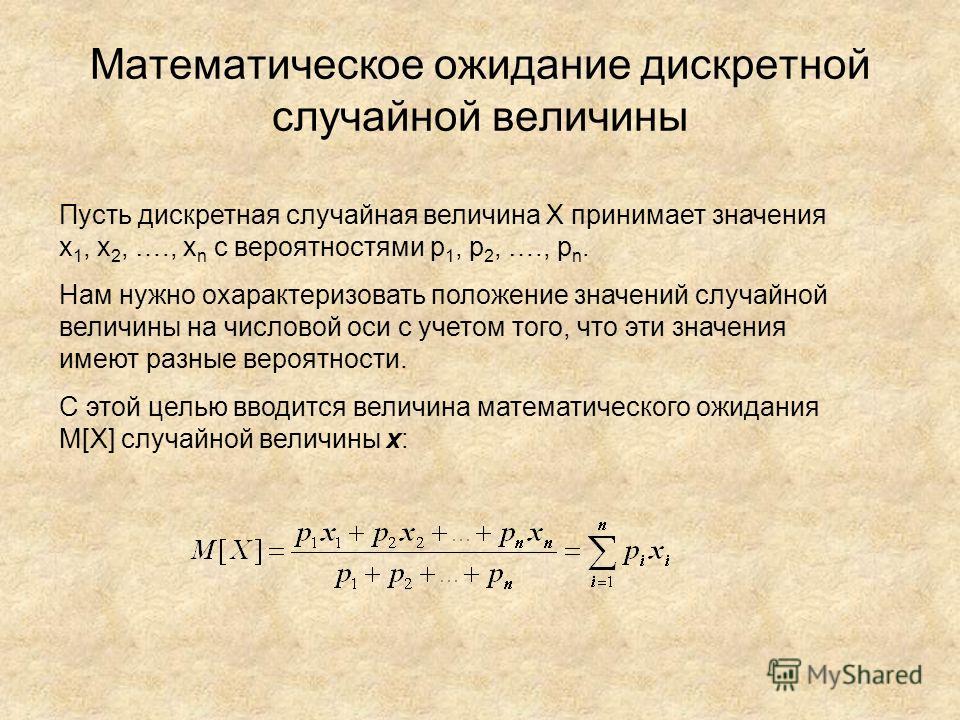

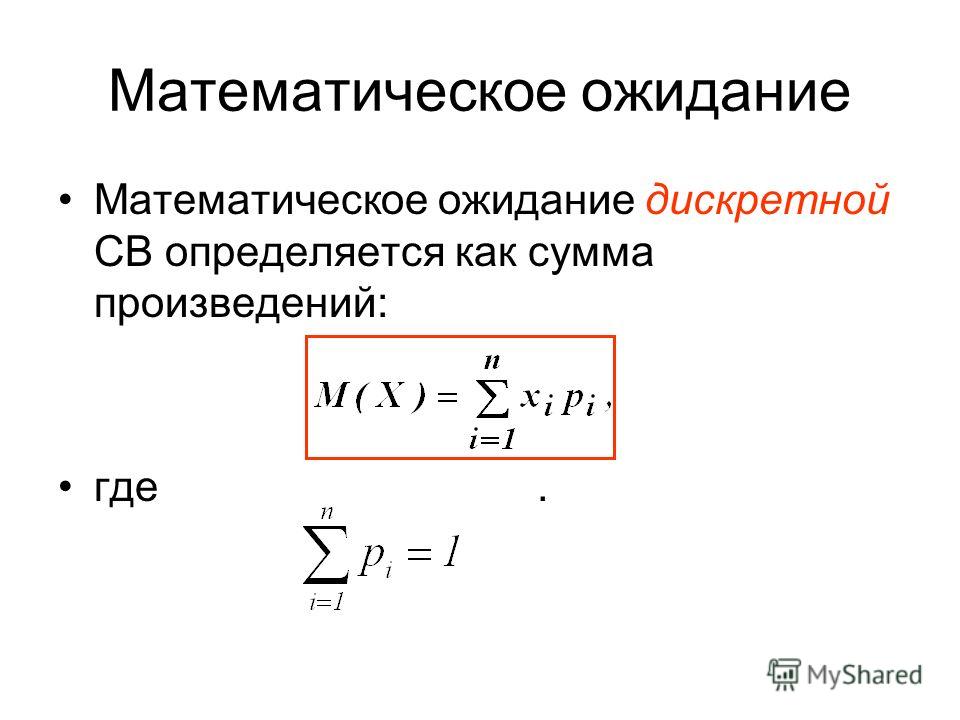

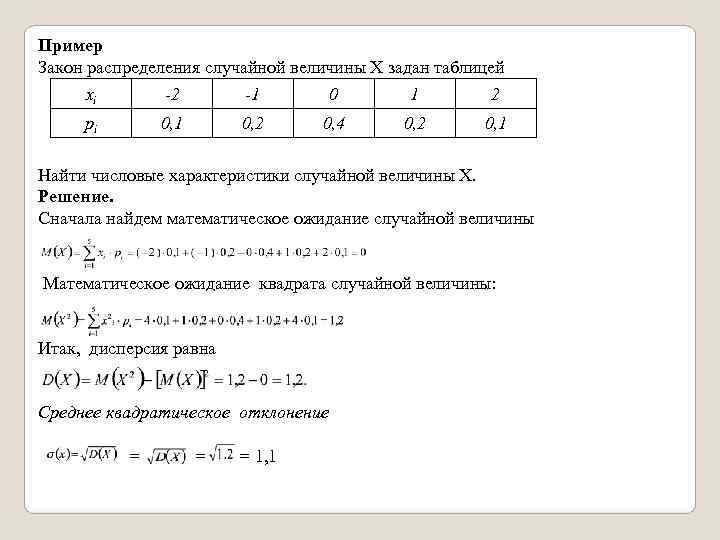

Ожидаемое значение — это среднее значение случайной величины по большому количеству экспериментов. Случайная переменная сопоставляет числовые значения с каждым возможным исходом эксперимента. Мы можем рассчитать ожидаемое значение для дискретной случайной величины — такой, в которой количество потенциальных исходов исчислимо, — взяв сумму, в которой каждый член представляет собой возможное значение случайной величины, умноженное на вероятность этого исхода. Так, например, если бы нашей случайной величиной было число, полученное путем броска правильного трехгранного кубика, ожидаемое значение было бы (1 * 1/3) + (2 * 1/3) + (3 * 1/3). = 2,

Так, например, если бы нашей случайной величиной было число, полученное путем броска правильного трехгранного кубика, ожидаемое значение было бы (1 * 1/3) + (2 * 1/3) + (3 * 1/3). = 2,

Если мы предположим, что эксперимент представляет собой игру, случайная величина сопоставляет результаты игры с суммами выигрышей, и ее ожидаемое значение, таким образом, представляет ожидаемый средний выигрыш в игре. Поскольку ожидаемое значение охватывает реальные числа, оно обычно делится на числа с отрицательным, нейтральным и положительным значением. Игры с каждым типом ожидаемого значения часто встречаются в сценариях реальной жизни, поэтому ожидаемое значение обеспечивает простую эвристику для принятия решений.

Чтобы проиллюстрировать каждый тип игры, я буду использовать 3 похожих примера, связанных с подбрасыванием монеты, поэтому, чтобы быть точным, случайной величиной в каждом сценарии является ожидаемый выигрыш от однократного подбрасывания монеты. Предположим, что в каждом случае монета честная, поэтому орел и решка равновероятны с вероятностью 1/2.

Нейтральные игры с ожидаемой стоимостью

Вы подбрасываете правильную монету. Каждый раз, когда выпадает орел, вы теряете 1 доллар, а каждый раз, когда выпадает решка, вы получаете 1 доллар.

Ожидаемое значение в этом сценарии равно (-1 * 1/2) + (1 * 1/2) = 0. Таким образом, поскольку монета честная, а сумма проигрыша равна сумме выигрыша, ожидается, что вы не получите ни прибыли, ни прибыли. ни потерять деньги с течением времени. В такой игре нет причин играть, но нет и причин не играть. Таким образом, игры такого типа идеально подходят для простого развлечения, например, с «камень-ножницы-бумага», в которой случайный выбор хода является оптимальной стратегией с ожидаемым выигрышем 0,9.0005

Игры с положительным ожидаемым значением

Вы подбрасываете правильную монету. Каждый раз, когда выпадает орел, вы теряете 1 доллар, а каждый раз, когда выпадает решка, вы получаете 2 доллара.

Ожидаемое значение в этом сценарии (-1 * 1/2) + (2 * 1/2) = 1/2. Поскольку орел и решка равновероятны, больший выигрыш от решки перевешивает потерю от орла. В такой игре вы должны зарабатывать деньги с течением времени, поэтому вы должны играть в этот тип игры. Сценарии такого типа появляются во многих реальных решениях, таких как инвестирование в фондовый рынок (рынки находятся в общем восходящем тренде с течением времени), подготовка к экзамену (несколько часов потерянного времени перевешиваются более высоким средним баллом), или подготовка к собеседованию (несколько недель потерянного времени перевешиваются преимуществами лучшей работы).

Поскольку орел и решка равновероятны, больший выигрыш от решки перевешивает потерю от орла. В такой игре вы должны зарабатывать деньги с течением времени, поэтому вы должны играть в этот тип игры. Сценарии такого типа появляются во многих реальных решениях, таких как инвестирование в фондовый рынок (рынки находятся в общем восходящем тренде с течением времени), подготовка к экзамену (несколько часов потерянного времени перевешиваются более высоким средним баллом), или подготовка к собеседованию (несколько недель потерянного времени перевешиваются преимуществами лучшей работы).

Игры с отрицательным ожидаемым значением

Вы подбрасываете правильную монету. Каждый раз, когда выпадает орел, вы теряете 1 доллар, а каждый раз, когда выпадает решка, вы получаете 1 доллар. Кроме того, за каждый бросок взимается комиссия в размере 0,01 доллара США независимо от результата.

Ожидаемое значение в этом сценарии (-1,01 * 1/2) + (0,99 * 1/2) = -0,01. Таким образом, несмотря на то, что сама монета является честной, а сумма проигрыша равна сумме выигрыша, постоянная комиссия приводит к тому, что игра является игрой с отрицательным значением. Ожидается, что в такой игре вы со временем потеряете деньги, поэтому вам не следует играть в этот тип игры. Это характерно для многих игорных платформ, где казино изначально предоставляет нейтральную игру, но затем взимает комиссию, которая нарушает нейтральность игры (отсюда поговорка, что «казино всегда побеждает»).

Ожидается, что в такой игре вы со временем потеряете деньги, поэтому вам не следует играть в этот тип игры. Это характерно для многих игорных платформ, где казино изначально предоставляет нейтральную игру, но затем взимает комиссию, которая нарушает нейтральность игры (отсюда поговорка, что «казино всегда побеждает»).

Заключение

Рассмотрение решений с точки зрения ожидаемой ценности — это простой способ решить, есть ли экономическая причина для участия в той или иной деятельности. Конечно, существуют и другие способы измерения полезности, кроме чисто экономического вознаграждения, поэтому ожидаемая выгода не является надежным инструментом для принятия решений. Кроме того, имейте в виду, что математическое ожидание работает для большого количества повторных испытаний, так что это может привести к искаженному представлению об определенных событиях, в которых некоторые возможности встречаются очень редко. Например, рассмотрим выигрыш в лотерею. Вполне возможно, что это возможность с положительной ожидаемой ценностью, но вероятность того, что вы действительно реализуете эту ценность в течение своей конечной жизни, настолько низка, что, возможно, не стоит покупать лотерейные билеты.

Урок 26 Линейность ожидания

Теория

В этом уроке мы изучим сокращенный способ расчета ожидаемых значений формы \[ Е[аХ + ЬУ]. \] В общем, оценивая ожидаемые значения функций случайных величин требуется ЛОТОС. Но когда функция линейна, мы можем разбить ожидаемую ценность на более управляемые части.

Теорема 26.1 (Сложение или умножение константы) Пусть \(X\) — случайная величина, а \(a, b\) — константы. Затем, \[\начать{выравнивать} E[aX] &= aE[X] \tag{26.1} \\ E[X + b] &= E[X] + b \tag{26.2} \конец{выравнивание}\]

Доказательство. Поскольку \(aX\) и \(X+b\) технически являются функциями \(X\), мы используем

ЛОТОС (24.1).

\[\начать{выравнивать*}

E[aX] &= \sum_x ax f(x) & \text{(LOTUS)} \\

&= a \sum_x x f(x) & \text{(фактор-константа вне суммы)} \\

&= a E[X] & \text{(определение ожидаемого значения)}. \\

E[X+b] &= \sum_x (x + b) f(x) & \text{(LOTUS)} \\

&= \sum_x x f(x) + \sum_x b f(x) & \text{(разбить $(x + b) f(x)$ на $xf(x) + bf(x)$)} \\

&= \sum_x x f(x) + b\sum_x f(x) & \text{(фактор-константа вне суммы)} \\

&= E[X] + b & \text{(определения ожидаемого значения, p.

Вот пример, иллюстрирующий, как можно использовать теорему 26.1.

Пример 26.1 (Ожидаемые значения в рулетке) В рулетке ставки на одно число оплачиваются 35 к 1. То есть за каждый поставленный доллар вы выигрываете. 35 долларов, если мяч попадет в эту лузу.

Если мы позволим \(X\) представлять ваш чистый выигрыш (или проигрыш) по этой ставке, ее p.m.f. является \[ \begin{array}{r|cc} x & -1 & 35 \\ \hline f_X(x) & 37/38 & 1/38 \end{массив}. \]

В уроке 22 мы вычисляли \(E[X]\) напрямую. Вот еще один способ

мы можем вычислить его, используя теорему 26.1. Определим новую случайную величину

\(W\), который принимает значения 0 и 1 с одинаковыми вероятностями:

\[ \begin{array}{r|cc} w & 0 & 1 \\ \hline f_W(w) & 37/38 & 1/38 \end{массив}. \]

Мы можем думать о \(W\) как о индикатор переменная для того, выиграем мы или нет.

Легко видеть, что \(E[W] = 1/38\). (Один из способов — просто использовать формулу.

Теперь сумма нашего выигрыша, \(X\), связана с этой переменной индикатора, \(W\), следующим образом: \[Х = 36 Вт — 1. \] (Убедитесь, что \(X\) принимает значения \(35\) и \(-1\) с правильными вероятностями.) Теперь по теореме 26.1 математическое ожидание равно \[ E[X] = E[36W — 1] = 36 E[W] — 1 = 36 \left( \frac{1}{38} \right) — 1 = -\frac{2}{38}, \] что соответствует тому, что мы получили в Уроке 22.

Следующий результат еще полезнее.

Теорема 26.2 (Линейность ожидания) Пусть \(X\) и \(Y\) — случайные величины. Тогда независимо от их совместного распределения , \[\начало{уравнение} Е[Х+У] = Е[Х] + Е[У]. \тег{26.3} \end{equation}\]

Доказательство. Поскольку в \(E[X + Y]\) входят две случайные величины, мы должны оценить математическое ожидание

используя 2D LOTUS (25. 1) с \(g(x, y) = x + y\). Предполагать

что совместное распределение \(X\) и \(Y\) равно \(f(x, y)\). Затем:

\[\начать{выравнивать*}

E[X + Y] &= \sum_x \sum_y (x + y) f(x, y) & \text{(2D LOTUS)} \\

&= \sum_x \sum_y x f(x, y) + \sum_x \sum_y y f(x, y) & \text{(разбить $(x + y) f(x, y)$ на $x f(x, y) + у f(x, y)$)} \\

&= \sum_x x \sum_y f(x, y) + \sum_y y \sum_x f(x, y) & \text{(переместить член за пределы внутренней суммы)} \\

&= \sum_x x f_X(x) + \sum_y y f_Y(y) & \text{(определение предельного распределения)} \\

&= E[X] + E[Y] & \text{(определение ожидаемого значения)}.

\end{выравнивание*}\]

1) с \(g(x, y) = x + y\). Предполагать

что совместное распределение \(X\) и \(Y\) равно \(f(x, y)\). Затем:

\[\начать{выравнивать*}

E[X + Y] &= \sum_x \sum_y (x + y) f(x, y) & \text{(2D LOTUS)} \\

&= \sum_x \sum_y x f(x, y) + \sum_x \sum_y y f(x, y) & \text{(разбить $(x + y) f(x, y)$ на $x f(x, y) + у f(x, y)$)} \\

&= \sum_x x \sum_y f(x, y) + \sum_y y \sum_x f(x, y) & \text{(переместить член за пределы внутренней суммы)} \\

&= \sum_x x f_X(x) + \sum_y y f_Y(y) & \text{(определение предельного распределения)} \\

&= E[X] + E[Y] & \text{(определение ожидаемого значения)}.

\end{выравнивание*}\]

Другими словами, линейность ожидания говорит о том, что вам нужно знать только маргинальные распределения \(X\) и \(Y\) для вычисления \(E[X + Y]\). Их совместное распространение не имеет значения.

Давайте применим это к задаче Ксавьера и Иоланды из Урока 18.

Пример 26.2 (Ксавьер и Иоланда снова) Ксавьер и Иоланда направляются к столу с рулеткой в казино. Они оба делают ставки на красное на 3 вращениях рулетки.

колесо, прежде чем Ксавье придется уйти. После ухода Ксавьера Иоланда делает ставки на красное еще на 2 вращения колеса.

Пусть \(X\) будет количеством ставок, которые выиграет Ксавьер, а \(Y\) будет числом, которое выиграет Иоланда.

Они оба делают ставки на красное на 3 вращениях рулетки.

колесо, прежде чем Ксавье придется уйти. После ухода Ксавьера Иоланда делает ставки на красное еще на 2 вращения колеса.

Пусть \(X\) будет количеством ставок, которые выиграет Ксавьер, а \(Y\) будет числом, которое выиграет Иоланда.

В уроке 25 мы подсчитали \(E[Y — X]\), ожидаемое число дополнительных раз, когда Иоланда выиграет, путем нанесения 2D LOTUS на сустав p.m.f. из \(X\) и \(Y\). Расчет был утомительным.

В этом уроке мы видим, как линейность ожидания позволяет нам избежать утомительных вычислений. Первый,

в силу (26.1) и (26.3) мы видим, что:

\[ E[Y — X] = E[Y] + E[-1 \cdot X] = E[Y] + (-1) E[X] = E[Y] — E[X]. \]

Мы знаем, что \(Y\) равно \(\text{Биномиальное}(n=5, N_1=18, N_0=20)\), а \(X\) равно \(\text{Биномиальное}(n=3, N_1=18, N_0=20)\).

\(X\) и \(Y\) определенно не являются независимыми, поскольку три ставки Иоланды идентичны ставкам Ксавьера.

Но линейность ожидания говорит о том, что для вычисления \(E[Y — X]\) не имеет значения, каковы \(X\) и \(Y\)

связанные друг с другом; нам нужны только их маргинальные распределения.

Из Приложения A.1 (и урока 22) мы знаем, что ожидаемое значение биномиальной случайной величины равно \(n\frac{N_1}{N}\), поэтому \[ E[Y — X] = E[Y] — E[X] = 5\frac{18}{38} — 3\frac{18}{38} = 2\frac{18}{38} \приблизительно .947, \] что соответствует ответу, который мы получили в Уроке 25, применив 2D LOTUS.

Линейность позволяет вычислить ожидаемые значения сложных случайных величин путем разбиения их на более простые случайные величины.

Пример 26.3 (ожидаемое значение биномиального и гипергеометрического распределений) На уроке 22 мы показали, что ожидаемые значения биномиального и гипергеометрического распределения одинаковы: \(n\frac{N_1}{N}\). Но доказательства, которые мы давали, были утомительны и не давали никакого понимания. почему эта формула верна. Докажем эту формулу, используя линейность математических ожиданий.

Если \(X\) является \(\text{биномиальной}(n, N_1, N_0)\) случайной величиной, то мы можем разбить \(X\) на сумму

из более простых случайных величин:

\[ X = Y_1 + Y_2 + \ldots + Y_n, \]

где \(Y_i\) представляет результат \(i\)-го розыгрыша из коробки.

По линейности ожидания: \[ E[X] = E[Y_1] + E[Y_2] + \ldots + E[Y_n]. \] Мы взяли сложную случайную величину \(X\) и разбили ее на более простые случайные величины \(Y_i\), ожидаемое значение которого легко вычислить: \[ E[Y_i] = 0 \cdot \frac{N_0}{N} + 1 \cdot \frac{N_1}{N} = \frac{N_1}{N}. \] Следовательно, \[ E[X] = \underbrace{\frac{N_1}{N} + \frac{N_1}{N} + \ldots + \frac{N_1}{N}}_{\text{$n$ terms} } = n \frac{N_1}{N}. \]

Что, если \(X\) является \(\text{гипергеометрической}(n, N_1, N_0)\) случайной величиной? Мы можем разбить \(X\) точно так же, как

сумма исходов каждого розыгрыша:

\[ X = Y_1 + Y_2 + \ldots + Y_n, \]

за исключением того, что теперь \(Y_i\) не являются независимыми.

Кроме того, линейность ожидания не зависит от того, независимы ли случайные величины. Таким образом, ожидаемое значение гипергеометрический также: \[ E[X] = \underbrace{\frac{N_1}{N} + \frac{N_1}{N} + \ldots + \frac{N_1}{N}}_{\text{$n$ terms} } = n \frac{N_1}{N}. \]

Вот умное применение линейности.

Пример 26.4 Пусть \(X\) — \(\text{биномиальная}(n, N_1, N_0)\) случайная величина. Что такое \(Е[Х(Х-1)]\)? В примере 24.3 мы рассчитали ожидаемое значение с помощью LOTUS. Вот способ расчета с использованием линейности.

Помните, что \(X\) представляет количество \(\fbox{1}\) в нашей выборке.

Затем случайная величина \(X(X-1)\) представляет количество (упорядоченных) способов выбора

два билета из \(\fbox{1}\) в нашем примере. На приведенной ниже диаграмме

\(n=4\) и \(X=3\).

Определим индикаторную переменную \(Y_{ij}, i\neq j\) для каждого из \(n(n-1)\) способов выбора двух билетов из нашей выборки. Пусть \(Y_{ij}\) равно 1, если билеты \(i\) и \(j\) оба являются \(\fbox{1}\)s. Другими словами, \(Y_{ij} = 1\) тогда и только тогда, когда есть красная стрелка соединение двух билетов на диаграмме выше. 92}, \] что соответствует ответу, полученному в уроке 24, но более утомительным способом.

Основная практика

Каждый год в рамках традиции «Тайный Санта» группа из 4 друзей пишет свои имена на листочках бумаги и ставит скользит в шапку. Каждый член группы случайным образом вытягивает имя из шляпы и должен подарить этому человеку подарок. Конечно, возможно, что они рисуют свое имя, в таком случае они покупают себе подарок.

Каково ожидаемое количество людей, которые нарисуют свое имя?

Каково ожидаемое количество людей, которые нарисуют свое имя?Подсказка: Выразите эту сложную случайную величину в виде суммы индикаторных случайных величин (т. е. которые принимают только значения 0 или 1) и используйте линейность ожидания.

McDonald’s решает дарить игрушку покемона с каждым Хэппи Милом. Каждый раз, когда вы покупаете Хэппи Мил, вы в равной степени Вероятность получения любого из 6 типов покемонов. Каково ожидаемое количество Happy Meals, которое вы должны купить пока не «поймаешь их всех»?

Подсказка: Выразите эту сложную случайную величину в виде суммы геометрических случайных величин, и использовать линейность ожидания.

Группа из 60 человек сравнивает свои дни рождения (как обычно, предположим, что их дни рождения независимы, все 365 дней равновероятны и т. д.). Найдите ожидаемое количество дней в год, когда родились не менее двух из этих людей.

Подсказка: Выразите эту сложную случайную величину в виде суммы индикаторных случайных величин и используйте линейность ожидания.

Дополнительная практика

Хеш-таблица — это широко используемая структура данных в информатике, позволяющая для быстрого поиска информации. Например, предположим, что мы хотим сохранить некоторые номера телефонов людей. Предположим, что нет двух людей с одинаковыми название. Для каждого имени \(x\) используется хэш-функция \(h\), где \(h(x)\) — это местоположение для хранения номера телефона x. После того, как такая таблица была вычислена, для поиска Номер телефона \(x\) просто пересчитывается \(h(x)\), а затем просматривается то, что сохранено. в этом месте.

Обычно \(h\) выбирается как (псевдо)случайное. Предположим, есть 100 человек, с номером телефона каждого человека, хранящимся в случайном месте (независимо), представлен целым числом от 1 до 1000. Тогда может случиться так, что один местоположение имеет более одного номера телефона, хранящегося там, если два разных человека \(x\) и \(y\) оказываются в одном и том же случайном месте для хранения своей информации.

Каково ожидаемое количество людей, которые нарисуют свое имя?

Каково ожидаемое количество людей, которые нарисуют свое имя?